diff --git a/docs/source/ja/_toctree.yml b/docs/source/ja/_toctree.yml

index 9766571c6b87eb..2859dd75bb3359 100644

--- a/docs/source/ja/_toctree.yml

+++ b/docs/source/ja/_toctree.yml

@@ -292,6 +292,14 @@

title: ConvBERT

- local: model_doc/cpm

title: CPM

+ - local: model_doc/cpmant

+ title: CPMANT

+ - local: model_doc/ctrl

+ title: CTRL

+ - local: model_doc/deberta

+ title: DeBERTa

+ - local: model_doc/deberta-v2

+ title: DeBERTa-v2

title: 文章モデル

- isExpanded: false

sections:

@@ -305,6 +313,10 @@

title: ConvNeXT

- local: model_doc/convnextv2

title: ConvNeXTV2

+ - local: model_doc/cvt

+ title: CvT

+ - local: model_doc/deformable_detr

+ title: Deformable DETR

title: ビジョンモデル

- isExpanded: false

sections:

@@ -337,7 +349,14 @@

title: CLIPSeg

- local: model_doc/clvp

title: CLVP

+ - local: model_doc/data2vec

+ title: Data2Vec

title: マルチモーダルモデル

+ - isExpanded: false

+ sections:

+ - local: model_doc/decision_transformer

+ title: Decision Transformer

+ title: 強化学習モデル

- isExpanded: false

sections:

- local: model_doc/autoformer

diff --git a/docs/source/ja/model_doc/cpmant.md b/docs/source/ja/model_doc/cpmant.md

new file mode 100644

index 00000000000000..ca1f65caa16c04

--- /dev/null

+++ b/docs/source/ja/model_doc/cpmant.md

@@ -0,0 +1,47 @@

+

+

+# CPMAnt

+

+## Overview

+

+CPM-Ant は、10B パラメータを備えたオープンソースの中国語の事前トレーニング済み言語モデル (PLM) です。これは、CPM-Live のライブ トレーニング プロセスの最初のマイルストーンでもあります。トレーニングプロセスは費用対効果が高く、環境に優しいものです。 CPM-Ant は、CUGE ベンチマークでのデルタ チューニングでも有望な結果を達成しています。フル モデルに加えて、さまざまなハードウェア構成の要件を満たすさまざまな圧縮バージョンも提供しています。 [詳細を見る](https://github.com/OpenBMB/CPM-Live/tree/cpm-ant/cpm-live)

+

+このモデルは [OpenBMB](https://huggingface.co/openbmb) によって提供されました。元のコードは [ここ](https://github.com/OpenBMB/CPM-Live/tree/cpm-ant/cpm-live) にあります。

+

+## Resources

+

+- [CPM-Live](https://github.com/OpenBMB/CPM-Live/tree/cpm-ant/cpm-live) に関するチュートリアル。

+

+## CpmAntConfig

+

+[[autodoc]] CpmAntConfig

+ - all

+

+## CpmAntTokenizer

+

+[[autodoc]] CpmAntTokenizer

+ - all

+

+## CpmAntModel

+

+[[autodoc]] CpmAntModel

+ - all

+

+## CpmAntForCausalLM

+

+[[autodoc]] CpmAntForCausalLM

+ - all

\ No newline at end of file

diff --git a/docs/source/ja/model_doc/ctrl.md b/docs/source/ja/model_doc/ctrl.md

new file mode 100644

index 00000000000000..9d3a620ffe42d1

--- /dev/null

+++ b/docs/source/ja/model_doc/ctrl.md

@@ -0,0 +1,113 @@

+

+

+# CTRL

+

+

+

+## Overview

+

+CTRL モデルは、Nitish Shirish Keskar*、Bryan McCann*、Lav R. Varshney、Caiming Xiong, Richard Socher によって [CTRL: A Conditional Transformer Language Model for Controllable Generation](https://arxiv.org/abs/1909.05858) で提案されました。

+リチャード・ソーチャー。これは、非常に大規模なコーパスの言語モデリングを使用して事前トレーニングされた因果的 (一方向) トランスフォーマーです

+最初のトークンが制御コード (リンク、書籍、Wikipedia など) として予約されている、約 140 GB のテキスト データ。

+

+論文の要約は次のとおりです。

+

+*大規模な言語モデルは有望なテキスト生成機能を示していますが、ユーザーは特定の言語モデルを簡単に制御できません

+生成されたテキストの側面。 16 億 3,000 万パラメータの条件付きトランスフォーマー言語モデルである CTRL をリリースします。

+スタイル、コンテンツ、タスク固有の動作を制御する制御コードを条件付けるように訓練されています。制御コードは

+生のテキストと自然に共生する構造から派生し、教師なし学習の利点を維持しながら、

+テキスト生成をより明示的に制御できるようになります。これらのコードを使用すると、CTRL でどの部分が予測されるのかを予測することもできます。

+トレーニング データにはシーケンスが与えられる可能性が最も高くなります。これにより、大量のデータを分析するための潜在的な方法が提供されます。

+モデルベースのソース帰属を介して。*

+

+このモデルは、[keskarnitishr](https://huggingface.co/keskarnitishr) によって提供されました。元のコードが見つかる

+[こちら](https://github.com/salesforce/ctrl)。

+

+## Usage tips

+

+- CTRL は制御コードを利用してテキストを生成します。生成を特定の単語や文で開始する必要があります。

+ またはリンクして一貫したテキストを生成します。 [元の実装](https://github.com/salesforce/ctrl) を参照してください。

+ 詳しくは。

+- CTRL は絶対位置埋め込みを備えたモデルであるため、通常は入力を右側にパディングすることをお勧めします。

+ 左。

+- CTRL は因果言語モデリング (CLM) の目的でトレーニングされているため、次の予測に強力です。

+ シーケンス内のトークン。この機能を利用すると、CTRL は構文的に一貫したテキストを生成できるようになります。

+ *run_generation.py* サンプル スクリプトで確認できます。

+- PyTorch モデルは、以前に計算されたキーと値のアテンション ペアである`past_key_values`を入力として受け取ることができます。

+ TensorFlow モデルは`past`を入力として受け入れます。 `past_key_values`値を使用すると、モデルが再計算されなくなります。

+ テキスト生成のコンテキストで事前に計算された値。 [`forward`](model_doc/ctrl#transformers.CTRLModel.forward) を参照してください。

+ この引数の使用法の詳細については、メソッドを参照してください。

+

+## Resources

+

+- [テキスト分類タスクガイド](../tasks/sequence_classification)

+- [因果言語モデリング タスク ガイド](../tasks/language_modeling)

+

+## CTRLConfig

+

+[[autodoc]] CTRLConfig

+

+## CTRLTokenizer

+

+[[autodoc]] CTRLTokenizer

+ - save_vocabulary

+

+

+

+

+## CTRLModel

+

+[[autodoc]] CTRLModel

+ - forward

+

+## CTRLLMHeadModel

+

+[[autodoc]] CTRLLMHeadModel

+ - forward

+

+## CTRLForSequenceClassification

+

+[[autodoc]] CTRLForSequenceClassification

+ - forward

+

+

+

+

+## TFCTRLModel

+

+[[autodoc]] TFCTRLModel

+ - call

+

+## TFCTRLLMHeadModel

+

+[[autodoc]] TFCTRLLMHeadModel

+ - call

+

+## TFCTRLForSequenceClassification

+

+[[autodoc]] TFCTRLForSequenceClassification

+ - call

+

+

+

diff --git a/docs/source/ja/model_doc/cvt.md b/docs/source/ja/model_doc/cvt.md

new file mode 100644

index 00000000000000..16d39d1b55d35c

--- /dev/null

+++ b/docs/source/ja/model_doc/cvt.md

@@ -0,0 +1,88 @@

+

+

+# Convolutional Vision Transformer (CvT)

+

+## Overview

+

+CvT モデルは、Haping Wu、Bin Xiao、Noel Codella、Mengchen Liu、Xiyang Dai、Lu Yuan、Lei Zhang によって [CvT: Introduction Convolutions to Vision Transformers](https://arxiv.org/abs/2103.15808) で提案されました。畳み込みビジョン トランスフォーマー (CvT) は、ViT に畳み込みを導入して両方の設計の長所を引き出すことにより、[ビジョン トランスフォーマー (ViT)](vit) のパフォーマンスと効率を向上させます。

+

+論文の要約は次のとおりです。

+

+*この論文では、ビジョン トランスフォーマー (ViT) を改善する、畳み込みビジョン トランスフォーマー (CvT) と呼ばれる新しいアーキテクチャを紹介します。

+ViT に畳み込みを導入して両方の設計の長所を引き出すことで、パフォーマンスと効率を向上させます。これは次のようにして実現されます。

+2 つの主要な変更: 新しい畳み込みトークンの埋め込みを含むトランスフォーマーの階層と、畳み込みトランスフォーマー

+畳み込み射影を利用したブロック。これらの変更により、畳み込みニューラル ネットワーク (CNN) の望ましい特性が導入されます。

+トランスフォーマーの利点 (動的な注意力、

+グローバルなコンテキストとより良い一般化)。私たちは広範な実験を実施することで CvT を検証し、このアプローチが達成できることを示しています。

+ImageNet-1k 上の他のビジョン トランスフォーマーや ResNet よりも、パラメータが少なく、FLOP が低い、最先端のパフォーマンスを実現します。加えて、

+より大きなデータセット (例: ImageNet-22k) で事前トレーニングし、下流のタスクに合わせて微調整すると、パフォーマンスの向上が維持されます。事前トレーニング済み

+ImageNet-22k、当社の CvT-W24 は、ImageNet-1k val set で 87.7\% というトップ 1 の精度を獲得しています。最後に、私たちの結果は、位置エンコーディングが、

+既存のビジョン トランスフォーマーの重要なコンポーネントであるこのコンポーネントは、モデルでは安全に削除できるため、高解像度のビジョン タスクの設計が簡素化されます。*

+

+このモデルは [anugunj](https://huggingface.co/anugunj) によって提供されました。元のコードは [ここ](https://github.com/microsoft/CvT) にあります。

+

+## Usage tips

+

+- CvT モデルは通常の Vision Transformer ですが、畳み込みでトレーニングされています。 ImageNet-1K および CIFAR-100 で微調整すると、[オリジナル モデル (ViT)](vit) よりも優れたパフォーマンスを発揮します。

+- カスタム データの微調整だけでなく推論に関するデモ ノートブックも [ここ](https://github.com/NielsRogge/Transformers-Tutorials/tree/master/VisionTransformer) で確認できます ([`ViTFeatureExtractor を置き換えるだけで済みます) `] による [`AutoImageProcessor`] および [`ViTForImageClassification`] による [`CvtForImageClassification`])。

+- 利用可能なチェックポイントは、(1) [ImageNet-22k](http://www.image-net.org/) (1,400 万の画像と 22,000 のクラスのコレクション) でのみ事前トレーニングされている、(2) も問題ありません。 ImageNet-22k で調整、または (3) [ImageNet-1k](http://www.image-net.org/challenges/LSVRC/2012/) (ILSVRC 2012 とも呼ばれるコレクション) でも微調整130万の

+ 画像と 1,000 クラス)。

+

+## Resources

+

+CvT を始めるのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。

+

+

+

+- [`CvtForImageClassification`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/pytorch/image-classification) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/image_classification.ipynb)。

+- 参照: [画像分類タスク ガイド](../tasks/image_classification)

+

+ここに含めるリソースの送信に興味がある場合は、お気軽にプル リクエストを開いてください。審査させていただきます。リソースは、既存のリソースを複製するのではなく、何か新しいものを示すことが理想的です。

+

+## CvtConfig

+

+[[autodoc]] CvtConfig

+

+

+

+

+## CvtModel

+

+[[autodoc]] CvtModel

+ - forward

+

+## CvtForImageClassification

+

+[[autodoc]] CvtForImageClassification

+ - forward

+

+

+

+

+## TFCvtModel

+

+[[autodoc]] TFCvtModel

+ - call

+

+## TFCvtForImageClassification

+

+[[autodoc]] TFCvtForImageClassification

+ - call

+

+

+

+

diff --git a/docs/source/ja/model_doc/data2vec.md b/docs/source/ja/model_doc/data2vec.md

new file mode 100644

index 00000000000000..78ae71e6947e4d

--- /dev/null

+++ b/docs/source/ja/model_doc/data2vec.md

@@ -0,0 +1,187 @@

+

+

+# Data2Vec

+

+## Overview

+

+Data2Vec モデルは、[data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language](https://arxiv.org/pdf/2202.03555) で Alexei Baevski、Wei-Ning Hsu、Qiantong Xu、バArun Babu, Jiatao Gu and Michael Auli.

+Data2Vec は、テキスト、音声、画像などのさまざまなデータ モダリティにわたる自己教師あり学習のための統一フレームワークを提案します。

+重要なのは、事前トレーニングの予測ターゲットは、モダリティ固有のコンテキストに依存しないターゲットではなく、入力のコンテキスト化された潜在表現であることです。

+

+論文の要約は次のとおりです。

+

+*自己教師あり学習の一般的な考え方はどのモダリティでも同じですが、実際のアルゴリズムと

+単一のモダリティを念頭に置いて開発されたため、目的は大きく異なります。一般に近づけるために

+自己教師あり学習では、どちらの音声に対しても同じ学習方法を使用するフレームワークである data2vec を紹介します。

+NLP またはコンピューター ビジョン。中心となるアイデアは、完全な入力データの潜在的な表現を、

+標準の Transformer アーキテクチャを使用した自己蒸留セットアップの入力のマスクされたビュー。

+単語、視覚的トークン、人間の音声単位などのモダリティ固有のターゲットを予測するのではなく、

+本質的にローカルであるため、data2vec は、からの情報を含む文脈化された潜在表現を予測します。

+入力全体。音声認識、画像分類、および

+自然言語理解は、新しい最先端技術や、主流のアプローチに匹敵するパフォーマンスを実証します。

+モデルとコードは、www.github.com/pytorch/fairseq/tree/master/examples/data2vec.* で入手できます。

+

+このモデルは、[edugp](https://huggingface.co/edugp) および [patrickvonplaten](https://huggingface.co/patrickvonplaten) によって提供されました。

+[sayakpaul](https://github.com/sayakpaul) と [Rocketknight1](https://github.com/Rocketknight1) は、TensorFlow のビジョンに Data2Vec を提供しました。

+

+元のコード (NLP および音声用) は、[こちら](https://github.com/pytorch/fairseq/tree/main/examples/data2vec) にあります。

+ビジョンの元のコードは [こちら](https://github.com/facebookresearch/data2vec_vision/tree/main/beit) にあります。

+

+## Usage tips

+

+- Data2VecAudio、Data2VecText、および Data2VecVision はすべて、同じ自己教師あり学習方法を使用してトレーニングされています。

+- Data2VecAudio の場合、前処理は特徴抽出を含めて [`Wav2Vec2Model`] と同じです。

+- Data2VecText の場合、前処理はトークン化を含めて [`RobertaModel`] と同じです。

+- Data2VecVision の場合、前処理は特徴抽出を含めて [`BeitModel`] と同じです。

+

+## Resources

+

+Data2Vec の使用を開始するのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。

+

+

+

+- [`Data2VecVisionForImageClassification`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/pytorch/image-classification) および [ノートブック](https://cola.research.google.com/github/huggingface/notebooks/blob/main/examples/image_classification.ipynb)。

+- カスタム データセットで [`TFData2VecVisionForImageClassification`] を微調整するには、[このノートブック](https://colab.research.google.com/github/sayakpaul/TF-2.0-Hacks/blob/master/data2vec_vision_image_classification.ipynb) を参照してください。 )。

+

+**Data2VecText ドキュメント リソース**

+- [テキスト分類タスクガイド](../tasks/sequence_classification)

+- [トークン分類タスクガイド](../tasks/token_classification)

+- [質問回答タスク ガイド](../tasks/question_answering)

+- [因果言語モデリング タスク ガイド](../tasks/language_modeling)

+- [マスク言語モデリング タスク ガイド](../tasks/masked_language_modeling)

+- [多肢選択タスク ガイド](../tasks/multiple_choice)

+

+**Data2VecAudio ドキュメント リソース**

+- [音声分類タスクガイド](../tasks/audio_classification)

+- [自動音声認識タスクガイド](../tasks/asr)

+

+**Data2VecVision ドキュメント リソース**

+- [画像分類](../tasks/image_classification)

+- [セマンティック セグメンテーション](../tasks/semantic_segmentation)

+

+ここに含めるリソースの送信に興味がある場合は、お気軽にプル リクエストを開いてください。審査させていただきます。リソースは、既存のリソースを複製するのではなく、何か新しいものを示すことが理想的です。

+

+## Data2VecTextConfig

+

+[[autodoc]] Data2VecTextConfig

+

+## Data2VecAudioConfig

+

+[[autodoc]] Data2VecAudioConfig

+

+## Data2VecVisionConfig

+

+[[autodoc]] Data2VecVisionConfig

+

+

+

+

+## Data2VecAudioModel

+

+[[autodoc]] Data2VecAudioModel

+ - forward

+

+## Data2VecAudioForAudioFrameClassification

+

+[[autodoc]] Data2VecAudioForAudioFrameClassification

+ - forward

+

+## Data2VecAudioForCTC

+

+[[autodoc]] Data2VecAudioForCTC

+ - forward

+

+## Data2VecAudioForSequenceClassification

+

+[[autodoc]] Data2VecAudioForSequenceClassification

+ - forward

+

+## Data2VecAudioForXVector

+

+[[autodoc]] Data2VecAudioForXVector

+ - forward

+

+## Data2VecTextModel

+

+[[autodoc]] Data2VecTextModel

+ - forward

+

+## Data2VecTextForCausalLM

+

+[[autodoc]] Data2VecTextForCausalLM

+ - forward

+

+## Data2VecTextForMaskedLM

+

+[[autodoc]] Data2VecTextForMaskedLM

+ - forward

+

+## Data2VecTextForSequenceClassification

+

+[[autodoc]] Data2VecTextForSequenceClassification

+ - forward

+

+## Data2VecTextForMultipleChoice

+

+[[autodoc]] Data2VecTextForMultipleChoice

+ - forward

+

+## Data2VecTextForTokenClassification

+

+[[autodoc]] Data2VecTextForTokenClassification

+ - forward

+

+## Data2VecTextForQuestionAnswering

+

+[[autodoc]] Data2VecTextForQuestionAnswering

+ - forward

+

+## Data2VecVisionModel

+

+[[autodoc]] Data2VecVisionModel

+ - forward

+

+## Data2VecVisionForImageClassification

+

+[[autodoc]] Data2VecVisionForImageClassification

+ - forward

+

+## Data2VecVisionForSemanticSegmentation

+

+[[autodoc]] Data2VecVisionForSemanticSegmentation

+ - forward

+

+

+

+

+## TFData2VecVisionModel

+

+[[autodoc]] TFData2VecVisionModel

+ - call

+

+## TFData2VecVisionForImageClassification

+

+[[autodoc]] TFData2VecVisionForImageClassification

+ - call

+

+## TFData2VecVisionForSemanticSegmentation

+

+[[autodoc]] TFData2VecVisionForSemanticSegmentation

+ - call

+

+

+

diff --git a/docs/source/ja/model_doc/deberta-v2.md b/docs/source/ja/model_doc/deberta-v2.md

new file mode 100644

index 00000000000000..1e4229c633734b

--- /dev/null

+++ b/docs/source/ja/model_doc/deberta-v2.md

@@ -0,0 +1,168 @@

+

+

+# DeBERTa-v2

+

+## Overview

+

+DeBERTa モデルは、Pengcheng He、Xiaodong Liu、Jianfeng Gao、Weizhu Chen によって [DeBERTa: Decoding-enhanced BERT with Disentangled Attendant](https://arxiv.org/abs/2006.03654) で提案されました。Google のモデルに基づいています。

+2018年にリリースされたBERTモデルと2019年にリリースされたFacebookのRoBERTaモデル。

+

+これは、もつれた注意を解きほぐし、使用されるデータの半分を使用して強化されたマスク デコーダ トレーニングを備えた RoBERTa に基づいて構築されています。

+ロベルタ。

+

+論文の要約は次のとおりです。

+

+*事前トレーニングされたニューラル言語モデルの最近の進歩により、多くの自然言語モデルのパフォーマンスが大幅に向上しました。

+言語処理 (NLP) タスク。この論文では、新しいモデル アーキテクチャ DeBERTa (Decoding-enhanced BERT with

+これは、2 つの新しい技術を使用して BERT モデルと RoBERTa モデルを改善します。 1つ目は、

+もつれを解く注意メカニズム。各単語は、その内容をエンコードする 2 つのベクトルを使用して表現され、

+単語間の注意の重みは、それらの単語のもつれ解除行列を使用して計算されます。

+内容と相対的な位置。 2 番目に、強化されたマスク デコーダを使用して、出力ソフトマックス レイヤを次のように置き換えます。

+モデルの事前トレーニング用にマスクされたトークンを予測します。これら 2 つの手法により効率が大幅に向上することを示します。

+モデルの事前トレーニングと下流タスクのパフォーマンスの向上。 RoBERTa-Large と比較すると、DeBERTa モデルは半分のレベルでトレーニングされています。

+トレーニング データは幅広い NLP タスクで一貫して優れたパフォーマンスを示し、MNLI で +0.9% の改善を達成しました。

+(90.2% 対 91.1%)、SQuAD v2.0 では +2.3% (88.4% 対 90.7%)、RACE では +3.6% (83.2% 対 86.8%) でした。 DeBERTa コードと

+事前トレーニングされたモデルは https://github.com/microsoft/DeBERTa で公開されます。*

+

+次の情報は、[元の実装で直接表示されます]

+リポジトリ](https://github.com/microsoft/DeBERTa)。 DeBERTa v2 は、DeBERTa モデルの 2 番目のバージョンです。それには以下が含まれます

+SuperGLUE 単一モデルの提出に使用された 1.5B モデルは、人間のベースライン 89.8 に対して 89.9 を達成しました。あなたはできる

+この投稿に関する詳細については、著者のドキュメントを参照してください。

+[ブログ](https://www.microsoft.com/en-us/research/blog/microsoft-deberta-surpasses-human-performance-on-the-superglue-benchmark/)

+

+v2 の新機能:

+

+- **語彙** v2 では、トレーニング データから構築されたサイズ 128K の新しい語彙を使用するようにトークナイザーが変更されました。

+ GPT2 ベースのトークナイザーの代わりに、トークナイザーは

+ [sentencepiece ベース](https://github.com/google/sentencepiece) トークナイザー。

+- **nGiE(nGram Induced Input Encoding)** DeBERTa-v2 モデルは、最初の畳み込み層とは別に追加の畳み込み層を使用します。

+ トランスフォーマー層を使用して、入力トークンのローカル依存関係をよりよく学習します。

+- **位置射影行列を注目レイヤーのコンテンツ射影行列と共有** 以前に基づく

+ 実験では、パフォーマンスに影響を与えることなくパラメータを保存できます。

+- **バケットを適用して相対位置をエンコードします** DeBERTa-v2 モデルはログ バケットを使用して相対位置をエンコードします

+ T5に似ています。

+- **900M モデル & 1.5B モデル** 2 つの追加モデル サイズ: 900M と 1.5B が利用可能で、これにより、パフォーマンスが大幅に向上します。

+ 下流タスクのパフォーマンス。

+

+このモデルは [DeBERTa](https://huggingface.co/DeBERTa) によって寄稿されました。このモデルの TF 2.0 実装は、

+[kamalkraj](https://huggingface.co/kamalkraj) による投稿。元のコードは [こちら](https://github.com/microsoft/DeBERTa) にあります。

+

+## Resources

+- [テキスト分類タスクガイド](../tasks/sequence_classification)

+- [トークン分類タスクガイド](../tasks/token_classification)

+- [質問回答タスク ガイド](../tasks/question_answering)

+- [マスク言語モデリング タスク ガイド](../tasks/masked_language_modeling)

+- [多肢選択タスク ガイド](../tasks/multiple_choice)

+

+## DebertaV2Config

+

+[[autodoc]] DebertaV2Config

+

+## DebertaV2Tokenizer

+

+[[autodoc]] DebertaV2Tokenizer

+ - build_inputs_with_special_tokens

+ - get_special_tokens_mask

+ - create_token_type_ids_from_sequences

+ - save_vocabulary

+

+## DebertaV2TokenizerFast

+

+[[autodoc]] DebertaV2TokenizerFast

+ - build_inputs_with_special_tokens

+ - create_token_type_ids_from_sequences

+

+

+

+

+## DebertaV2Model

+

+[[autodoc]] DebertaV2Model

+ - forward

+

+## DebertaV2PreTrainedModel

+

+[[autodoc]] DebertaV2PreTrainedModel

+ - forward

+

+## DebertaV2ForMaskedLM

+

+[[autodoc]] DebertaV2ForMaskedLM

+ - forward

+

+## DebertaV2ForSequenceClassification

+

+[[autodoc]] DebertaV2ForSequenceClassification

+ - forward

+

+## DebertaV2ForTokenClassification

+

+[[autodoc]] DebertaV2ForTokenClassification

+ - forward

+

+## DebertaV2ForQuestionAnswering

+

+[[autodoc]] DebertaV2ForQuestionAnswering

+ - forward

+

+## DebertaV2ForMultipleChoice

+

+[[autodoc]] DebertaV2ForMultipleChoice

+ - forward

+

+

+

+

+## TFDebertaV2Model

+

+[[autodoc]] TFDebertaV2Model

+ - call

+

+## TFDebertaV2PreTrainedModel

+

+[[autodoc]] TFDebertaV2PreTrainedModel

+ - call

+

+## TFDebertaV2ForMaskedLM

+

+[[autodoc]] TFDebertaV2ForMaskedLM

+ - call

+

+## TFDebertaV2ForSequenceClassification

+

+[[autodoc]] TFDebertaV2ForSequenceClassification

+ - call

+

+## TFDebertaV2ForTokenClassification

+

+[[autodoc]] TFDebertaV2ForTokenClassification

+ - call

+

+## TFDebertaV2ForQuestionAnswering

+

+[[autodoc]] TFDebertaV2ForQuestionAnswering

+ - call

+

+## TFDebertaV2ForMultipleChoice

+

+[[autodoc]] TFDebertaV2ForMultipleChoice

+ - call

+

+

+

+

+

diff --git a/docs/source/ja/model_doc/deberta.md b/docs/source/ja/model_doc/deberta.md

new file mode 100644

index 00000000000000..f7e00ad3b2bcce

--- /dev/null

+++ b/docs/source/ja/model_doc/deberta.md

@@ -0,0 +1,164 @@

+

+

+# DeBERTa

+

+## Overview

+

+DeBERTa モデルは、Pengcheng He、Xiaodong Liu、Jianfeng Gao、Weizhu Chen によって [DeBERTa: Decoding-enhanced BERT with Disentangled Attendant](https://arxiv.org/abs/2006.03654) で提案されました。Google のモデルに基づいています。

+2018年にリリースされたBERTモデルと2019年にリリースされたFacebookのRoBERTaモデル。

+

+これは、もつれた注意を解きほぐし、使用されるデータの半分を使用して強化されたマスク デコーダ トレーニングを備えた RoBERTa に基づいて構築されています。

+ロベルタ。

+

+論文の要約は次のとおりです。

+

+*事前トレーニングされたニューラル言語モデルの最近の進歩により、多くの自然言語モデルのパフォーマンスが大幅に向上しました。

+言語処理 (NLP) タスク。この論文では、新しいモデル アーキテクチャ DeBERTa (Decoding-enhanced BERT with

+これは、2 つの新しい技術を使用して BERT モデルと RoBERTa モデルを改善します。 1つ目は、

+もつれを解く注意メカニズム。各単語は、その内容をエンコードする 2 つのベクトルを使用して表現され、

+単語間の注意の重みは、それらの単語のもつれ解除行列を使用して計算されます。

+内容と相対的な位置。 2 番目に、強化されたマスク デコーダを使用して、出力ソフトマックス レイヤを次のように置き換えます。

+モデルの事前トレーニング用にマスクされたトークンを予測します。これら 2 つの手法により効率が大幅に向上することを示します。

+モデルの事前トレーニングと下流タスクのパフォーマンスの向上。 RoBERTa-Large と比較すると、DeBERTa モデルは半分のレベルでトレーニングされています。

+トレーニング データは幅広い NLP タスクで一貫して優れたパフォーマンスを示し、MNLI で +0.9% の改善を達成しました。

+(90.2% 対 91.1%)、SQuAD v2.0 では +2.3% (88.4% 対 90.7%)、RACE では +3.6% (83.2% 対 86.8%) でした。 DeBERTa コードと

+事前トレーニングされたモデルは https://github.com/microsoft/DeBERTa で公開されます。*

+

+

+このモデルは [DeBERTa](https://huggingface.co/DeBERTa) によって寄稿されました。このモデルの TF 2.0 実装は、

+[kamalkraj](https://huggingface.co/kamalkraj) による寄稿。元のコードは [こちら](https://github.com/microsoft/DeBERTa) にあります。

+

+## Resources

+

+DeBERTa を使い始めるのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。ここに含めるリソースの送信に興味がある場合は、お気軽にプル リクエストを開いてください。審査させていただきます。リソースは、既存のリソースを複製するのではなく、何か新しいものを示すことが理想的です。

+

+

+

+- DeBERTa を使用して [DeepSpeed を使用して大規模モデルのトレーニングを加速する](https://huggingface.co/blog/accelerate-deepspeed) 方法に関するブログ投稿。

+- DeBERTa による [機械学習によるスーパーチャージされた顧客サービス](https://huggingface.co/blog/supercharge-customer-service-with-machine-learning) に関するブログ投稿。

+- [`DebertaForSequenceClassification`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/pytorch/text-classification) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/text_classification.ipynb)。

+- [`TFDebertaForSequenceClassification`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/tensorflow/text-classification) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/text_classification-tf.ipynb)。

+- [テキスト分類タスクガイド](../tasks/sequence_classification)

+

+

+

+- [`DebertaForTokenClassification`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/pytorch/token-classification) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/token_classification.ipynb)。

+- [`TFDebertaForTokenClassification`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/tensorflow/token-classification) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/token_classification-tf.ipynb)。

+- [トークン分類](https://huggingface.co/course/chapter7/2?fw=pt) 🤗 ハグフェイスコースの章。

+- 🤗 ハグフェイスコースの [バイトペアエンコーディングのトークン化](https://huggingface.co/course/chapter6/5?fw=pt) の章。

+- [トークン分類タスクガイド](../tasks/token_classification)

+

+

+

+- [`DebertaForMaskedLM`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/pytorch/language-modeling#robertabertdistilbert-and-masked-language-modeling) でサポートされています。 [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/language_modeling.ipynb)。

+- [`TFDebertaForMaskedLM`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/tensorflow/lang-modeling#run_mlmpy) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/language_modeling-tf.ipynb)。

+- [マスクされた言語モデリング](https://huggingface.co/course/chapter7/3?fw=pt) 🤗 顔のハグ コースの章。

+- [マスク言語モデリング タスク ガイド](../tasks/masked_language_modeling)

+

+

+

+- [`DebertaForQuestionAnswering`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/pytorch/question-answering) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/question_answering.ipynb)。

+- [`TFDebertaForQuestionAnswering`] は、この [サンプル スクリプト](https://github.com/huggingface/transformers/tree/main/examples/tensorflow/question-answering) および [ノートブック](https://colab.research.google.com/github/huggingface/notebooks/blob/main/examples/question_answering-tf.ipynb)。

+- [質問回答](https://huggingface.co/course/chapter7/7?fw=pt) 🤗 ハグフェイスコースの章。

+- [質問回答タスク ガイド](../tasks/question_answering)

+

+## DebertaConfig

+

+[[autodoc]] DebertaConfig

+

+## DebertaTokenizer

+

+[[autodoc]] DebertaTokenizer

+ - build_inputs_with_special_tokens

+ - get_special_tokens_mask

+ - create_token_type_ids_from_sequences

+ - save_vocabulary

+

+## DebertaTokenizerFast

+

+[[autodoc]] DebertaTokenizerFast

+ - build_inputs_with_special_tokens

+ - create_token_type_ids_from_sequences

+

+

+

+

+## DebertaModel

+

+[[autodoc]] DebertaModel

+ - forward

+

+## DebertaPreTrainedModel

+

+[[autodoc]] DebertaPreTrainedModel

+

+## DebertaForMaskedLM

+

+[[autodoc]] DebertaForMaskedLM

+ - forward

+

+## DebertaForSequenceClassification

+

+[[autodoc]] DebertaForSequenceClassification

+ - forward

+

+## DebertaForTokenClassification

+

+[[autodoc]] DebertaForTokenClassification

+ - forward

+

+## DebertaForQuestionAnswering

+

+[[autodoc]] DebertaForQuestionAnswering

+ - forward

+

+

+

+

+## TFDebertaModel

+

+[[autodoc]] TFDebertaModel

+ - call

+

+## TFDebertaPreTrainedModel

+

+[[autodoc]] TFDebertaPreTrainedModel

+ - call

+

+## TFDebertaForMaskedLM

+

+[[autodoc]] TFDebertaForMaskedLM

+ - call

+

+## TFDebertaForSequenceClassification

+

+[[autodoc]] TFDebertaForSequenceClassification

+ - call

+

+## TFDebertaForTokenClassification

+

+[[autodoc]] TFDebertaForTokenClassification

+ - call

+

+## TFDebertaForQuestionAnswering

+

+[[autodoc]] TFDebertaForQuestionAnswering

+ - call

+

+

+

+

diff --git a/docs/source/ja/model_doc/decision_transformer.md b/docs/source/ja/model_doc/decision_transformer.md

new file mode 100644

index 00000000000000..9c7f27bbeeec2d

--- /dev/null

+++ b/docs/source/ja/model_doc/decision_transformer.md

@@ -0,0 +1,53 @@

+

+

+# Decision Transformer

+

+## Overview

+

+Decision Transformer モデルは、[Decision Transformer: Reinforcement Learning via Sequence Modeling](https://arxiv.org/abs/2106.01345) で提案されました。

+Lili Chen, Kevin Lu, Aravind Rajeswaran, Kimin Lee, Aditya Grover, Michael Laskin, Pieter Abbeel, Aravind Srinivas, Igor Mordatch.

+

+論文の要約は次のとおりです。

+

+*強化学習(RL)をシーケンスモデリング問題として抽象化するフレームワークを紹介します。

+これにより、Transformer アーキテクチャのシンプルさとスケーラビリティ、および関連する進歩を活用できるようになります。

+ GPT-x や BERT などの言語モデリングで。特に、Decision Transformer というアーキテクチャを紹介します。

+ RL の問題を条件付きシーケンス モデリングとして投げかけます。値関数に適合する以前の RL アプローチとは異なり、

+ ポリシー勾配を計算すると、Decision Transformer は因果的にマスクされたアルゴリズムを利用して最適なアクションを出力するだけです。

+ 変成器。望ましいリターン (報酬)、過去の状態、アクションに基づいて自己回帰モデルを条件付けすることにより、

+ Decision Transformer モデルは、望ましいリターンを達成する将来のアクションを生成できます。そのシンプルさにも関わらず、

+ Decision Transformer は、最先端のモデルフリーのオフライン RL ベースラインのパフォーマンスと同等、またはそれを超えています。

+ Atari、OpenAI Gym、Key-to-Door タスク*

+

+このバージョンのモデルは、状態がベクトルであるタスク用です。

+

+このモデルは、[edbeeching](https://huggingface.co/edbeeching) によって提供されました。元のコードは [ここ](https://github.com/kzl/decion-transformer) にあります。

+

+## DecisionTransformerConfig

+

+[[autodoc]] DecisionTransformerConfig

+

+

+## DecisionTransformerGPT2Model

+

+[[autodoc]] DecisionTransformerGPT2Model

+ - forward

+

+## DecisionTransformerModel

+

+[[autodoc]] DecisionTransformerModel

+ - forward

diff --git a/docs/source/ja/model_doc/deformable_detr.md b/docs/source/ja/model_doc/deformable_detr.md

new file mode 100644

index 00000000000000..ccb6ec42f869b6

--- /dev/null

+++ b/docs/source/ja/model_doc/deformable_detr.md

@@ -0,0 +1,75 @@

+

+

+# Deformable DETR

+

+## Overview

+

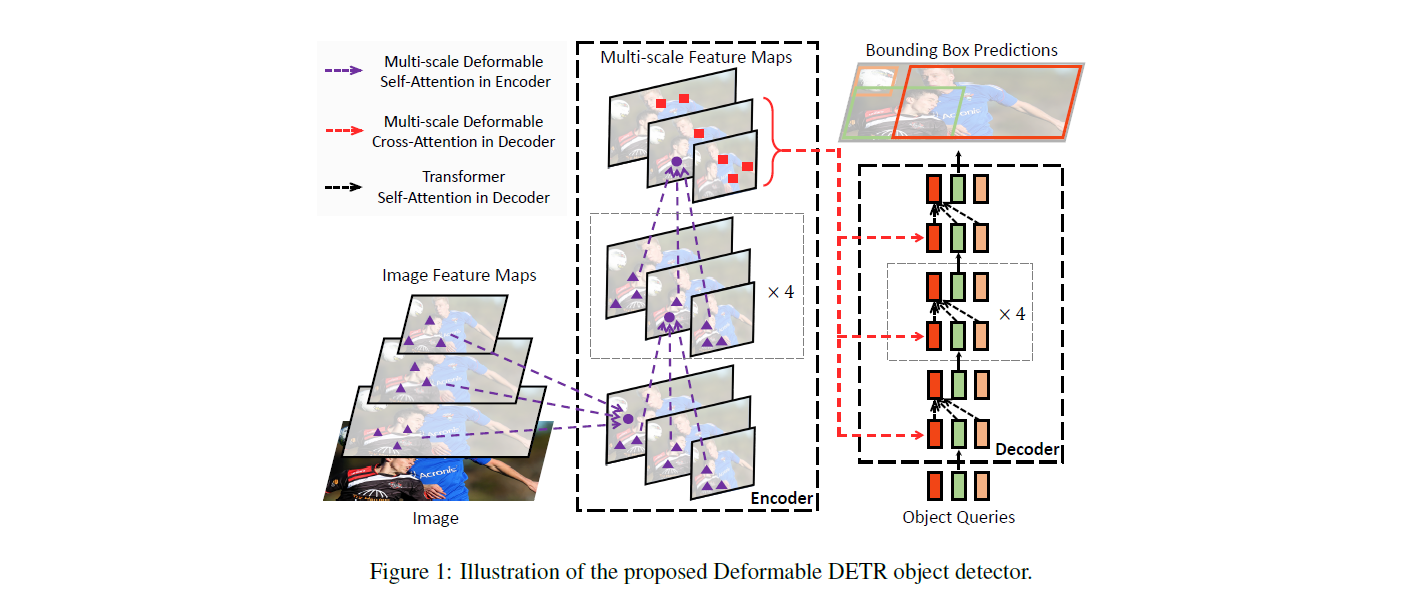

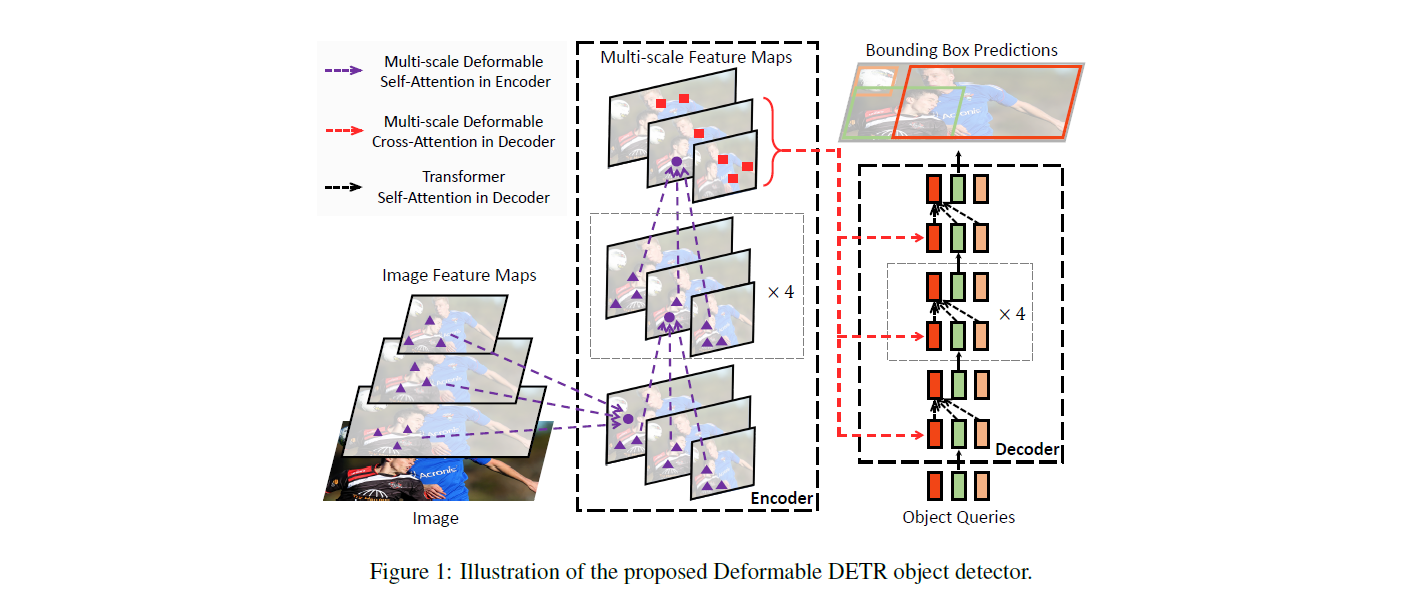

+変形可能 DETR モデルは、Xizhou Zhu、Weijie Su、Lewei Lu、Bin Li、Xiaogang Wang, Jifeng Dai によって [Deformable DETR: Deformable Transformers for End-to-End Object Detection](https://arxiv.org/abs/2010.04159) で提案されました

+変形可能な DETR は、参照周囲の少数の主要なサンプリング ポイントのみに注目する新しい変形可能なアテンション モジュールを利用することにより、収束の遅さの問題と元の [DETR](detr) の制限された特徴の空間解像度を軽減します。

+

+論文の要約は次のとおりです。

+

+*DETR は、優れたパフォーマンスを実証しながら、物体検出における多くの手作業で設計されたコンポーネントの必要性を排除するために最近提案されました。ただし、画像特徴マップの処理における Transformer アテンション モジュールの制限により、収束が遅く、特徴の空間解像度が制限されるという問題があります。これらの問題を軽減するために、私たちは Deformable DETR を提案しました。この DETR のアテンション モジュールは、参照周囲の少数の主要なサンプリング ポイントのみに注目します。変形可能な DETR は、10 分の 1 のトレーニング エポックで、DETR よりも優れたパフォーマンス (特に小さなオブジェクトの場合) を達成できます。 COCO ベンチマークに関する広範な実験により、私たちのアプローチの有効性が実証されました。*

+

+ +

+ 変形可能な DETR アーキテクチャ。 元の論文から抜粋。

+

+このモデルは、[nielsr](https://huggingface.co/nielsr) によって提供されました。元のコードは [ここ](https://github.com/fundamentalvision/Deformable-DETR) にあります。

+

+## Usage tips

+

+

+ - トレーニング Deformable DETR は、元の [DETR](detr) モデルをトレーニングすることと同等です。デモ ノートブックについては、以下の [resources](#resources) セクションを参照してください。

+

+## Resources

+

+Deformable DETR の使用を開始するのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。

+

+

+

+- [`DeformableDetrForObjectDetection`] のカスタム データセットでの推論と微調整に関するデモ ノートブックは、[こちら](https://github.com/NielsRogge/Transformers-Tutorials/tree/master/Deformable-DETR) にあります。

+- [物体検出タスクガイド](../tasks/object_detection) も参照してください。

+

+ここに含めるリソースの送信に興味がある場合は、お気軽にプル リクエストを開いてください。審査させていただきます。リソースは、既存のリソースを複製するのではなく、何か新しいものを示すことが理想的です。

+

+## DeformableDetrImageProcessor

+

+[[autodoc]] DeformableDetrImageProcessor

+ - preprocess

+ - post_process_object_detection

+

+## DeformableDetrFeatureExtractor

+

+[[autodoc]] DeformableDetrFeatureExtractor

+ - __call__

+ - post_process_object_detection

+

+## DeformableDetrConfig

+

+[[autodoc]] DeformableDetrConfig

+

+## DeformableDetrModel

+

+[[autodoc]] DeformableDetrModel

+ - forward

+

+## DeformableDetrForObjectDetection

+

+[[autodoc]] DeformableDetrForObjectDetection

+ - forward

+

+ 変形可能な DETR アーキテクチャ。 元の論文から抜粋。

+

+このモデルは、[nielsr](https://huggingface.co/nielsr) によって提供されました。元のコードは [ここ](https://github.com/fundamentalvision/Deformable-DETR) にあります。

+

+## Usage tips

+

+

+ - トレーニング Deformable DETR は、元の [DETR](detr) モデルをトレーニングすることと同等です。デモ ノートブックについては、以下の [resources](#resources) セクションを参照してください。

+

+## Resources

+

+Deformable DETR の使用を開始するのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。

+

+

+

+- [`DeformableDetrForObjectDetection`] のカスタム データセットでの推論と微調整に関するデモ ノートブックは、[こちら](https://github.com/NielsRogge/Transformers-Tutorials/tree/master/Deformable-DETR) にあります。

+- [物体検出タスクガイド](../tasks/object_detection) も参照してください。

+

+ここに含めるリソースの送信に興味がある場合は、お気軽にプル リクエストを開いてください。審査させていただきます。リソースは、既存のリソースを複製するのではなく、何か新しいものを示すことが理想的です。

+

+## DeformableDetrImageProcessor

+

+[[autodoc]] DeformableDetrImageProcessor

+ - preprocess

+ - post_process_object_detection

+

+## DeformableDetrFeatureExtractor

+

+[[autodoc]] DeformableDetrFeatureExtractor

+ - __call__

+ - post_process_object_detection

+

+## DeformableDetrConfig

+

+[[autodoc]] DeformableDetrConfig

+

+## DeformableDetrModel

+

+[[autodoc]] DeformableDetrModel

+ - forward

+

+## DeformableDetrForObjectDetection

+

+[[autodoc]] DeformableDetrForObjectDetection

+ - forward

+

+

+

+

+

+ +

+

+

+ +

+ 変形可能な DETR アーキテクチャ。 元の論文から抜粋。

+

+このモデルは、[nielsr](https://huggingface.co/nielsr) によって提供されました。元のコードは [ここ](https://github.com/fundamentalvision/Deformable-DETR) にあります。

+

+## Usage tips

+

+

+ - トレーニング Deformable DETR は、元の [DETR](detr) モデルをトレーニングすることと同等です。デモ ノートブックについては、以下の [resources](#resources) セクションを参照してください。

+

+## Resources

+

+Deformable DETR の使用を開始するのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。

+

+

+

+ 変形可能な DETR アーキテクチャ。 元の論文から抜粋。

+

+このモデルは、[nielsr](https://huggingface.co/nielsr) によって提供されました。元のコードは [ここ](https://github.com/fundamentalvision/Deformable-DETR) にあります。

+

+## Usage tips

+

+

+ - トレーニング Deformable DETR は、元の [DETR](detr) モデルをトレーニングすることと同等です。デモ ノートブックについては、以下の [resources](#resources) セクションを参照してください。

+

+## Resources

+

+Deformable DETR の使用を開始するのに役立つ公式 Hugging Face およびコミュニティ (🌎 で示される) リソースのリスト。

+

+