diff --git a/.github/workflows/build-docker-images.yml b/.github/workflows/build-docker-images.yml

index b267ad7882d89f..be070a95d3a94f 100644

--- a/.github/workflows/build-docker-images.yml

+++ b/.github/workflows/build-docker-images.yml

@@ -271,3 +271,39 @@ jobs:

REF=main

push: true

tags: huggingface/transformers-tensorflow-gpu

+

+ # latest-pytorch-deepspeed-amd:

+ # name: "PyTorch + DeepSpeed (AMD) [dev]"

+

+ # runs-on: [self-hosted, docker-gpu, amd-gpu, single-gpu, mi210]

+ # steps:

+ # - name: Set up Docker Buildx

+ # uses: docker/setup-buildx-action@v3

+ # - name: Check out code

+ # uses: actions/checkout@v3

+ # - name: Login to DockerHub

+ # uses: docker/login-action@v3

+ # with:

+ # username: ${{ secrets.DOCKERHUB_USERNAME }}

+ # password: ${{ secrets.DOCKERHUB_PASSWORD }}

+ # - name: Build and push

+ # uses: docker/build-push-action@v5

+ # with:

+ # context: ./docker/transformers-pytorch-deepspeed-amd-gpu

+ # build-args: |

+ # REF=main

+ # push: true

+ # tags: huggingface/transformers-pytorch-deepspeed-amd-gpu${{ inputs.image_postfix }}

+ # # Push CI images still need to be re-built daily

+ # -

+ # name: Build and push (for Push CI) in a daily basis

+ # # This condition allows `schedule` events, or `push` events that trigger this workflow NOT via `workflow_call`.

+ # # The later case is useful for manual image building for debugging purpose. Use another tag in this case!

+ # if: inputs.image_postfix != '-push-ci'

+ # uses: docker/build-push-action@v5

+ # with:

+ # context: ./docker/transformers-pytorch-deepspeed-amd-gpu

+ # build-args: |

+ # REF=main

+ # push: true

+ # tags: huggingface/transformers-pytorch-deepspeed-amd-gpu-push-ci

diff --git a/.github/workflows/check_runner_status.yml b/.github/workflows/check_runner_status.yml

deleted file mode 100644

index 328d284223a857..00000000000000

--- a/.github/workflows/check_runner_status.yml

+++ /dev/null

@@ -1,68 +0,0 @@

-name: Self-hosted runner (check runner status)

-

-# Note that each job's dependencies go into a corresponding docker file.

-#

-# For example for `run_all_tests_torch_cuda_extensions_gpu` the docker image is

-# `huggingface/transformers-pytorch-deepspeed-latest-gpu`, which can be found at

-# `docker/transformers-pytorch-deepspeed-latest-gpu/Dockerfile`

-

-on:

- repository_dispatch:

- schedule:

- # run per hour

- - cron: "0 */1 * * *"

-

-env:

- TRANSFORMERS_IS_CI: yes

-

-jobs:

- check_runner_status:

- name: Check Runner Status

- runs-on: ubuntu-22.04

- outputs:

- offline_runners: ${{ steps.set-offline_runners.outputs.offline_runners }}

- steps:

- - name: Checkout transformers

- uses: actions/checkout@v3

- with:

- fetch-depth: 2

-

- - name: Check Runner Status

- run: python utils/check_self_hosted_runner.py --target_runners single-gpu-ci-runner-docker,multi-gpu-ci-runner-docker,single-gpu-scheduled-ci-runner-docker,multi-scheduled-scheduled-ci-runner-docker,single-gpu-doctest-ci-runner-docker --token ${{ secrets.ACCESS_REPO_INFO_TOKEN }}

-

- - id: set-offline_runners

- name: Set output for offline runners

- if: ${{ always() }}

- run: |

- offline_runners=$(python3 -c 'fp = open("offline_runners.txt"); failed = fp.read(); fp.close(); print(failed)')

- echo "offline_runners=$offline_runners" >> $GITHUB_OUTPUT

-

- send_results:

- name: Send results to webhook

- runs-on: ubuntu-22.04

- needs: check_runner_status

- if: ${{ failure() }}

- steps:

- - name: Preliminary job status

- shell: bash

- run: |

- echo "Runner availability: ${{ needs.check_runner_status.result }}"

-

- - uses: actions/checkout@v3

- - uses: actions/download-artifact@v3

- - name: Send message to Slack

- env:

- CI_SLACK_BOT_TOKEN: ${{ secrets.CI_SLACK_BOT_TOKEN }}

- CI_SLACK_CHANNEL_ID: ${{ secrets.CI_SLACK_CHANNEL_ID }}

- CI_SLACK_CHANNEL_ID_DAILY: ${{ secrets.CI_SLACK_CHANNEL_ID_DAILY }}

- CI_SLACK_CHANNEL_DUMMY_TESTS: ${{ secrets.CI_SLACK_CHANNEL_DUMMY_TESTS }}

- CI_SLACK_REPORT_CHANNEL_ID: ${{ secrets.CI_SLACK_CHANNEL_ID_DAILY }}

- ACCESS_REPO_INFO_TOKEN: ${{ secrets.ACCESS_REPO_INFO_TOKEN }}

- CI_EVENT: runner status check

- RUNNER_STATUS: ${{ needs.check_runner_status.result }}

- OFFLINE_RUNNERS: ${{ needs.check_runner_status.outputs.offline_runners }}

- # We pass `needs.setup.outputs.matrix` as the argument. A processing in `notification_service.py` to change

- # `models/bert` to `models_bert` is required, as the artifact names use `_` instead of `/`.

- run: |

- pip install slack_sdk

- python utils/notification_service.py

diff --git a/.github/workflows/delete_doc_comment.yml b/.github/workflows/delete_doc_comment.yml

deleted file mode 100644

index 8604019d76eb50..00000000000000

--- a/.github/workflows/delete_doc_comment.yml

+++ /dev/null

@@ -1,14 +0,0 @@

-name: Delete doc comment

-

-on:

- workflow_run:

- workflows: ["Delete doc comment trigger"]

- types:

- - completed

-

-

-jobs:

- delete:

- uses: huggingface/doc-builder/.github/workflows/delete_doc_comment.yml@main

- secrets:

- comment_bot_token: ${{ secrets.COMMENT_BOT_TOKEN }}

\ No newline at end of file

diff --git a/.github/workflows/delete_doc_comment_trigger.yml b/.github/workflows/delete_doc_comment_trigger.yml

deleted file mode 100644

index f87d9bd4dca705..00000000000000

--- a/.github/workflows/delete_doc_comment_trigger.yml

+++ /dev/null

@@ -1,12 +0,0 @@

-name: Delete doc comment trigger

-

-on:

- pull_request:

- types: [ closed ]

-

-

-jobs:

- delete:

- uses: huggingface/doc-builder/.github/workflows/delete_doc_comment_trigger.yml@main

- with:

- pr_number: ${{ github.event.number }}

diff --git a/.github/workflows/self-nightly-scheduled.yml b/.github/workflows/self-nightly-scheduled.yml

index e4b4f7f77cf077..37dc98f340a16d 100644

--- a/.github/workflows/self-nightly-scheduled.yml

+++ b/.github/workflows/self-nightly-scheduled.yml

@@ -212,7 +212,7 @@ jobs:

python3 -m pip uninstall -y deepspeed

rm -rf DeepSpeed

git clone https://github.com/microsoft/DeepSpeed && cd DeepSpeed && rm -rf build

- DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 DS_BUILD_UTILS=1 python3 -m pip install . --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

+ DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 python3 -m pip install . --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

- name: NVIDIA-SMI

run: |

@@ -286,4 +286,4 @@ jobs:

with:

name: |

single-*

- multi-*

\ No newline at end of file

+ multi-*

diff --git a/.github/workflows/self-past.yml b/.github/workflows/self-past.yml

index 6a154544df8b97..ed60c92f6745a8 100644

--- a/.github/workflows/self-past.yml

+++ b/.github/workflows/self-past.yml

@@ -88,6 +88,10 @@ jobs:

working-directory: /transformers

run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+ - name: Update some packages

+ working-directory: /transformers

+ run: python3 -m pip install -U datasets

+

- name: Echo folder ${{ matrix.folders }}

shell: bash

# For folders like `models/bert`, set an env. var. (`matrix_folders`) to `models_bert`, which will be used to

@@ -164,6 +168,10 @@ jobs:

working-directory: /transformers

run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+ - name: Update some packages

+ working-directory: /transformers

+ run: python3 -m pip install -U datasets

+

- name: Echo folder ${{ matrix.folders }}

shell: bash

# For folders like `models/bert`, set an env. var. (`matrix_folders`) to `models_bert`, which will be used to

@@ -240,6 +248,10 @@ jobs:

working-directory: /transformers

run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+ - name: Update some packages

+ working-directory: /transformers

+ run: python3 -m pip install -U datasets

+

- name: Install

working-directory: /transformers

run: |

@@ -255,7 +267,7 @@ jobs:

python3 -m pip uninstall -y deepspeed

rm -rf DeepSpeed

git clone https://github.com/microsoft/DeepSpeed && cd DeepSpeed && rm -rf build

- DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 DS_BUILD_UTILS=1 python3 -m pip install . --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

+ DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 python3 -m pip install . --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

- name: NVIDIA-SMI

run: |

@@ -341,4 +353,4 @@ jobs:

with:

name: |

single-*

- multi-*

\ No newline at end of file

+ multi-*

diff --git a/.github/workflows/self-push-amd-mi210-caller.yml b/.github/workflows/self-push-amd-mi210-caller.yml

index 5dd010ef66d8fb..2e6b9301d8d72a 100644

--- a/.github/workflows/self-push-amd-mi210-caller.yml

+++ b/.github/workflows/self-push-amd-mi210-caller.yml

@@ -18,7 +18,7 @@ on:

jobs:

run_amd_ci:

name: AMD mi210

- if: (cancelled() != true) && ((github.event_name != 'schedule') || ((github.event_name == 'push') && startsWith(github.ref_name, 'run_amd_push_ci_caller')))

+ if: (cancelled() != true) && ((github.event_name == 'push') && (github.ref_name == 'main' || startsWith(github.ref_name, 'run_amd_push_ci_caller')))

uses: ./.github/workflows/self-push-amd.yml

with:

gpu_flavor: mi210

diff --git a/.github/workflows/self-push-amd-mi250-caller.yml b/.github/workflows/self-push-amd-mi250-caller.yml

index a55378c4caa54b..412fb8f08870e3 100644

--- a/.github/workflows/self-push-amd-mi250-caller.yml

+++ b/.github/workflows/self-push-amd-mi250-caller.yml

@@ -18,7 +18,7 @@ on:

jobs:

run_amd_ci:

name: AMD mi250

- if: (cancelled() != true) && ((github.event_name != 'schedule') || ((github.event_name == 'push') && startsWith(github.ref_name, 'run_amd_push_ci_caller')))

+ if: (cancelled() != true) && ((github.event_name == 'push') && (github.ref_name == 'main' || startsWith(github.ref_name, 'run_amd_push_ci_caller')))

uses: ./.github/workflows/self-push-amd.yml

with:

gpu_flavor: mi250

diff --git a/.github/workflows/self-push-amd.yml b/.github/workflows/self-push-amd.yml

index c72f224a300cc8..19857981b12dbd 100644

--- a/.github/workflows/self-push-amd.yml

+++ b/.github/workflows/self-push-amd.yml

@@ -38,14 +38,16 @@ jobs:

runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

container:

image: huggingface/transformers-pytorch-amd-gpu-push-ci # <--- We test only for PyTorch for now

- options: --device /dev/kfd --device /dev/dri --env HIP_VISIBLE_DEVICES --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

steps:

- name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

run: |

rocminfo | grep "Agent" -A 14

- - name: Show HIP environment

+ - name: Show ROCR environment

run: |

- echo "HIP: $HIP_VISIBLE_DEVICES"

echo "ROCR: $ROCR_VISIBLE_DEVICES"

setup_gpu:

@@ -57,7 +59,7 @@ jobs:

runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

container:

image: huggingface/transformers-pytorch-amd-gpu-push-ci # <--- We test only for PyTorch for now

- options: --device /dev/kfd --device /dev/dri --env HIP_VISIBLE_DEVICES --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

outputs:

matrix: ${{ steps.set-matrix.outputs.matrix }}

test_map: ${{ steps.set-matrix.outputs.test_map }}

@@ -155,7 +157,7 @@ jobs:

runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

container:

image: huggingface/transformers-pytorch-amd-gpu-push-ci # <--- We test only for PyTorch for now

- options: --device /dev/kfd --device /dev/dri --env HIP_VISIBLE_DEVICES --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

steps:

# Necessary to get the correct branch name and commit SHA for `workflow_run` event

# We also take into account the `push` event (we might want to test some changes in a branch)

@@ -206,11 +208,13 @@ jobs:

echo "matrix_folders=$matrix_folders" >> $GITHUB_ENV

- name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

run: |

rocminfo | grep "Agent" -A 14

- - name: Show HIP environment

+ - name: Show ROCR environment

run: |

- echo "HIP: $HIP_VISIBLE_DEVICES"

echo "ROCR: $ROCR_VISIBLE_DEVICES"

- name: Environment

diff --git a/.github/workflows/self-push.yml b/.github/workflows/self-push.yml

index a6ea5b1e04b942..e6f1f3b3050f7a 100644

--- a/.github/workflows/self-push.yml

+++ b/.github/workflows/self-push.yml

@@ -366,7 +366,7 @@ jobs:

working-directory: /workspace

run: |

python3 -m pip uninstall -y deepspeed

- DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 DS_BUILD_UTILS=1 python3 -m pip install deepspeed --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

+ DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 python3 -m pip install deepspeed --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

- name: NVIDIA-SMI

run: |

@@ -456,7 +456,7 @@ jobs:

working-directory: /workspace

run: |

python3 -m pip uninstall -y deepspeed

- DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 DS_BUILD_UTILS=1 python3 -m pip install deepspeed --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

+ DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 python3 -m pip install deepspeed --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

- name: NVIDIA-SMI

run: |

diff --git a/.github/workflows/self-scheduled-amd-caller.yml b/.github/workflows/self-scheduled-amd-caller.yml

new file mode 100644

index 00000000000000..dc5c7b7e905bd8

--- /dev/null

+++ b/.github/workflows/self-scheduled-amd-caller.yml

@@ -0,0 +1,14 @@

+name: Self-hosted runner (AMD scheduled CI caller)

+

+on:

+ schedule:

+ - cron: "17 2 * * *"

+

+jobs:

+ run_scheduled_amd_ci:

+ name: Trigger Scheduled AMD CI

+ runs-on: ubuntu-22.04

+ if: ${{ always() }}

+ steps:

+ - name: Trigger scheduled AMD CI via workflow_run

+ run: echo "Trigger scheduled AMD CI via workflow_run"

diff --git a/.github/workflows/self-scheduled-amd-mi210-caller.yml b/.github/workflows/self-scheduled-amd-mi210-caller.yml

new file mode 100644

index 00000000000000..cdb968901058b6

--- /dev/null

+++ b/.github/workflows/self-scheduled-amd-mi210-caller.yml

@@ -0,0 +1,19 @@

+name: Self-hosted runner (AMD mi210 scheduled CI caller)

+

+on:

+ workflow_run:

+ workflows: ["Self-hosted runner (AMD scheduled CI caller)"]

+ branches: ["main"]

+ types: [completed]

+ push:

+ branches:

+ - run_amd_scheduled_ci_caller*

+

+jobs:

+ run_amd_ci:

+ name: AMD mi210

+ if: (cancelled() != true) && ((github.event_name == 'workflow_run') || ((github.event_name == 'push') && startsWith(github.ref_name, 'run_amd_scheduled_ci_caller')))

+ uses: ./.github/workflows/self-scheduled-amd.yml

+ with:

+ gpu_flavor: mi210

+ secrets: inherit

diff --git a/.github/workflows/self-scheduled-amd-mi250-caller.yml b/.github/workflows/self-scheduled-amd-mi250-caller.yml

new file mode 100644

index 00000000000000..dc7d12f173935e

--- /dev/null

+++ b/.github/workflows/self-scheduled-amd-mi250-caller.yml

@@ -0,0 +1,19 @@

+name: Self-hosted runner (AMD mi250 scheduled CI caller)

+

+on:

+ workflow_run:

+ workflows: ["Self-hosted runner (AMD scheduled CI caller)"]

+ branches: ["main"]

+ types: [completed]

+ push:

+ branches:

+ - run_amd_scheduled_ci_caller*

+

+jobs:

+ run_amd_ci:

+ name: AMD mi250

+ if: (cancelled() != true) && ((github.event_name == 'workflow_run') || ((github.event_name == 'push') && startsWith(github.ref_name, 'run_amd_scheduled_ci_caller')))

+ uses: ./.github/workflows/self-scheduled-amd.yml

+ with:

+ gpu_flavor: mi250

+ secrets: inherit

diff --git a/.github/workflows/self-scheduled-amd.yml b/.github/workflows/self-scheduled-amd.yml

new file mode 100644

index 00000000000000..3d41a3b95e6c50

--- /dev/null

+++ b/.github/workflows/self-scheduled-amd.yml

@@ -0,0 +1,518 @@

+name: Self-hosted runner (scheduled-amd)

+

+# Note: For the AMD CI, we rely on a caller workflow and on the workflow_call event to trigger the

+# CI in order to run it on both MI210 and MI250, without having to use matrix here which pushes

+# us towards the limit of allowed jobs on GitHub Actions.

+on:

+ workflow_call:

+ inputs:

+ gpu_flavor:

+ required: true

+ type: string

+

+env:

+ HF_HOME: /mnt/cache

+ TRANSFORMERS_IS_CI: yes

+ OMP_NUM_THREADS: 8

+ MKL_NUM_THREADS: 8

+ RUN_SLOW: yes

+ SIGOPT_API_TOKEN: ${{ secrets.SIGOPT_API_TOKEN }}

+

+

+# Important note: each job (run_tests_single_gpu, run_tests_multi_gpu, run_examples_gpu, run_pipelines_torch_gpu) requires all the previous jobs before running.

+# This is done so that we avoid parallelizing the scheduled tests, to leave available

+# runners for the push CI that is running on the same machine.

+jobs:

+ check_runner_status:

+ name: Check Runner Status

+ runs-on: ubuntu-22.04

+ steps:

+ - name: Checkout transformers

+ uses: actions/checkout@v3

+ with:

+ fetch-depth: 2

+

+ - name: Check Runner Status

+ run: python utils/check_self_hosted_runner.py --target_runners hf-amd-mi210-ci-1gpu-1,hf-amd-mi250-ci-1gpu-1 --token ${{ secrets.ACCESS_REPO_INFO_TOKEN }}

+

+ check_runners:

+ name: Check Runners

+ needs: check_runner_status

+ strategy:

+ matrix:

+ machine_type: [single-gpu, multi-gpu]

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ container:

+ image: huggingface/transformers-pytorch-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ steps:

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ setup:

+ name: Setup

+ needs: check_runners

+ strategy:

+ matrix:

+ machine_type: [single-gpu, multi-gpu]

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ container:

+ image: huggingface/transformers-pytorch-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ outputs:

+ matrix: ${{ steps.set-matrix.outputs.matrix }}

+ steps:

+ - name: Update clone

+ working-directory: /transformers

+ run: |

+ git fetch && git checkout ${{ github.sha }}

+

+ - name: Cleanup

+ working-directory: /transformers

+ run: |

+ rm -rf tests/__pycache__

+ rm -rf tests/models/__pycache__

+ rm -rf reports

+

+ - name: Show installed libraries and their versions

+ working-directory: /transformers

+ run: pip freeze

+

+ - id: set-matrix

+ name: Identify models to test

+ working-directory: /transformers/tests

+ run: |

+ echo "matrix=$(python3 -c 'import os; tests = os.getcwd(); model_tests = os.listdir(os.path.join(tests, "models")); d1 = sorted(list(filter(os.path.isdir, os.listdir(tests)))); d2 = sorted(list(filter(os.path.isdir, [f"models/{x}" for x in model_tests]))); d1.remove("models"); d = d2 + d1; print(d)')" >> $GITHUB_OUTPUT

+

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ - name: Environment

+ working-directory: /transformers

+ run: |

+ python3 utils/print_env.py

+

+ run_tests_single_gpu:

+ name: Single GPU tests

+ strategy:

+ max-parallel: 1 # For now, not to parallelize. Can change later if it works well.

+ fail-fast: false

+ matrix:

+ folders: ${{ fromJson(needs.setup.outputs.matrix) }}

+ machine_type: [single-gpu]

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ container:

+ image: huggingface/transformers-pytorch-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ needs: setup

+ steps:

+ - name: Echo folder ${{ matrix.folders }}

+ shell: bash

+ # For folders like `models/bert`, set an env. var. (`matrix_folders`) to `models_bert`, which will be used to

+ # set the artifact folder names (because the character `/` is not allowed).

+ run: |

+ echo "${{ matrix.folders }}"

+ matrix_folders=${{ matrix.folders }}

+ matrix_folders=${matrix_folders/'models/'/'models_'}

+ echo "$matrix_folders"

+ echo "matrix_folders=$matrix_folders" >> $GITHUB_ENV

+

+ - name: Update clone

+ working-directory: /transformers

+ run: git fetch && git checkout ${{ github.sha }}

+

+ - name: Reinstall transformers in edit mode (remove the one installed during docker image build)

+ working-directory: /transformers

+ run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ - name: Environment

+ working-directory: /transformers

+ run: |

+ python3 utils/print_env.py

+

+ - name: Show installed libraries and their versions

+ working-directory: /transformers

+ run: pip freeze

+

+ - name: Run all tests on GPU

+ working-directory: /transformers

+ run: python3 -m pytest -v --make-reports=${{ matrix.machine_type }}_tests_gpu_${{ matrix.folders }} tests/${{ matrix.folders }}

+

+ - name: Failure short reports

+ if: ${{ failure() }}

+ continue-on-error: true

+ run: cat /transformers/reports/${{ matrix.machine_type }}_tests_gpu_${{ matrix.folders }}/failures_short.txt

+

+ - name: Test suite reports artifacts

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: ${{ matrix.machine_type }}_run_all_tests_gpu_${{ env.matrix_folders }}_test_reports

+ path: /transformers/reports/${{ matrix.machine_type }}_tests_gpu_${{ matrix.folders }}

+

+ run_tests_multi_gpu:

+ name: Multi GPU tests

+ strategy:

+ max-parallel: 1

+ fail-fast: false

+ matrix:

+ folders: ${{ fromJson(needs.setup.outputs.matrix) }}

+ machine_type: [multi-gpu]

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ container:

+ image: huggingface/transformers-pytorch-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ needs: setup

+ steps:

+ - name: Echo folder ${{ matrix.folders }}

+ shell: bash

+ # For folders like `models/bert`, set an env. var. (`matrix_folders`) to `models_bert`, which will be used to

+ # set the artifact folder names (because the character `/` is not allowed).

+ run: |

+ echo "${{ matrix.folders }}"

+ matrix_folders=${{ matrix.folders }}

+ matrix_folders=${matrix_folders/'models/'/'models_'}

+ echo "$matrix_folders"

+ echo "matrix_folders=$matrix_folders" >> $GITHUB_ENV

+

+ - name: Update clone

+ working-directory: /transformers

+ run: git fetch && git checkout ${{ github.sha }}

+

+ - name: Reinstall transformers in edit mode (remove the one installed during docker image build)

+ working-directory: /transformers

+ run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ - name: Environment

+ working-directory: /transformers

+ run: |

+ python3 utils/print_env.py

+

+ - name: Show installed libraries and their versions

+ working-directory: /transformers

+ run: pip freeze

+

+ - name: Run all tests on GPU

+ working-directory: /transformers

+ run: python3 -m pytest -v --make-reports=${{ matrix.machine_type }}_tests_gpu_${{ matrix.folders }} tests/${{ matrix.folders }}

+

+ - name: Failure short reports

+ if: ${{ failure() }}

+ continue-on-error: true

+ run: cat /transformers/reports/${{ matrix.machine_type }}_tests_gpu_${{ matrix.folders }}/failures_short.txt

+

+ - name: Test suite reports artifacts

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: ${{ matrix.machine_type }}_run_all_tests_gpu_${{ env.matrix_folders }}_test_reports

+ path: /transformers/reports/${{ matrix.machine_type }}_tests_gpu_${{ matrix.folders }}

+

+ run_examples_gpu:

+ name: Examples tests

+ strategy:

+ fail-fast: false

+ matrix:

+ machine_type: [single-gpu]

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ container:

+ image: huggingface/transformers-pytorch-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ needs: setup

+ steps:

+ - name: Update clone

+ working-directory: /transformers

+ run: git fetch && git checkout ${{ github.sha }}

+

+ - name: Reinstall transformers in edit mode (remove the one installed during docker image build)

+ working-directory: /transformers

+ run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ - name: Environment

+ working-directory: /transformers

+ run: |

+ python3 utils/print_env.py

+

+ - name: Show installed libraries and their versions

+ working-directory: /transformers

+ run: pip freeze

+

+ - name: Run examples tests on GPU

+ working-directory: /transformers

+ run: |

+ pip install -r examples/pytorch/_tests_requirements.txt

+ python3 -m pytest -v --make-reports=${{ matrix.machine_type }}_examples_gpu examples/pytorch

+

+ - name: Failure short reports

+ if: ${{ failure() }}

+ continue-on-error: true

+ run: cat /transformers/reports/${{ matrix.machine_type }}_examples_gpu/failures_short.txt

+

+ - name: Test suite reports artifacts

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: ${{ matrix.machine_type }}_run_examples_gpu

+ path: /transformers/reports/${{ matrix.machine_type }}_examples_gpu

+

+ run_pipelines_torch_gpu:

+ name: PyTorch pipelines tests

+ strategy:

+ fail-fast: false

+ matrix:

+ machine_type: [single-gpu, multi-gpu]

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ container:

+ image: huggingface/transformers-pytorch-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ needs: setup

+ steps:

+ - name: Update clone

+ working-directory: /transformers

+ run: git fetch && git checkout ${{ github.sha }}

+

+ - name: Reinstall transformers in edit mode (remove the one installed during docker image build)

+ working-directory: /transformers

+ run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ - name: Environment

+ working-directory: /transformers

+ run: |

+ python3 utils/print_env.py

+

+ - name: Show installed libraries and their versions

+ working-directory: /transformers

+ run: pip freeze

+

+ - name: Run all pipeline tests on GPU

+ working-directory: /transformers

+ run: |

+ python3 -m pytest -n 1 -v --dist=loadfile --make-reports=${{ matrix.machine_type }}_tests_torch_pipeline_gpu tests/pipelines

+

+ - name: Failure short reports

+ if: ${{ failure() }}

+ continue-on-error: true

+ run: cat /transformers/reports/${{ matrix.machine_type }}_tests_torch_pipeline_gpu/failures_short.txt

+

+ - name: Test suite reports artifacts

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: ${{ matrix.machine_type }}_run_tests_torch_pipeline_gpu

+ path: /transformers/reports/${{ matrix.machine_type }}_tests_torch_pipeline_gpu

+

+ run_tests_torch_deepspeed_gpu:

+ name: Torch ROCm deepspeed tests

+ strategy:

+ fail-fast: false

+ matrix:

+ machine_type: [single-gpu, multi-gpu]

+

+ runs-on: [self-hosted, docker-gpu, amd-gpu, '${{ matrix.machine_type }}', '${{ inputs.gpu_flavor }}']

+ needs: setup

+ container:

+ image: huggingface/transformers-pytorch-deepspeed-amd-gpu

+ options: --device /dev/kfd --device /dev/dri --env ROCR_VISIBLE_DEVICES --shm-size "16gb" --ipc host -v /mnt/cache/.cache/huggingface:/mnt/cache/

+ steps:

+ - name: Update clone

+ working-directory: /transformers

+ run: git fetch && git checkout ${{ github.sha }}

+

+ - name: Reinstall transformers in edit mode (remove the one installed during docker image build)

+ working-directory: /transformers

+ run: python3 -m pip uninstall -y transformers && python3 -m pip install -e .

+

+ - name: ROCM-SMI

+ run: |

+ rocm-smi

+ - name: ROCM-INFO

+ run: |

+ rocminfo | grep "Agent" -A 14

+

+ - name: Show ROCR environment

+ run: |

+ echo "ROCR: $ROCR_VISIBLE_DEVICES"

+

+ - name: Environment

+ working-directory: /transformers

+ run: |

+ python3 utils/print_env.py

+

+ - name: Show installed libraries and their versions

+ working-directory: /transformers

+ run: pip freeze

+

+ - name: Run all tests on GPU

+ working-directory: /transformers

+ run: python3 -m pytest -v --make-reports=${{ matrix.machine_type }}_tests_torch_deepspeed_gpu tests/deepspeed tests/extended

+

+ - name: Failure short reports

+ if: ${{ failure() }}

+ continue-on-error: true

+ run: cat /transformers/reports/${{ matrix.machine_type }}_tests_torch_deepspeed_gpu/failures_short.txt

+

+ - name: Test suite reports artifacts

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: ${{ matrix.machine_type }}_run_tests_torch_deepspeed_gpu_test_reports

+ path: /transformers/reports/${{ matrix.machine_type }}_tests_torch_deepspeed_gpu

+

+ run_extract_warnings:

+ name: Extract warnings in CI artifacts

+ runs-on: ubuntu-22.04

+ if: always()

+ needs: [

+ check_runner_status,

+ check_runners,

+ setup,

+ run_tests_single_gpu,

+ run_tests_multi_gpu,

+ run_examples_gpu,

+ run_pipelines_torch_gpu,

+ run_tests_torch_deepspeed_gpu

+ ]

+ steps:

+ - name: Checkout transformers

+ uses: actions/checkout@v3

+ with:

+ fetch-depth: 2

+

+ - name: Install transformers

+ run: pip install transformers

+

+ - name: Show installed libraries and their versions

+ run: pip freeze

+

+ - name: Create output directory

+ run: mkdir warnings_in_ci

+

+ - uses: actions/download-artifact@v3

+ with:

+ path: warnings_in_ci

+

+ - name: Show artifacts

+ run: echo "$(python3 -c 'import os; d = os.listdir(); print(d)')"

+ working-directory: warnings_in_ci

+

+ - name: Extract warnings in CI artifacts

+ run: |

+ python3 utils/extract_warnings.py --workflow_run_id ${{ github.run_id }} --output_dir warnings_in_ci --token ${{ secrets.ACCESS_REPO_INFO_TOKEN }} --from_gh

+ echo "$(python3 -c 'import os; import json; fp = open("warnings_in_ci/selected_warnings.json"); d = json.load(fp); d = "\n".join(d) ;print(d)')"

+

+ - name: Upload artifact

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: warnings_in_ci

+ path: warnings_in_ci/selected_warnings.json

+

+ send_results:

+ name: Send results to webhook

+ runs-on: ubuntu-22.04

+ if: always()

+ needs: [

+ check_runner_status,

+ check_runners,

+ setup,

+ run_tests_single_gpu,

+ run_tests_multi_gpu,

+ run_examples_gpu,

+ run_pipelines_torch_gpu,

+ run_tests_torch_deepspeed_gpu,

+ run_extract_warnings

+ ]

+ steps:

+ - name: Preliminary job status

+ shell: bash

+ # For the meaning of these environment variables, see the job `Setup`

+ run: |

+ echo "Runner availability: ${{ needs.check_runner_status.result }}"

+ echo "Runner status: ${{ needs.check_runners.result }}"

+ echo "Setup status: ${{ needs.setup.result }}"

+

+ - uses: actions/checkout@v3

+ - uses: actions/download-artifact@v3

+ - name: Send message to Slack

+ env:

+ CI_SLACK_BOT_TOKEN: ${{ secrets.CI_SLACK_BOT_TOKEN }}

+ CI_SLACK_CHANNEL_ID_DAILY_AMD: ${{ secrets.CI_SLACK_CHANNEL_ID_DAILY_AMD }}

+ CI_SLACK_CHANNEL_DUMMY_TESTS: ${{ secrets.CI_SLACK_CHANNEL_DUMMY_TESTS }}

+ CI_SLACK_REPORT_CHANNEL_ID: ${{ secrets.CI_SLACK_CHANNEL_ID_DAILY_AMD }}

+ ACCESS_REPO_INFO_TOKEN: ${{ secrets.ACCESS_REPO_INFO_TOKEN }}

+ CI_EVENT: Scheduled CI (AMD) - ${{ inputs.gpu_flavor }}

+ CI_SHA: ${{ github.sha }}

+ CI_WORKFLOW_REF: ${{ github.workflow_ref }}

+ RUNNER_STATUS: ${{ needs.check_runner_status.result }}

+ RUNNER_ENV_STATUS: ${{ needs.check_runners.result }}

+ SETUP_STATUS: ${{ needs.setup.result }}

+ # We pass `needs.setup.outputs.matrix` as the argument. A processing in `notification_service.py` to change

+ # `models/bert` to `models_bert` is required, as the artifact names use `_` instead of `/`.

+ run: |

+ sudo apt-get install -y curl

+ pip install slack_sdk

+ pip show slack_sdk

+ python utils/notification_service.py "${{ needs.setup.outputs.matrix }}"

+

+ # Upload complete failure tables, as they might be big and only truncated versions could be sent to Slack.

+ - name: Failure table artifacts

+ if: ${{ always() }}

+ uses: actions/upload-artifact@v3

+ with:

+ name: test_failure_tables

+ path: test_failure_tables

diff --git a/.github/workflows/self-scheduled.yml b/.github/workflows/self-scheduled.yml

index 4a04cb14ac7bb3..995df2e07880ac 100644

--- a/.github/workflows/self-scheduled.yml

+++ b/.github/workflows/self-scheduled.yml

@@ -366,7 +366,7 @@ jobs:

working-directory: /workspace

run: |

python3 -m pip uninstall -y deepspeed

- DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 DS_BUILD_UTILS=1 python3 -m pip install deepspeed --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

+ DS_BUILD_CPU_ADAM=1 DS_BUILD_FUSED_ADAM=1 python3 -m pip install deepspeed --global-option="build_ext" --global-option="-j8" --no-cache -v --disable-pip-version-check

- name: NVIDIA-SMI

run: |

@@ -494,5 +494,5 @@ jobs:

if: ${{ always() }}

uses: actions/upload-artifact@v3

with:

- name: test_failure_tables

- path: test_failure_tables

+ name: prev_ci_results

+ path: prev_ci_results

diff --git a/ISSUES.md b/ISSUES.md

index 95f2334b26c803..a5969a3027f86d 100644

--- a/ISSUES.md

+++ b/ISSUES.md

@@ -152,7 +152,7 @@ You are not required to read the following guidelines before opening an issue. H

```bash

cd examples/seq2seq

- python -m torch.distributed.launch --nproc_per_node=2 ./finetune_trainer.py \

+ torchrun --nproc_per_node=2 ./finetune_trainer.py \

--model_name_or_path sshleifer/distill-mbart-en-ro-12-4 --data_dir wmt_en_ro \

--output_dir output_dir --overwrite_output_dir \

--do_train --n_train 500 --num_train_epochs 1 \

diff --git a/README.md b/README.md

index 12724e60a1881d..4598868474b4c3 100644

--- a/README.md

+++ b/README.md

@@ -397,12 +397,14 @@ Current number of checkpoints: ** (from South China University of Technology) released with the paper [LiLT: A Simple yet Effective Language-Independent Layout Transformer for Structured Document Understanding](https://arxiv.org/abs/2202.13669) by Jiapeng Wang, Lianwen Jin, Kai Ding.

1. **[LLaMA](https://huggingface.co/docs/transformers/model_doc/llama)** (from The FAIR team of Meta AI) released with the paper [LLaMA: Open and Efficient Foundation Language Models](https://arxiv.org/abs/2302.13971) by Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, Aurelien Rodriguez, Armand Joulin, Edouard Grave, Guillaume Lample.

1. **[Llama2](https://huggingface.co/docs/transformers/model_doc/llama2)** (from The FAIR team of Meta AI) released with the paper [Llama2: Open Foundation and Fine-Tuned Chat Models](https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/) by Hugo Touvron, Louis Martin, Kevin Stone, Peter Albert, Amjad Almahairi, Yasmine Babaei, Nikolay Bashlykov, Soumya Batra, Prajjwal Bhargava, Shruti Bhosale, Dan Bikel, Lukas Blecher, Cristian Canton Ferrer, Moya Chen, Guillem Cucurull, David Esiobu, Jude Fernandes, Jeremy Fu, Wenyin Fu, Brian Fuller, Cynthia Gao, Vedanuj Goswami, Naman Goyal, Anthony Hartshorn, Saghar Hosseini, Rui Hou, Hakan Inan, Marcin Kardas, Viktor Kerkez Madian Khabsa, Isabel Kloumann, Artem Korenev, Punit Singh Koura, Marie-Anne Lachaux, Thibaut Lavril, Jenya Lee, Diana Liskovich, Yinghai Lu, Yuning Mao, Xavier Martinet, Todor Mihaylov, Pushka rMishra, Igor Molybog, Yixin Nie, Andrew Poulton, Jeremy Reizenstein, Rashi Rungta, Kalyan Saladi, Alan Schelten, Ruan Silva, Eric Michael Smith, Ranjan Subramanian, Xiaoqing EllenTan, Binh Tang, Ross Taylor, Adina Williams, Jian Xiang Kuan, Puxin Xu, Zheng Yan, Iliyan Zarov, Yuchen Zhang, Angela Fan, Melanie Kambadur, Sharan Narang, Aurelien Rodriguez, Robert Stojnic, Sergey Edunov, Thomas Scialom.

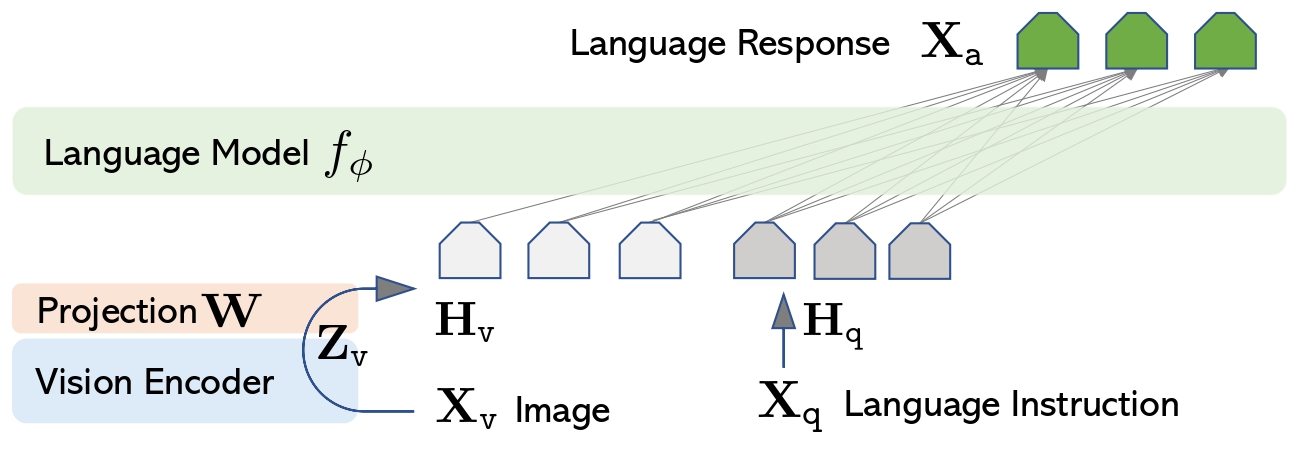

+1. **[LLaVa](https://huggingface.co/docs/transformers/main/model_doc/llava)** (from Microsoft Research & University of Wisconsin-Madison) released with the paper [Visual Instruction Tuning](https://arxiv.org/abs/2304.08485) by Haotian Liu, Chunyuan Li, Yuheng Li and Yong Jae Lee.

1. **[Longformer](https://huggingface.co/docs/transformers/model_doc/longformer)** (from AllenAI) released with the paper [Longformer: The Long-Document Transformer](https://arxiv.org/abs/2004.05150) by Iz Beltagy, Matthew E. Peters, Arman Cohan.

1. **[LongT5](https://huggingface.co/docs/transformers/model_doc/longt5)** (from Google AI) released with the paper [LongT5: Efficient Text-To-Text Transformer for Long Sequences](https://arxiv.org/abs/2112.07916) by Mandy Guo, Joshua Ainslie, David Uthus, Santiago Ontanon, Jianmo Ni, Yun-Hsuan Sung, Yinfei Yang.

1. **[LUKE](https://huggingface.co/docs/transformers/model_doc/luke)** (from Studio Ousia) released with the paper [LUKE: Deep Contextualized Entity Representations with Entity-aware Self-attention](https://arxiv.org/abs/2010.01057) by Ikuya Yamada, Akari Asai, Hiroyuki Shindo, Hideaki Takeda, Yuji Matsumoto.

1. **[LXMERT](https://huggingface.co/docs/transformers/model_doc/lxmert)** (from UNC Chapel Hill) released with the paper [LXMERT: Learning Cross-Modality Encoder Representations from Transformers for Open-Domain Question Answering](https://arxiv.org/abs/1908.07490) by Hao Tan and Mohit Bansal.

1. **[M-CTC-T](https://huggingface.co/docs/transformers/model_doc/mctct)** (from Facebook) released with the paper [Pseudo-Labeling For Massively Multilingual Speech Recognition](https://arxiv.org/abs/2111.00161) by Loren Lugosch, Tatiana Likhomanenko, Gabriel Synnaeve, and Ronan Collobert.

1. **[M2M100](https://huggingface.co/docs/transformers/model_doc/m2m_100)** (from Facebook) released with the paper [Beyond English-Centric Multilingual Machine Translation](https://arxiv.org/abs/2010.11125) by Angela Fan, Shruti Bhosale, Holger Schwenk, Zhiyi Ma, Ahmed El-Kishky, Siddharth Goyal, Mandeep Baines, Onur Celebi, Guillaume Wenzek, Vishrav Chaudhary, Naman Goyal, Tom Birch, Vitaliy Liptchinsky, Sergey Edunov, Edouard Grave, Michael Auli, Armand Joulin.

+1. **[MADLAD-400](https://huggingface.co/docs/transformers/model_doc/madlad-400)** (from Google) released with the paper [MADLAD-400: A Multilingual And Document-Level Large Audited Dataset](https://arxiv.org/abs/2309.04662) by Sneha Kudugunta, Isaac Caswell, Biao Zhang, Xavier Garcia, Christopher A. Choquette-Choo, Katherine Lee, Derrick Xin, Aditya Kusupati, Romi Stella, Ankur Bapna, Orhan Firat.

1. **[MarianMT](https://huggingface.co/docs/transformers/model_doc/marian)** Machine translation models trained using [OPUS](http://opus.nlpl.eu/) data by Jörg Tiedemann. The [Marian Framework](https://marian-nmt.github.io/) is being developed by the Microsoft Translator Team.

1. **[MarkupLM](https://huggingface.co/docs/transformers/model_doc/markuplm)** (from Microsoft Research Asia) released with the paper [MarkupLM: Pre-training of Text and Markup Language for Visually-rich Document Understanding](https://arxiv.org/abs/2110.08518) by Junlong Li, Yiheng Xu, Lei Cui, Furu Wei.

1. **[Mask2Former](https://huggingface.co/docs/transformers/model_doc/mask2former)** (from FAIR and UIUC) released with the paper [Masked-attention Mask Transformer for Universal Image Segmentation](https://arxiv.org/abs/2112.01527) by Bowen Cheng, Ishan Misra, Alexander G. Schwing, Alexander Kirillov, Rohit Girdhar.

@@ -415,6 +417,7 @@ Current number of checkpoints: ** (from NVIDIA) released with the paper [Megatron-LM: Training Multi-Billion Parameter Language Models Using Model Parallelism](https://arxiv.org/abs/1909.08053) by Mohammad Shoeybi, Mostofa Patwary, Raul Puri, Patrick LeGresley, Jared Casper and Bryan Catanzaro.

1. **[MGP-STR](https://huggingface.co/docs/transformers/model_doc/mgp-str)** (from Alibaba Research) released with the paper [Multi-Granularity Prediction for Scene Text Recognition](https://arxiv.org/abs/2209.03592) by Peng Wang, Cheng Da, and Cong Yao.

1. **[Mistral](https://huggingface.co/docs/transformers/model_doc/mistral)** (from Mistral AI) by The [Mistral AI](https://mistral.ai) team: Albert Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lélio Renard Lavaud, Lucile Saulnier, Marie-Anne Lachaux, Pierre Stock, Teven Le Scao, Thibaut Lavril, Thomas Wang, Timothée Lacroix, William El Sayed.

+1. **[Mixtral](https://huggingface.co/docs/transformers/main/model_doc/mixtral)** (from Mistral AI) by The [Mistral AI](https://mistral.ai) team: Albert Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lélio Renard Lavaud, Lucile Saulnier, Marie-Anne Lachaux, Pierre Stock, Teven Le Scao, Thibaut Lavril, Thomas Wang, Timothée Lacroix, William El Sayed.

1. **[mLUKE](https://huggingface.co/docs/transformers/model_doc/mluke)** (from Studio Ousia) released with the paper [mLUKE: The Power of Entity Representations in Multilingual Pretrained Language Models](https://arxiv.org/abs/2110.08151) by Ryokan Ri, Ikuya Yamada, and Yoshimasa Tsuruoka.

1. **[MMS](https://huggingface.co/docs/transformers/model_doc/mms)** (from Facebook) released with the paper [Scaling Speech Technology to 1,000+ Languages](https://arxiv.org/abs/2305.13516) by Vineel Pratap, Andros Tjandra, Bowen Shi, Paden Tomasello, Arun Babu, Sayani Kundu, Ali Elkahky, Zhaoheng Ni, Apoorv Vyas, Maryam Fazel-Zarandi, Alexei Baevski, Yossi Adi, Xiaohui Zhang, Wei-Ning Hsu, Alexis Conneau, Michael Auli.

1. **[MobileBERT](https://huggingface.co/docs/transformers/model_doc/mobilebert)** (from CMU/Google Brain) released with the paper [MobileBERT: a Compact Task-Agnostic BERT for Resource-Limited Devices](https://arxiv.org/abs/2004.02984) by Zhiqing Sun, Hongkun Yu, Xiaodan Song, Renjie Liu, Yiming Yang, and Denny Zhou.

@@ -439,6 +442,8 @@ Current number of checkpoints: ** (from Meta AI) released with the paper [OPT: Open Pre-trained Transformer Language Models](https://arxiv.org/abs/2205.01068) by Susan Zhang, Stephen Roller, Naman Goyal, Mikel Artetxe, Moya Chen, Shuohui Chen et al.

1. **[OWL-ViT](https://huggingface.co/docs/transformers/model_doc/owlvit)** (from Google AI) released with the paper [Simple Open-Vocabulary Object Detection with Vision Transformers](https://arxiv.org/abs/2205.06230) by Matthias Minderer, Alexey Gritsenko, Austin Stone, Maxim Neumann, Dirk Weissenborn, Alexey Dosovitskiy, Aravindh Mahendran, Anurag Arnab, Mostafa Dehghani, Zhuoran Shen, Xiao Wang, Xiaohua Zhai, Thomas Kipf, and Neil Houlsby.

1. **[OWLv2](https://huggingface.co/docs/transformers/model_doc/owlv2)** (from Google AI) released with the paper [Scaling Open-Vocabulary Object Detection](https://arxiv.org/abs/2306.09683) by Matthias Minderer, Alexey Gritsenko, Neil Houlsby.

+1. **[PatchTSMixer](https://huggingface.co/docs/transformers/main/model_doc/patchtsmixer)** (from IBM Research) released with the paper [TSMixer: Lightweight MLP-Mixer Model for Multivariate Time Series Forecasting](https://arxiv.org/pdf/2306.09364.pdf) by Vijay Ekambaram, Arindam Jati, Nam Nguyen, Phanwadee Sinthong, Jayant Kalagnanam.

+1. **[PatchTST](https://huggingface.co/docs/transformers/main/model_doc/patchtst)** (from IBM) released with the paper [A Time Series is Worth 64 Words: Long-term Forecasting with Transformers](https://arxiv.org/abs/2211.14730) by Yuqi Nie, Nam H. Nguyen, Phanwadee Sinthong, Jayant Kalagnanam.

1. **[Pegasus](https://huggingface.co/docs/transformers/model_doc/pegasus)** (from Google) released with the paper [PEGASUS: Pre-training with Extracted Gap-sentences for Abstractive Summarization](https://arxiv.org/abs/1912.08777) by Jingqing Zhang, Yao Zhao, Mohammad Saleh and Peter J. Liu.

1. **[PEGASUS-X](https://huggingface.co/docs/transformers/model_doc/pegasus_x)** (from Google) released with the paper [Investigating Efficiently Extending Transformers for Long Input Summarization](https://arxiv.org/abs/2208.04347) by Jason Phang, Yao Zhao, and Peter J. Liu.

1. **[Perceiver IO](https://huggingface.co/docs/transformers/model_doc/perceiver)** (from Deepmind) released with the paper [Perceiver IO: A General Architecture for Structured Inputs & Outputs](https://arxiv.org/abs/2107.14795) by Andrew Jaegle, Sebastian Borgeaud, Jean-Baptiste Alayrac, Carl Doersch, Catalin Ionescu, David Ding, Skanda Koppula, Daniel Zoran, Andrew Brock, Evan Shelhamer, Olivier Hénaff, Matthew M. Botvinick, Andrew Zisserman, Oriol Vinyals, João Carreira.

@@ -464,6 +469,7 @@ Current number of checkpoints: ** (from ZhuiyiTechnology), released together with the paper [RoFormer: Enhanced Transformer with Rotary Position Embedding](https://arxiv.org/abs/2104.09864) by Jianlin Su and Yu Lu and Shengfeng Pan and Bo Wen and Yunfeng Liu.

1. **[RWKV](https://huggingface.co/docs/transformers/model_doc/rwkv)** (from Bo Peng), released on [this repo](https://github.com/BlinkDL/RWKV-LM) by Bo Peng.

1. **[SeamlessM4T](https://huggingface.co/docs/transformers/model_doc/seamless_m4t)** (from Meta AI) released with the paper [SeamlessM4T — Massively Multilingual & Multimodal Machine Translation](https://dl.fbaipublicfiles.com/seamless/seamless_m4t_paper.pdf) by the Seamless Communication team.

+1. **[SeamlessM4Tv2](https://huggingface.co/docs/transformers/main/model_doc/seamless_m4t_v2)** (from Meta AI) released with the paper [Seamless: Multilingual Expressive and Streaming Speech Translation](https://ai.meta.com/research/publications/seamless-multilingual-expressive-and-streaming-speech-translation/) by the Seamless Communication team.

1. **[SegFormer](https://huggingface.co/docs/transformers/model_doc/segformer)** (from NVIDIA) released with the paper [SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers](https://arxiv.org/abs/2105.15203) by Enze Xie, Wenhai Wang, Zhiding Yu, Anima Anandkumar, Jose M. Alvarez, Ping Luo.

1. **[Segment Anything](https://huggingface.co/docs/transformers/model_doc/sam)** (from Meta AI) released with the paper [Segment Anything](https://arxiv.org/pdf/2304.02643v1.pdf) by Alexander Kirillov, Eric Mintun, Nikhila Ravi, Hanzi Mao, Chloe Rolland, Laura Gustafson, Tete Xiao, Spencer Whitehead, Alex Berg, Wan-Yen Lo, Piotr Dollar, Ross Girshick.

1. **[SEW](https://huggingface.co/docs/transformers/model_doc/sew)** (from ASAPP) released with the paper [Performance-Efficiency Trade-offs in Unsupervised Pre-training for Speech Recognition](https://arxiv.org/abs/2109.06870) by Felix Wu, Kwangyoun Kim, Jing Pan, Kyu Han, Kilian Q. Weinberger, Yoav Artzi.

@@ -489,14 +495,17 @@ Current number of checkpoints: ** (from Google/CMU) released with the paper [Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context](https://arxiv.org/abs/1901.02860) by Zihang Dai*, Zhilin Yang*, Yiming Yang, Jaime Carbonell, Quoc V. Le, Ruslan Salakhutdinov.

1. **[TrOCR](https://huggingface.co/docs/transformers/model_doc/trocr)** (from Microsoft), released together with the paper [TrOCR: Transformer-based Optical Character Recognition with Pre-trained Models](https://arxiv.org/abs/2109.10282) by Minghao Li, Tengchao Lv, Lei Cui, Yijuan Lu, Dinei Florencio, Cha Zhang, Zhoujun Li, Furu Wei.

1. **[TVLT](https://huggingface.co/docs/transformers/model_doc/tvlt)** (from UNC Chapel Hill) released with the paper [TVLT: Textless Vision-Language Transformer](https://arxiv.org/abs/2209.14156) by Zineng Tang, Jaemin Cho, Yixin Nie, Mohit Bansal.

+1. **[TVP](https://huggingface.co/docs/transformers/model_doc/tvp)** (from Intel) released with the paper [Text-Visual Prompting for Efficient 2D Temporal Video Grounding](https://arxiv.org/abs/2303.04995) by Yimeng Zhang, Xin Chen, Jinghan Jia, Sijia Liu, Ke Ding.

1. **[UL2](https://huggingface.co/docs/transformers/model_doc/ul2)** (from Google Research) released with the paper [Unifying Language Learning Paradigms](https://arxiv.org/abs/2205.05131v1) by Yi Tay, Mostafa Dehghani, Vinh Q. Tran, Xavier Garcia, Dara Bahri, Tal Schuster, Huaixiu Steven Zheng, Neil Houlsby, Donald Metzler

1. **[UMT5](https://huggingface.co/docs/transformers/model_doc/umt5)** (from Google Research) released with the paper [UniMax: Fairer and More Effective Language Sampling for Large-Scale Multilingual Pretraining](https://openreview.net/forum?id=kXwdL1cWOAi) by Hyung Won Chung, Xavier Garcia, Adam Roberts, Yi Tay, Orhan Firat, Sharan Narang, Noah Constant.

1. **[UniSpeech](https://huggingface.co/docs/transformers/model_doc/unispeech)** (from Microsoft Research) released with the paper [UniSpeech: Unified Speech Representation Learning with Labeled and Unlabeled Data](https://arxiv.org/abs/2101.07597) by Chengyi Wang, Yu Wu, Yao Qian, Kenichi Kumatani, Shujie Liu, Furu Wei, Michael Zeng, Xuedong Huang.

1. **[UniSpeechSat](https://huggingface.co/docs/transformers/model_doc/unispeech-sat)** (from Microsoft Research) released with the paper [UNISPEECH-SAT: UNIVERSAL SPEECH REPRESENTATION LEARNING WITH SPEAKER AWARE PRE-TRAINING](https://arxiv.org/abs/2110.05752) by Sanyuan Chen, Yu Wu, Chengyi Wang, Zhengyang Chen, Zhuo Chen, Shujie Liu, Jian Wu, Yao Qian, Furu Wei, Jinyu Li, Xiangzhan Yu.

+1. **[UnivNet](https://huggingface.co/docs/transformers/main/model_doc/univnet)** (from Kakao Corporation) released with the paper [UnivNet: A Neural Vocoder with Multi-Resolution Spectrogram Discriminators for High-Fidelity Waveform Generation](https://arxiv.org/abs/2106.07889) by Won Jang, Dan Lim, Jaesam Yoon, Bongwan Kim, and Juntae Kim.

1. **[UPerNet](https://huggingface.co/docs/transformers/model_doc/upernet)** (from Peking University) released with the paper [Unified Perceptual Parsing for Scene Understanding](https://arxiv.org/abs/1807.10221) by Tete Xiao, Yingcheng Liu, Bolei Zhou, Yuning Jiang, Jian Sun.

1. **[VAN](https://huggingface.co/docs/transformers/model_doc/van)** (from Tsinghua University and Nankai University) released with the paper [Visual Attention Network](https://arxiv.org/abs/2202.09741) by Meng-Hao Guo, Cheng-Ze Lu, Zheng-Ning Liu, Ming-Ming Cheng, Shi-Min Hu.

1. **[VideoMAE](https://huggingface.co/docs/transformers/model_doc/videomae)** (from Multimedia Computing Group, Nanjing University) released with the paper [VideoMAE: Masked Autoencoders are Data-Efficient Learners for Self-Supervised Video Pre-Training](https://arxiv.org/abs/2203.12602) by Zhan Tong, Yibing Song, Jue Wang, Limin Wang.

1. **[ViLT](https://huggingface.co/docs/transformers/model_doc/vilt)** (from NAVER AI Lab/Kakao Enterprise/Kakao Brain) released with the paper [ViLT: Vision-and-Language Transformer Without Convolution or Region Supervision](https://arxiv.org/abs/2102.03334) by Wonjae Kim, Bokyung Son, Ildoo Kim.

+1. **[VipLlava](https://huggingface.co/docs/transformers/main/model_doc/vipllava)** (from University of Wisconsin–Madison) released with the paper [Making Large Multimodal Models Understand Arbitrary Visual Prompts](https://arxiv.org/abs/2312.00784) by Mu Cai, Haotian Liu, Siva Karthik Mustikovela, Gregory P. Meyer, Yuning Chai, Dennis Park, Yong Jae Lee.

1. **[Vision Transformer (ViT)](https://huggingface.co/docs/transformers/model_doc/vit)** (from Google AI) released with the paper [An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale](https://arxiv.org/abs/2010.11929) by Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby.

1. **[VisualBERT](https://huggingface.co/docs/transformers/model_doc/visual_bert)** (from UCLA NLP) released with the paper [VisualBERT: A Simple and Performant Baseline for Vision and Language](https://arxiv.org/pdf/1908.03557) by Liunian Harold Li, Mark Yatskar, Da Yin, Cho-Jui Hsieh, Kai-Wei Chang.

1. **[ViT Hybrid](https://huggingface.co/docs/transformers/model_doc/vit_hybrid)** (from Google AI) released with the paper [An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale](https://arxiv.org/abs/2010.11929) by Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby.

diff --git a/README_es.md b/README_es.md

index 5cdbc27ec7918d..52a35cfb96a948 100644

--- a/README_es.md

+++ b/README_es.md

@@ -372,12 +372,14 @@ Número actual de puntos de control: ** (from South China University of Technology) released with the paper [LiLT: A Simple yet Effective Language-Independent Layout Transformer for Structured Document Understanding](https://arxiv.org/abs/2202.13669) by Jiapeng Wang, Lianwen Jin, Kai Ding.

1. **[LLaMA](https://huggingface.co/docs/transformers/model_doc/llama)** (from The FAIR team of Meta AI) released with the paper [LLaMA: Open and Efficient Foundation Language Models](https://arxiv.org/abs/2302.13971) by Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, Aurelien Rodriguez, Armand Joulin, Edouard Grave, Guillaume Lample.

1. **[Llama2](https://huggingface.co/docs/transformers/model_doc/llama2)** (from The FAIR team of Meta AI) released with the paper [Llama2: Open Foundation and Fine-Tuned Chat Models](https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/XXX) by Hugo Touvron, Louis Martin, Kevin Stone, Peter Albert, Amjad Almahairi, Yasmine Babaei, Nikolay Bashlykov, Soumya Batra, Prajjwal Bhargava, Shruti Bhosale, Dan Bikel, Lukas Blecher, Cristian Canton Ferrer, Moya Chen, Guillem Cucurull, David Esiobu, Jude Fernandes, Jeremy Fu, Wenyin Fu, Brian Fuller, Cynthia Gao, Vedanuj Goswami, Naman Goyal, Anthony Hartshorn, Saghar Hosseini, Rui Hou, Hakan Inan, Marcin Kardas, Viktor Kerkez Madian Khabsa, Isabel Kloumann, Artem Korenev, Punit Singh Koura, Marie-Anne Lachaux, Thibaut Lavril, Jenya Lee, Diana Liskovich, Yinghai Lu, Yuning Mao, Xavier Martinet, Todor Mihaylov, Pushka rMishra, Igor Molybog, Yixin Nie, Andrew Poulton, Jeremy Reizenstein, Rashi Rungta, Kalyan Saladi, Alan Schelten, Ruan Silva, Eric Michael Smith, Ranjan Subramanian, Xiaoqing EllenTan, Binh Tang, Ross Taylor, Adina Williams, Jian Xiang Kuan, Puxin Xu, Zheng Yan, Iliyan Zarov, Yuchen Zhang, Angela Fan, Melanie Kambadur, Sharan Narang, Aurelien Rodriguez, Robert Stojnic, Sergey Edunov, Thomas Scialom..

+1. **[LLaVa](https://huggingface.co/docs/transformers/main/model_doc/llava)** (from Microsoft Research & University of Wisconsin-Madison) released with the paper [Visual Instruction Tuning](https://arxiv.org/abs/2304.08485) by Haotian Liu, Chunyuan Li, Yuheng Li and Yong Jae Lee.

1. **[Longformer](https://huggingface.co/docs/transformers/model_doc/longformer)** (from AllenAI) released with the paper [Longformer: The Long-Document Transformer](https://arxiv.org/abs/2004.05150) by Iz Beltagy, Matthew E. Peters, Arman Cohan.

1. **[LongT5](https://huggingface.co/docs/transformers/model_doc/longt5)** (from Google AI) released with the paper [LongT5: Efficient Text-To-Text Transformer for Long Sequences](https://arxiv.org/abs/2112.07916) by Mandy Guo, Joshua Ainslie, David Uthus, Santiago Ontanon, Jianmo Ni, Yun-Hsuan Sung, Yinfei Yang.

1. **[LUKE](https://huggingface.co/docs/transformers/model_doc/luke)** (from Studio Ousia) released with the paper [LUKE: Deep Contextualized Entity Representations with Entity-aware Self-attention](https://arxiv.org/abs/2010.01057) by Ikuya Yamada, Akari Asai, Hiroyuki Shindo, Hideaki Takeda, Yuji Matsumoto.

1. **[LXMERT](https://huggingface.co/docs/transformers/model_doc/lxmert)** (from UNC Chapel Hill) released with the paper [LXMERT: Learning Cross-Modality Encoder Representations from Transformers for Open-Domain Question Answering](https://arxiv.org/abs/1908.07490) by Hao Tan and Mohit Bansal.

1. **[M-CTC-T](https://huggingface.co/docs/transformers/model_doc/mctct)** (from Facebook) released with the paper [Pseudo-Labeling For Massively Multilingual Speech Recognition](https://arxiv.org/abs/2111.00161) by Loren Lugosch, Tatiana Likhomanenko, Gabriel Synnaeve, and Ronan Collobert.

1. **[M2M100](https://huggingface.co/docs/transformers/model_doc/m2m_100)** (from Facebook) released with the paper [Beyond English-Centric Multilingual Machine Translation](https://arxiv.org/abs/2010.11125) by Angela Fan, Shruti Bhosale, Holger Schwenk, Zhiyi Ma, Ahmed El-Kishky, Siddharth Goyal, Mandeep Baines, Onur Celebi, Guillaume Wenzek, Vishrav Chaudhary, Naman Goyal, Tom Birch, Vitaliy Liptchinsky, Sergey Edunov, Edouard Grave, Michael Auli, Armand Joulin.

+1. **[MADLAD-400](https://huggingface.co/docs/transformers/model_doc/madlad-400)** (from Google) released with the paper [MADLAD-400: A Multilingual And Document-Level Large Audited Dataset](https://arxiv.org/abs/2309.04662) by Sneha Kudugunta, Isaac Caswell, Biao Zhang, Xavier Garcia, Christopher A. Choquette-Choo, Katherine Lee, Derrick Xin, Aditya Kusupati, Romi Stella, Ankur Bapna, Orhan Firat.

1. **[MarianMT](https://huggingface.co/docs/transformers/model_doc/marian)** Machine translation models trained using [OPUS](http://opus.nlpl.eu/) data by Jörg Tiedemann. The [Marian Framework](https://marian-nmt.github.io/) is being developed by the Microsoft Translator Team.

1. **[MarkupLM](https://huggingface.co/docs/transformers/model_doc/markuplm)** (from Microsoft Research Asia) released with the paper [MarkupLM: Pre-training of Text and Markup Language for Visually-rich Document Understanding](https://arxiv.org/abs/2110.08518) by Junlong Li, Yiheng Xu, Lei Cui, Furu Wei.

1. **[Mask2Former](https://huggingface.co/docs/transformers/model_doc/mask2former)** (from FAIR and UIUC) released with the paper [Masked-attention Mask Transformer for Universal Image Segmentation](https://arxiv.org/abs/2112.01527) by Bowen Cheng, Ishan Misra, Alexander G. Schwing, Alexander Kirillov, Rohit Girdhar.

@@ -390,6 +392,7 @@ Número actual de puntos de control: ** (from NVIDIA) released with the paper [Megatron-LM: Training Multi-Billion Parameter Language Models Using Model Parallelism](https://arxiv.org/abs/1909.08053) by Mohammad Shoeybi, Mostofa Patwary, Raul Puri, Patrick LeGresley, Jared Casper and Bryan Catanzaro.

1. **[MGP-STR](https://huggingface.co/docs/transformers/model_doc/mgp-str)** (from Alibaba Research) released with the paper [Multi-Granularity Prediction for Scene Text Recognition](https://arxiv.org/abs/2209.03592) by Peng Wang, Cheng Da, and Cong Yao.

1. **[Mistral](https://huggingface.co/docs/transformers/model_doc/mistral)** (from Mistral AI) by The Mistral AI team: Albert Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lélio Renard Lavaud, Lucile Saulnier, Marie-Anne Lachaux, Pierre Stock, Teven Le Scao, Thibaut Lavril, Thomas Wang, Timothée Lacroix, William El Sayed..

+1. **[Mixtral](https://huggingface.co/docs/transformers/main/model_doc/mixtral)** (from Mistral AI) by The [Mistral AI](https://mistral.ai) team: Albert Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lélio Renard Lavaud, Lucile Saulnier, Marie-Anne Lachaux, Pierre Stock, Teven Le Scao, Thibaut Lavril, Thomas Wang, Timothée Lacroix, William El Sayed.

1. **[mLUKE](https://huggingface.co/docs/transformers/model_doc/mluke)** (from Studio Ousia) released with the paper [mLUKE: The Power of Entity Representations in Multilingual Pretrained Language Models](https://arxiv.org/abs/2110.08151) by Ryokan Ri, Ikuya Yamada, and Yoshimasa Tsuruoka.

1. **[MMS](https://huggingface.co/docs/transformers/model_doc/mms)** (from Facebook) released with the paper [Scaling Speech Technology to 1,000+ Languages](https://arxiv.org/abs/2305.13516) by Vineel Pratap, Andros Tjandra, Bowen Shi, Paden Tomasello, Arun Babu, Sayani Kundu, Ali Elkahky, Zhaoheng Ni, Apoorv Vyas, Maryam Fazel-Zarandi, Alexei Baevski, Yossi Adi, Xiaohui Zhang, Wei-Ning Hsu, Alexis Conneau, Michael Auli.

1. **[MobileBERT](https://huggingface.co/docs/transformers/model_doc/mobilebert)** (from CMU/Google Brain) released with the paper [MobileBERT: a Compact Task-Agnostic BERT for Resource-Limited Devices](https://arxiv.org/abs/2004.02984) by Zhiqing Sun, Hongkun Yu, Xiaodan Song, Renjie Liu, Yiming Yang, and Denny Zhou.

@@ -414,6 +417,8 @@ Número actual de puntos de control: ** (from Meta AI) released with the paper [OPT: Open Pre-trained Transformer Language Models](https://arxiv.org/abs/2205.01068) by Susan Zhang, Stephen Roller, Naman Goyal, Mikel Artetxe, Moya Chen, Shuohui Chen et al.

1. **[OWL-ViT](https://huggingface.co/docs/transformers/model_doc/owlvit)** (from Google AI) released with the paper [Simple Open-Vocabulary Object Detection with Vision Transformers](https://arxiv.org/abs/2205.06230) by Matthias Minderer, Alexey Gritsenko, Austin Stone, Maxim Neumann, Dirk Weissenborn, Alexey Dosovitskiy, Aravindh Mahendran, Anurag Arnab, Mostafa Dehghani, Zhuoran Shen, Xiao Wang, Xiaohua Zhai, Thomas Kipf, and Neil Houlsby.

1. **[OWLv2](https://huggingface.co/docs/transformers/model_doc/owlv2)** (from Google AI) released with the paper [Scaling Open-Vocabulary Object Detection](https://arxiv.org/abs/2306.09683) by Matthias Minderer, Alexey Gritsenko, Neil Houlsby.

+1. **[PatchTSMixer](https://huggingface.co/docs/transformers/main/model_doc/patchtsmixer)** (from IBM Research) released with the paper [TSMixer: Lightweight MLP-Mixer Model for Multivariate Time Series Forecasting](https://arxiv.org/pdf/2306.09364.pdf) by Vijay Ekambaram, Arindam Jati, Nam Nguyen, Phanwadee Sinthong, Jayant Kalagnanam.

+1. **[PatchTST](https://huggingface.co/docs/transformers/main/model_doc/patchtst)** (from IBM) released with the paper [A Time Series is Worth 64 Words: Long-term Forecasting with Transformers](https://arxiv.org/pdf/2211.14730.pdf) by Yuqi Nie, Nam H. Nguyen, Phanwadee Sinthong, Jayant Kalagnanam.

1. **[Pegasus](https://huggingface.co/docs/transformers/model_doc/pegasus)** (from Google) released with the paper [PEGASUS: Pre-training with Extracted Gap-sentences for Abstractive Summarization](https://arxiv.org/abs/1912.08777) by Jingqing Zhang, Yao Zhao, Mohammad Saleh and Peter J. Liu.

1. **[PEGASUS-X](https://huggingface.co/docs/transformers/model_doc/pegasus_x)** (from Google) released with the paper [Investigating Efficiently Extending Transformers for Long Input Summarization](https://arxiv.org/abs/2208.04347) by Jason Phang, Yao Zhao, and Peter J. Liu.

1. **[Perceiver IO](https://huggingface.co/docs/transformers/model_doc/perceiver)** (from Deepmind) released with the paper [Perceiver IO: A General Architecture for Structured Inputs & Outputs](https://arxiv.org/abs/2107.14795) by Andrew Jaegle, Sebastian Borgeaud, Jean-Baptiste Alayrac, Carl Doersch, Catalin Ionescu, David Ding, Skanda Koppula, Daniel Zoran, Andrew Brock, Evan Shelhamer, Olivier Hénaff, Matthew M. Botvinick, Andrew Zisserman, Oriol Vinyals, João Carreira.

@@ -439,6 +444,7 @@ Número actual de puntos de control: ** (from ZhuiyiTechnology), released together with the paper [RoFormer: Enhanced Transformer with Rotary Position Embedding](https://arxiv.org/abs/2104.09864) by Jianlin Su and Yu Lu and Shengfeng Pan and Bo Wen and Yunfeng Liu.

1. **[RWKV](https://huggingface.co/docs/transformers/model_doc/rwkv)** (from Bo Peng) released with the paper [this repo](https://github.com/BlinkDL/RWKV-LM) by Bo Peng.

1. **[SeamlessM4T](https://huggingface.co/docs/transformers/model_doc/seamless_m4t)** (from Meta AI) released with the paper [SeamlessM4T — Massively Multilingual & Multimodal Machine Translation](https://dl.fbaipublicfiles.com/seamless/seamless_m4t_paper.pdf) by the Seamless Communication team.

+1. **[SeamlessM4Tv2](https://huggingface.co/docs/transformers/main/model_doc/seamless_m4t_v2)** (from Meta AI) released with the paper [Seamless: Multilingual Expressive and Streaming Speech Translation](https://ai.meta.com/research/publications/seamless-multilingual-expressive-and-streaming-speech-translation/) by the Seamless Communication team.

1. **[SegFormer](https://huggingface.co/docs/transformers/model_doc/segformer)** (from NVIDIA) released with the paper [SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers](https://arxiv.org/abs/2105.15203) by Enze Xie, Wenhai Wang, Zhiding Yu, Anima Anandkumar, Jose M. Alvarez, Ping Luo.

1. **[Segment Anything](https://huggingface.co/docs/transformers/model_doc/sam)** (from Meta AI) released with the paper [Segment Anything](https://arxiv.org/pdf/2304.02643v1.pdf) by Alexander Kirillov, Eric Mintun, Nikhila Ravi, Hanzi Mao, Chloe Rolland, Laura Gustafson, Tete Xiao, Spencer Whitehead, Alex Berg, Wan-Yen Lo, Piotr Dollar, Ross Girshick.

1. **[SEW](https://huggingface.co/docs/transformers/model_doc/sew)** (from ASAPP) released with the paper [Performance-Efficiency Trade-offs in Unsupervised Pre-training for Speech Recognition](https://arxiv.org/abs/2109.06870) by Felix Wu, Kwangyoun Kim, Jing Pan, Kyu Han, Kilian Q. Weinberger, Yoav Artzi.

@@ -464,14 +470,17 @@ Número actual de puntos de control: ** (from Google/CMU) released with the paper [Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context](https://arxiv.org/abs/1901.02860) by Zihang Dai*, Zhilin Yang*, Yiming Yang, Jaime Carbonell, Quoc V. Le, Ruslan Salakhutdinov.

1. **[TrOCR](https://huggingface.co/docs/transformers/model_doc/trocr)** (from Microsoft), released together with the paper [TrOCR: Transformer-based Optical Character Recognition with Pre-trained Models](https://arxiv.org/abs/2109.10282) by Minghao Li, Tengchao Lv, Lei Cui, Yijuan Lu, Dinei Florencio, Cha Zhang, Zhoujun Li, Furu Wei.

1. **[TVLT](https://huggingface.co/docs/transformers/model_doc/tvlt)** (from UNC Chapel Hill) released with the paper [TVLT: Textless Vision-Language Transformer](https://arxiv.org/abs/2209.14156) by Zineng Tang, Jaemin Cho, Yixin Nie, Mohit Bansal.

+1. **[TVP](https://huggingface.co/docs/transformers/model_doc/tvp)** (from Intel) released with the paper [Text-Visual Prompting for Efficient 2D Temporal Video Grounding](https://arxiv.org/abs/2303.04995) by Yimeng Zhang, Xin Chen, Jinghan Jia, Sijia Liu, Ke Ding.

1. **[UL2](https://huggingface.co/docs/transformers/model_doc/ul2)** (from Google Research) released with the paper [Unifying Language Learning Paradigms](https://arxiv.org/abs/2205.05131v1) by Yi Tay, Mostafa Dehghani, Vinh Q. Tran, Xavier Garcia, Dara Bahri, Tal Schuster, Huaixiu Steven Zheng, Neil Houlsby, Donald Metzler

1. **[UMT5](https://huggingface.co/docs/transformers/model_doc/umt5)** (from Google Research) released with the paper [UniMax: Fairer and More Effective Language Sampling for Large-Scale Multilingual Pretraining](https://openreview.net/forum?id=kXwdL1cWOAi) by Hyung Won Chung, Xavier Garcia, Adam Roberts, Yi Tay, Orhan Firat, Sharan Narang, Noah Constant.

1. **[UniSpeech](https://huggingface.co/docs/transformers/model_doc/unispeech)** (from Microsoft Research) released with the paper [UniSpeech: Unified Speech Representation Learning with Labeled and Unlabeled Data](https://arxiv.org/abs/2101.07597) by Chengyi Wang, Yu Wu, Yao Qian, Kenichi Kumatani, Shujie Liu, Furu Wei, Michael Zeng, Xuedong Huang.

1. **[UniSpeechSat](https://huggingface.co/docs/transformers/model_doc/unispeech-sat)** (from Microsoft Research) released with the paper [UNISPEECH-SAT: UNIVERSAL SPEECH REPRESENTATION LEARNING WITH SPEAKER AWARE PRE-TRAINING](https://arxiv.org/abs/2110.05752) by Sanyuan Chen, Yu Wu, Chengyi Wang, Zhengyang Chen, Zhuo Chen, Shujie Liu, Jian Wu, Yao Qian, Furu Wei, Jinyu Li, Xiangzhan Yu.

+1. **[UnivNet](https://huggingface.co/docs/transformers/main/model_doc/univnet)** (from Kakao Corporation) released with the paper [UnivNet: A Neural Vocoder with Multi-Resolution Spectrogram Discriminators for High-Fidelity Waveform Generation](https://arxiv.org/abs/2106.07889) by Won Jang, Dan Lim, Jaesam Yoon, Bongwan Kim, and Juntae Kim.

1. **[UPerNet](https://huggingface.co/docs/transformers/model_doc/upernet)** (from Peking University) released with the paper [Unified Perceptual Parsing for Scene Understanding](https://arxiv.org/abs/1807.10221) by Tete Xiao, Yingcheng Liu, Bolei Zhou, Yuning Jiang, Jian Sun.

1. **[VAN](https://huggingface.co/docs/transformers/model_doc/van)** (from Tsinghua University and Nankai University) released with the paper [Visual Attention Network](https://arxiv.org/abs/2202.09741) by Meng-Hao Guo, Cheng-Ze Lu, Zheng-Ning Liu, Ming-Ming Cheng, Shi-Min Hu.

1. **[VideoMAE](https://huggingface.co/docs/transformers/model_doc/videomae)** (from Multimedia Computing Group, Nanjing University) released with the paper [VideoMAE: Masked Autoencoders are Data-Efficient Learners for Self-Supervised Video Pre-Training](https://arxiv.org/abs/2203.12602) by Zhan Tong, Yibing Song, Jue Wang, Limin Wang.

1. **[ViLT](https://huggingface.co/docs/transformers/model_doc/vilt)** (from NAVER AI Lab/Kakao Enterprise/Kakao Brain) released with the paper [ViLT: Vision-and-Language Transformer Without Convolution or Region Supervision](https://arxiv.org/abs/2102.03334) by Wonjae Kim, Bokyung Son, Ildoo Kim.

+1. **[VipLlava](https://huggingface.co/docs/transformers/main/model_doc/vipllava)** (from University of Wisconsin–Madison) released with the paper [Making Large Multimodal Models Understand Arbitrary Visual Prompts](https://arxiv.org/abs/2312.00784) by Mu Cai, Haotian Liu, Siva Karthik Mustikovela, Gregory P. Meyer, Yuning Chai, Dennis Park, Yong Jae Lee.

1. **[Vision Transformer (ViT)](https://huggingface.co/docs/transformers/model_doc/vit)** (from Google AI) released with the paper [An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale](https://arxiv.org/abs/2010.11929) by Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby.

1. **[VisualBERT](https://huggingface.co/docs/transformers/model_doc/visual_bert)** (from UCLA NLP) released with the paper [VisualBERT: A Simple and Performant Baseline for Vision and Language](https://arxiv.org/pdf/1908.03557) by Liunian Harold Li, Mark Yatskar, Da Yin, Cho-Jui Hsieh, Kai-Wei Chang.

1. **[ViT Hybrid](https://huggingface.co/docs/transformers/model_doc/vit_hybrid)** (from Google AI) released with the paper [An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale](https://arxiv.org/abs/2010.11929) by Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby.

diff --git a/README_hd.md b/README_hd.md

index 01937532f967c4..c19b944c609189 100644

--- a/README_hd.md

+++ b/README_hd.md

@@ -346,12 +346,14 @@ conda install -c huggingface transformers

1. **[LiLT](https://huggingface.co/docs/transformers/model_doc/lilt)** (दक्षिण चीन प्रौद्योगिकी विश्वविद्यालय से) साथ में कागज [LiLT: एक सरल लेकिन प्रभावी भाषा-स्वतंत्र लेआउट ट्रांसफार्मर संरचित दस्तावेज़ समझ के लिए](https://arxiv.org/abs/2202.13669) जियापेंग वांग, लियानवेन जिन, काई डिंग द्वारा पोस्ट किया गया।

1. **[LLaMA](https://huggingface.co/docs/transformers/model_doc/llama)** (The FAIR team of Meta AI से) Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, Aurelien Rodriguez, Armand Joulin, Edouard Grave, Guillaume Lample. द्वाराअनुसंधान पत्र [LLaMA: Open and Efficient Foundation Language Models](https://arxiv.org/abs/2302.13971) के साथ जारी किया गया