友链 - Halcyon Zone 在下方留言申请加入我的友链,按如下格式提供信息:

博客名:Fluid 简介:Fluid 主题官方博客 链接:https://hexo.fluid-dev.com 图片:https://hexo.fluid-dev.com/img/favicon-pic.png 博客在允许 JavaScript 运行的环境下浏览效果更佳

+

+

+

+

+ 原理分析:UDP和TCP在NAT环境下的P2P打洞实现

+ /p/bb3a9deb.html

+

+ 在当前互联网的结构模式下,大部分的数据通信和交互都是以C/S结构进行通信,即一个客户端和一个中心服务器,客户端通过将数据交给服务器,再有服务器将数据进行适当的处理后与客户端进行交互。除了C/S,还有一种常见的结构,即P2P通信。在P2P网络下,主要的通信双方为“节点”,节点和节点之间的通信是直达的,不需要中心服务器对信息进行处理。

由于这篇博客本身的目的并不是非要在C/S和P2P中抉择出一个好坏,重点主要放在P2P的技术实现上,就不做优劣对比了。P2P网络本质上是一种去中心化的网络结构,每个节点都直接与其他节点交互,共享节点和节点之间的资源与服务。这种结构相对来说可以更有效的利用资源,提高传输效率和可靠性(打洞成功的情况下)。

但是既然有这么多好处,那么必然也有相对应的挑战:P2P网络最核心的本质还是需要节点和节点能够直接通信。但是在当前国内的网络环境下,大部分的家庭用户并没有一个自己的公网IP。很多时候想实现节点和节点的直接通信,我们都需要想一个办法跨过防火墙,来让两个节点能够“握手”并“通信”,而这个过程便称为“打洞”。

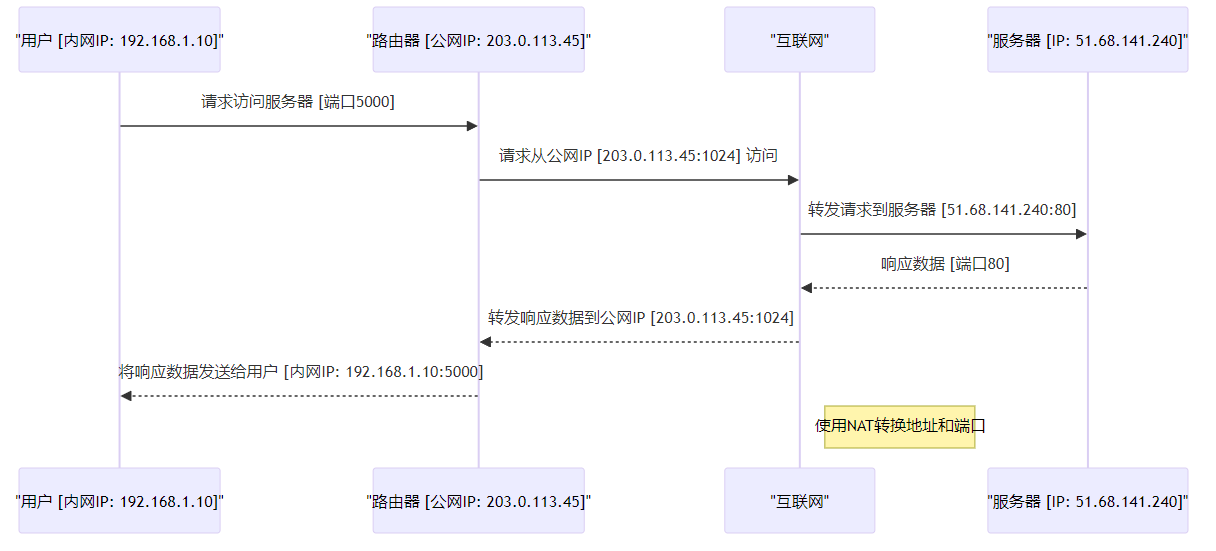

内网请求 :用户设备(内网IP地址为192.168.1.10)通过端口5000发起对外部服务器的请求。地址转换 :路由器接收到来自内网用户的请求后,使用NAT机制将源地址从内网IP转换为路由器的公网IP地址(203.0.113.45),同时,源端口从5000更改为1024。NAT通过这一端口映射的过程,来维护外网和内网设备的通信。请求转发 :经过地址转换后,路由器将修改后的请求通过互联网转发至目标服务器(IP地址为51.68.141.240)的80端口。s服务器响应 :服务器接收到请求后,对该请求进行处理,并通过相同的端口(80)向互联网发送响应数据。响应数据路由 :互联网将服务器的响应数据发回路由器的公网IP地址(203.0.113.45)的1024端口。反向地址转换 :路由器接收到响应数据后,再次使用NAT机制,将响应数据包的目标地址从路由器的“公网IP地址(203.0.113.45):端口(1024)”映射回用户的”内网IP地址(192.168.1.10)和端口5000“。内网传递响应 :最后,路由器将响应数据发送回内网用户,完成整个通信过程。

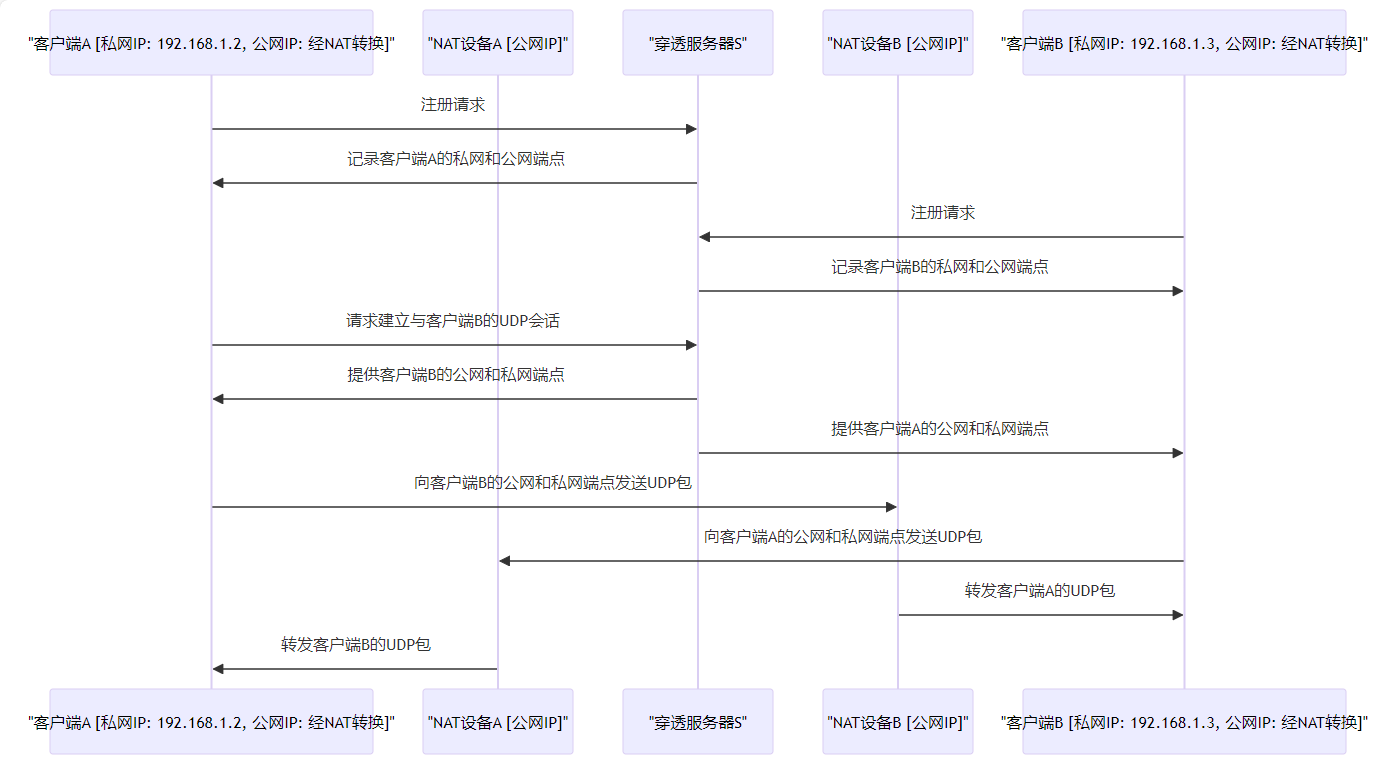

注册与穿透服务器 :两个客户端A和B分别与穿透服务器S建立UDP会话。在此过程中,服务器S记录每个客户端的两个Endpoint:客户端自认为用来与S通信的内网Endpoint对,以及服务器观察到的客户端用来进行通信的公网Endpoint。Endpoint信息的记录与交换Endpoint信息,并从IP和UDP头部提取公网Endpoint信息。如果客户端不在NAT后面,这两个Endpoint应该是相同的。发起UDP打洞请求 :假设客户端A想要直接与客户端B建立UDP会话。A首先不知道如何到达B,因此A请求S帮助建立与B的UDP会话。服务器响应 :S回复A,包含B的公网和内网Endpoint信息。同时,S使用其与B的UDP会话向B发送包含A的公网和内网Endpoint的连接请求消息。收到这些消息后,A和B知道了对方的公网和内网Endpoint。双向打洞 :A收到B的公网和内网Endpoint后,开始向这两个Endpoint发送UDP数据包,并锁定首先从B处获得有效响应的Endpoint。类似地,B在收到转发的连接请求后,开始向A的已知Endpoint发送UDP数据包,锁定第一个有效的Endpoint并以此通讯。由于A和B相互发送数据包的操作本身是异步的,因此A和B发送数据包的前后顺序并没有严格要求。

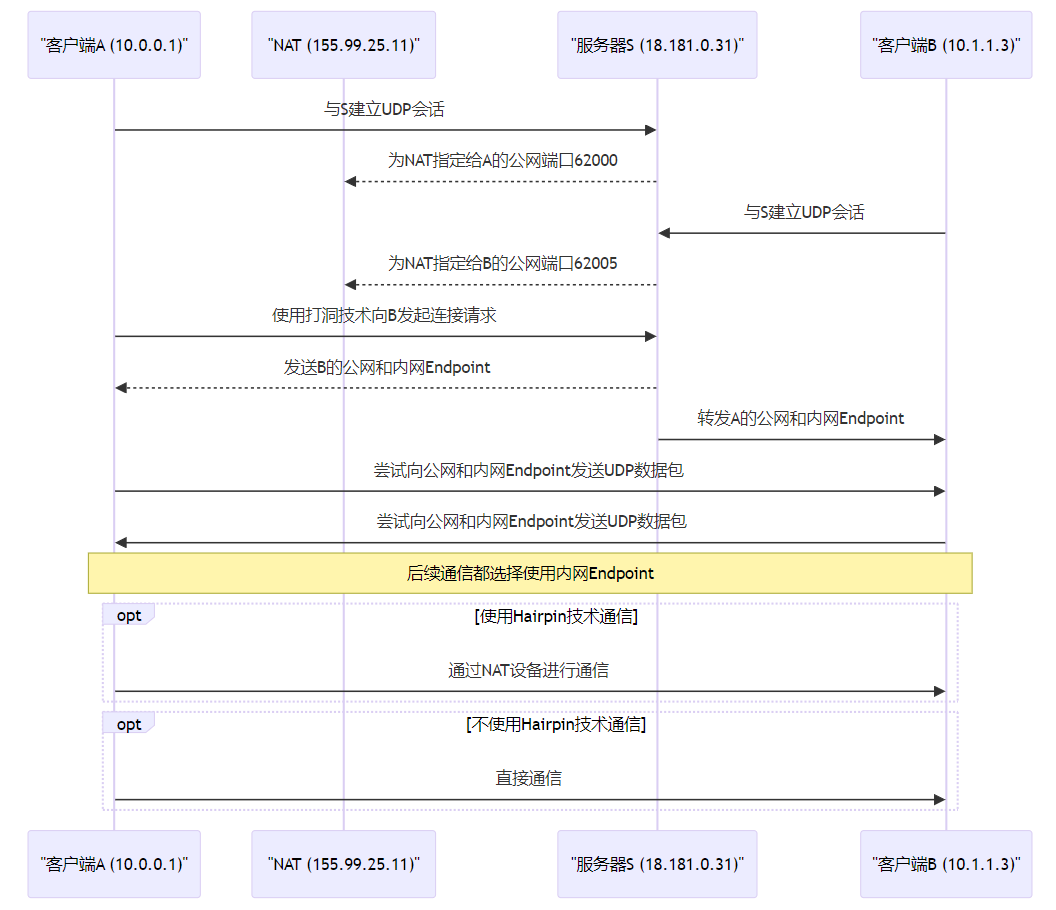

建立会话 :客户端A与服务器S建立UDP会话,NAT分配公网端口62000。端口分配 :客户端B也与服务器S建立UDP会话,NAT为其分配公网端口62005。连接请求 :客户端A请求使用打洞技术与客户端B建立通信,并通过服务器S作为介绍人。交换Endpoint信息 :服务器S向客户端A发送客户端B的公网和内网Endpoint信息,并将客户端A的信息转发给客户端B。尝试直接通信 :客户端A和B尝试向彼此的公网和内网Endpoint发送UDP数据包。选择通信路径 :根据NAT的支持情况,客户端可能通过NAT(支持Hairpin转译)或直接(不支持Hairpin转译)进行通信。Hairpin是NAT中的一种转译技术,其主要实现了让NAT后的两台设备都可以通过公网的IP和端口进行直接通信,具体的效果如下

客户端A发送数据 :假设客户端A想要发送数据到客户端B。首先,客户端A会将数据包发送到NAT设备,目标是客户端B的公网Endpoint(例如155.99.25.11:62005)。NAT设备处理 :NAT设备接收到来自客户端A的数据包,并查看目标地址。这里涉及Hairpin转译,因为数据包的源地址和目标地址都是由NAT设备分配的公网地址。Hairpin转译动作 :如果NAT设备支持Hairpin NAT,它会识别出虽然目标地址是公网地址,但实际上目的地是内网中的另一个客户端。NAT设备将会将数据包的目标地址从B的公网Endpoint转换为B的内网IP地址(10.1.1.3),同时可能还会更改源地址从A的公网Endpoint到A的内网IP地址(10.0.0.1)。数据包转发给客户端B :完成地址转换后,NAT设备将数据包转发到客户端B的内网地址上。此时,数据包好像是从客户端A直接发送给客户端B而不是经过互联网,即使它们实际上是通过NAT设备的公网地址进行通信的。客户端B接收数据 :客户端B收到了来自客户端A的数据包,尽管这些数据包最初是发送到NAT设备的公网地址的。在P2P通信中,由于内网Endpoint比公网的Endpoint要更早到达客户端B,也就是说Hairpin转译的通信流程还没走完,客户端A通过内网Endpoint和B建立的通信就完成了。因此在实际的通信中,由于内网路由通常比经过NAT的路由更快,客户端A和B更倾向于使用内网Endpoint进行后续的常规通信。

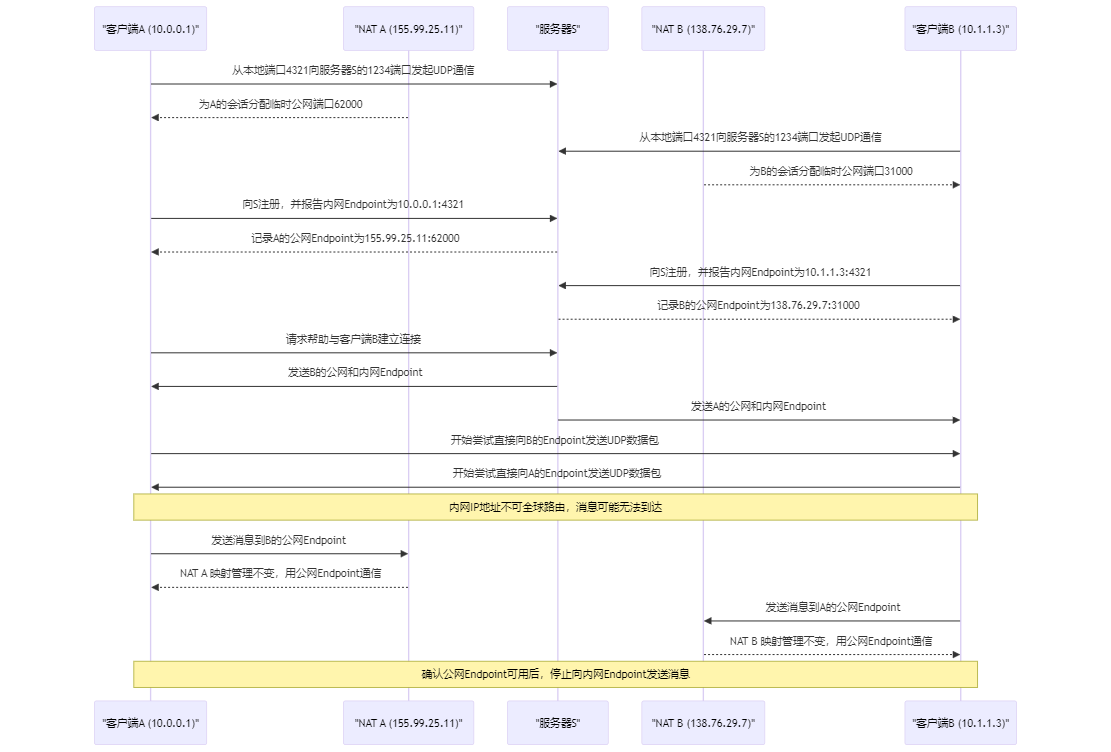

会话初始化 :客户端A和B分别从它们的本地端口4321发起到服务器S的1234端口的UDP通信会话。端口映射 :NAT A为客户端A分配公网端口62000,而NAT B为客户端B分配公网端口31000。注册与记录 :A和B向服务器S注册它们的内网和公网Endpoint。请求协助 :客户端A请求服务器S帮助与客户端B建立连接。Endpoint交换 :服务器S向两个客户端交换彼此的公网和内网Endpoint信息。尝试直连 :A和B尝试直接向彼此的公网和内网Endpoint发送UDP数据包。NAT行为 :如果NAT A和NAT B表现良好,它们将保留公网到内网的映射,为P2P通信“打洞”。通信验证 :一旦客户端验证了公网Endpoint的可用性,且因为在两个不同的NAT后,内网Endpoint不可达,它们将停止向内网Endpoint发送消息,只用公网Endpoint通信。

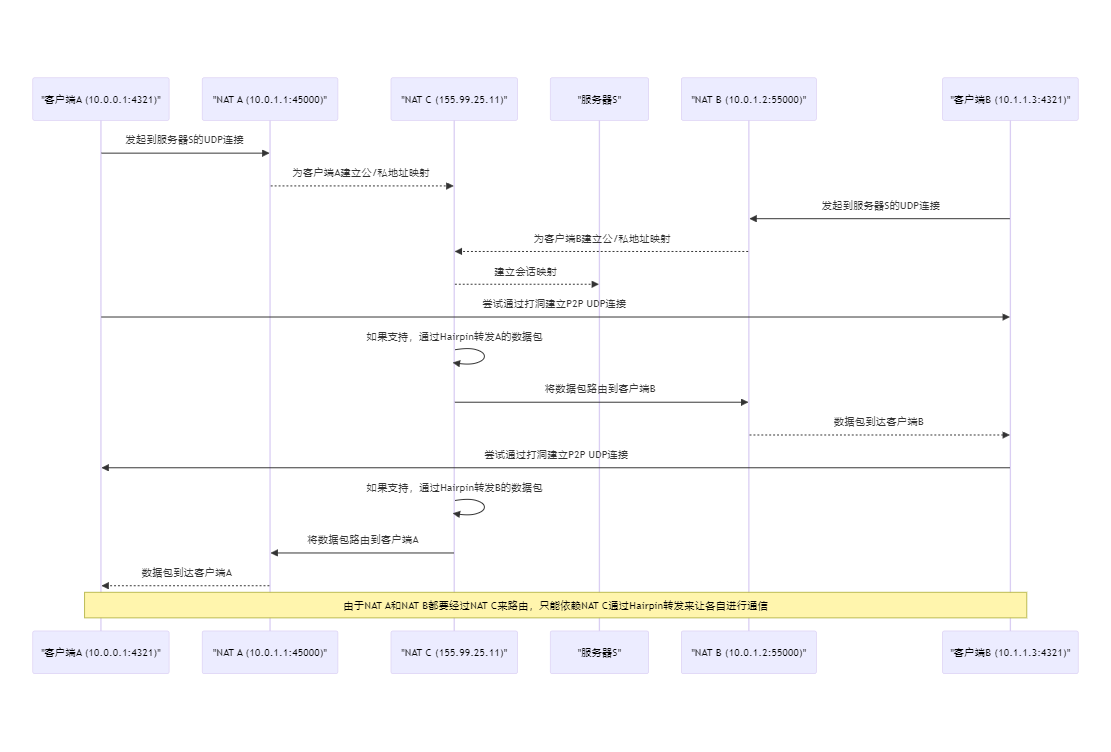

客户端发起连接 - 客户端A和B分别从它们的内网地址发起到服务器S的UDP连接。NAT A和B映射 - NAT A和NAT B各自为客户端A和B创建了公网到内网的地址映射。NAT C建立映射 - 在ISP级别的NAT C为两个会话建立了公网到内网的地址映射。尝试建立P2P连接 - 客户端A和B尝试通过UDP打洞技术建立直接的P2P连接。NAT C的Hairpin转译 - 如果NAT C支持Hairpin转译,它会处理从A到B和从B到A的数据包。数据包路由 - NAT C将数据包正确地路由到另一端的客户端。数据包到达目的地 - 经过NAT的转译,数据包成功到达对方客户端。当NAT不支持Hairpin转发的时候就无能为力了,目前Hairpin的普及度也需要打一个问号。也存在一些特殊的NAT结构,让P2P的成功率更加没有保证。如果希望P2P打洞的成功率变高,则需要整个互联网都推动这一块的发展。

即使在通过上述的几种不同的方法打洞成功,这种方法打出的隧道也并不是可以一直可靠的。大部分的NAT内部都有一个维护UDP转换信息的计时器:如果在一段时间内某个端口上不再有数据通信,那么这个隧道就会因为空闲超时被关闭掉。

如果希望P2P的隧道能不受NAT网关的时间限制,就需要通过发送持续的心跳包来维持这个隧道的活跃状态。

除了心跳包的方法,当然也可以在双方长时间没有数据往来的时候将当前的隧道关闭,并在下一次需要通信的时候建立连接。通过这样的方式避免不必要的流量浪费。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ DNS

+

+

+

+

+

+

+

+

+ 镜像构建:Windows Cloud Image

+ /p/b9295ba3.html

+

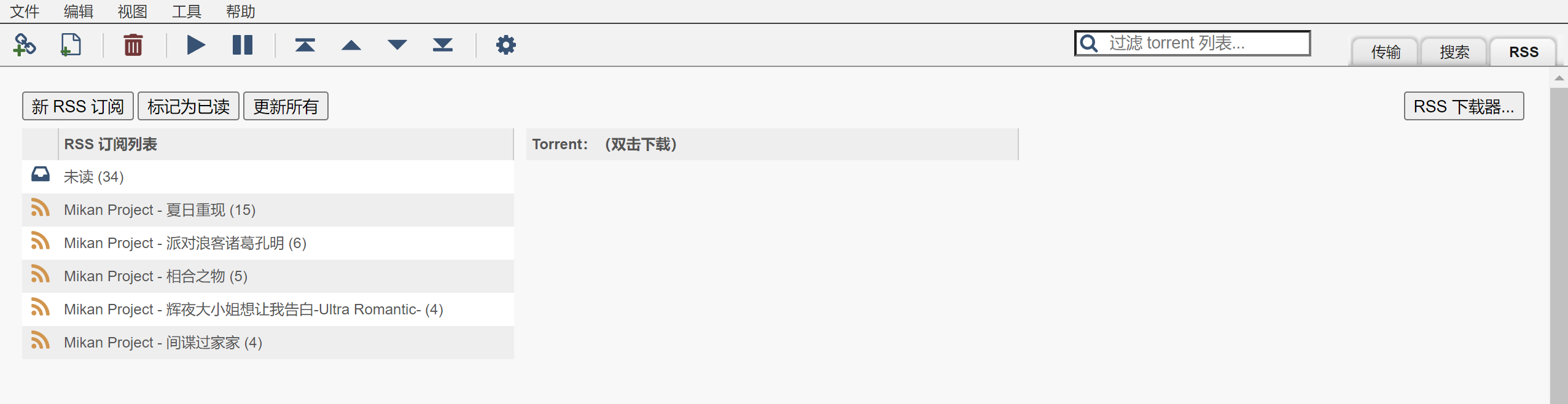

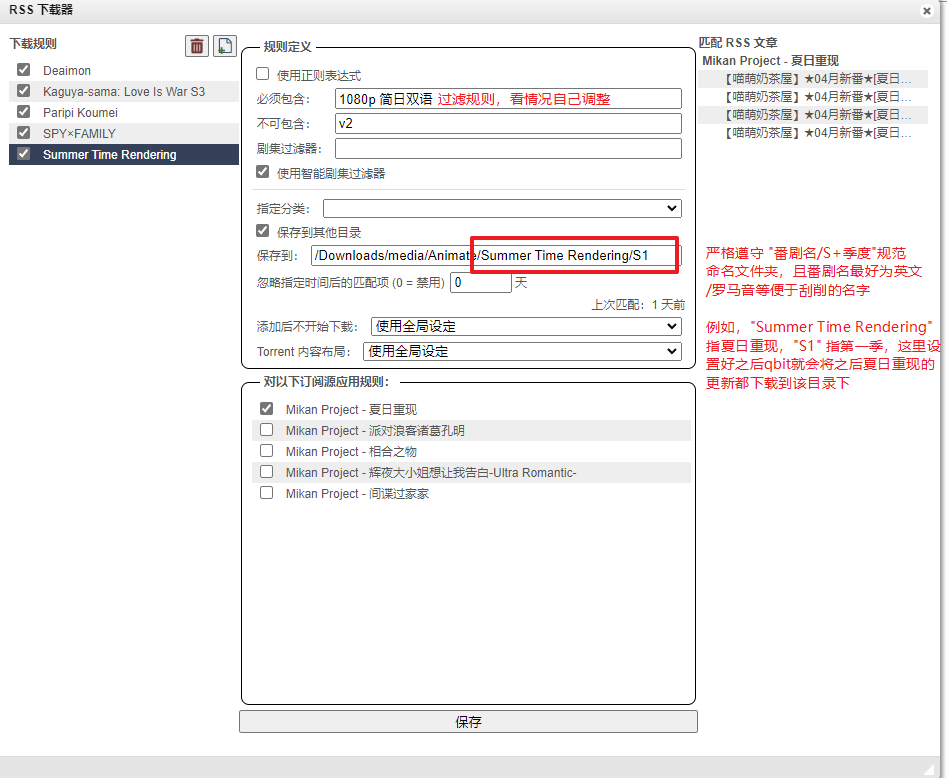

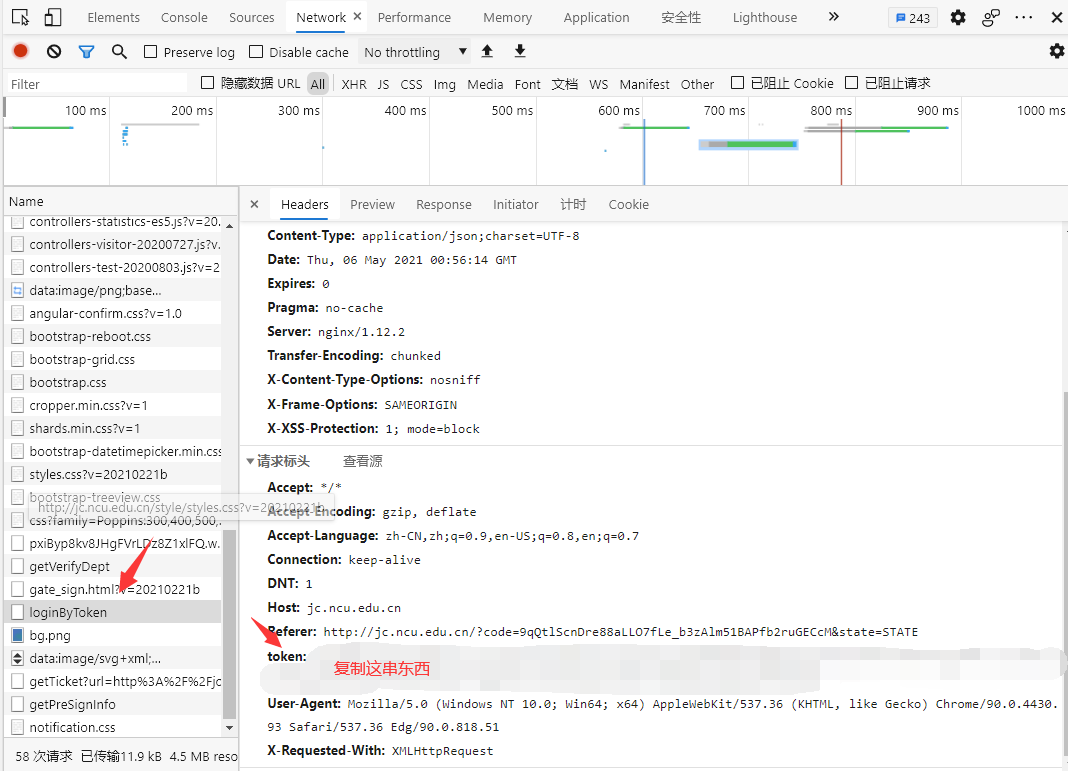

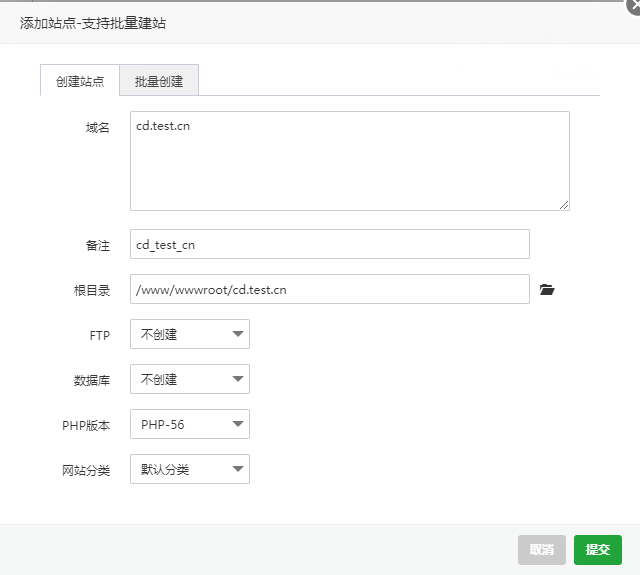

+ Ubuntu和Debian等常见Linux系统都有官方自带cloud-init的cloud image可供下载使用,但是Windows系统在微软中心只找到了ISO镜像的下载路径。当需要在pve等常见虚拟化环境中部署Windows服务器的时候,无论是virtio的驱动,还是iso安装漫长的等待时间都是个问题,所以需要构建cloud image来方便快捷的进行部署

工具使用的是提供给OpenStack的构建工具:

构建出来的镜像可以在各种虚拟化环境中部署和运行。

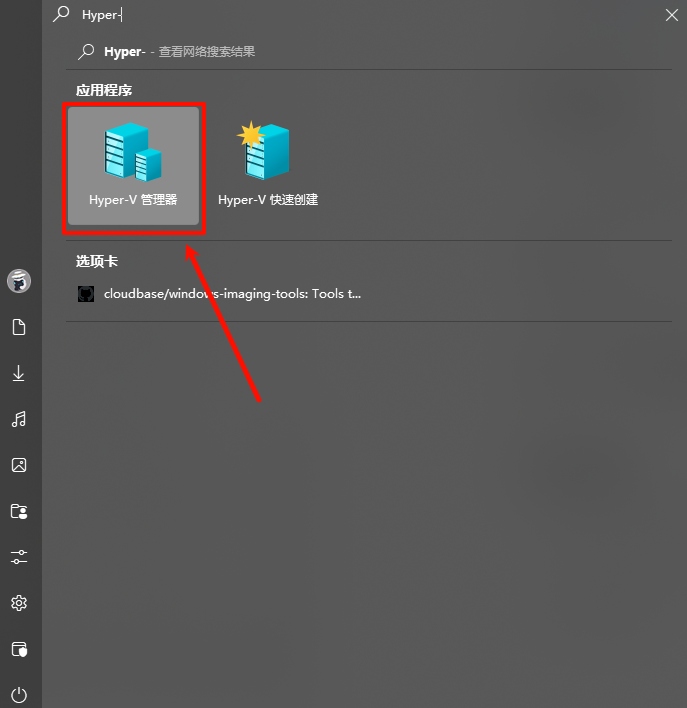

一台开启了Hyper-V的Windows宿主机,用于构建镜像。 一个Windows Server的部署镜像,这里以Windows2022为例。 Windows虚拟机的virtio驱动,可以在这里 下载到最新的iso。镜像的构建本身不会污染宿主机环境,但是需要在宿主机中启用Hyper-V,以便于创建虚拟机。(启用教程网上很多,不做阐述) 启用了Hyper-V以后,为了尽可能构建稳定独立的镜像环境,需要在Hyper-V中创建一个额外的网卡,用于单独构建虚拟机。 通过Windows的搜索功能打开Hyper-V管理器

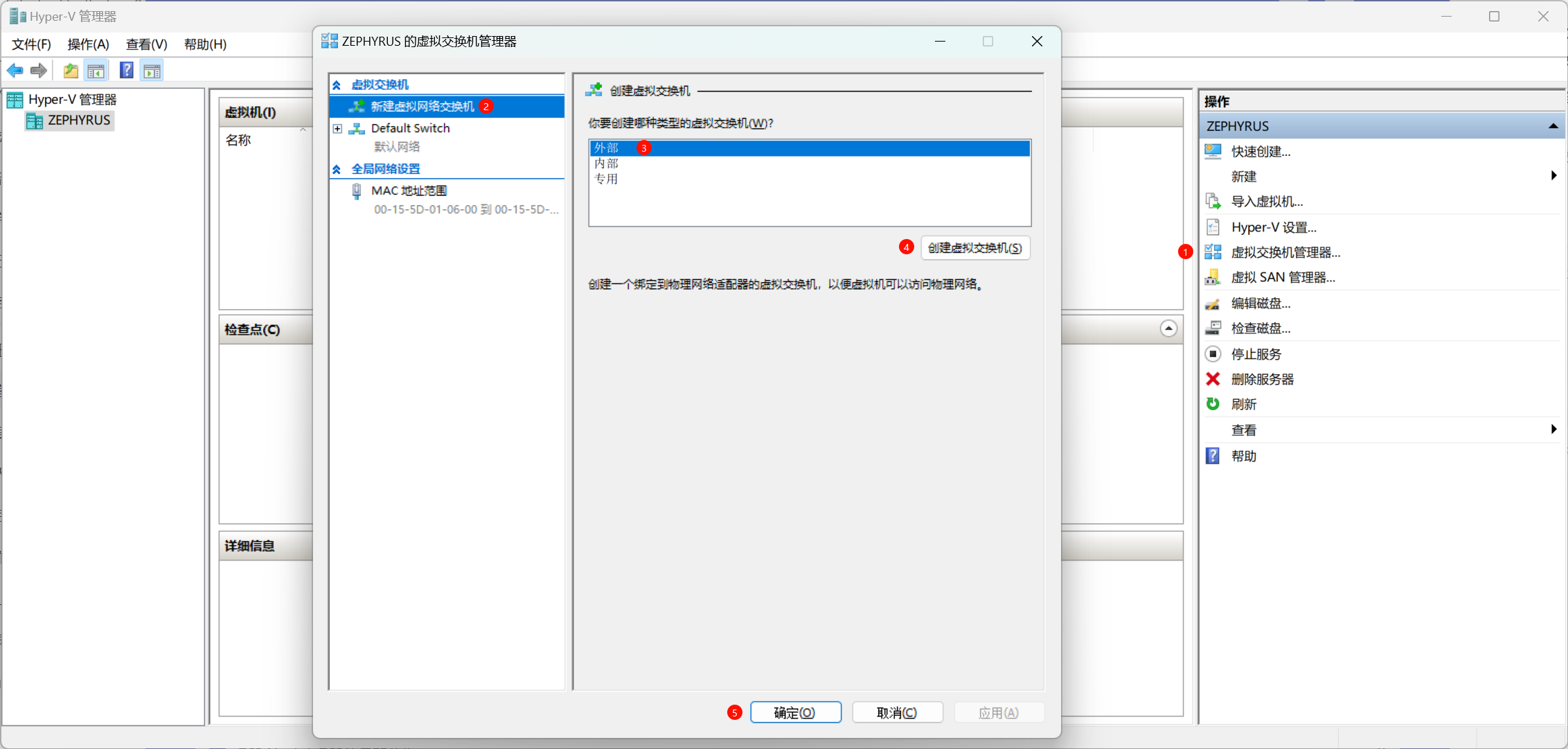

根据下面的流程创建一个虚拟交换机

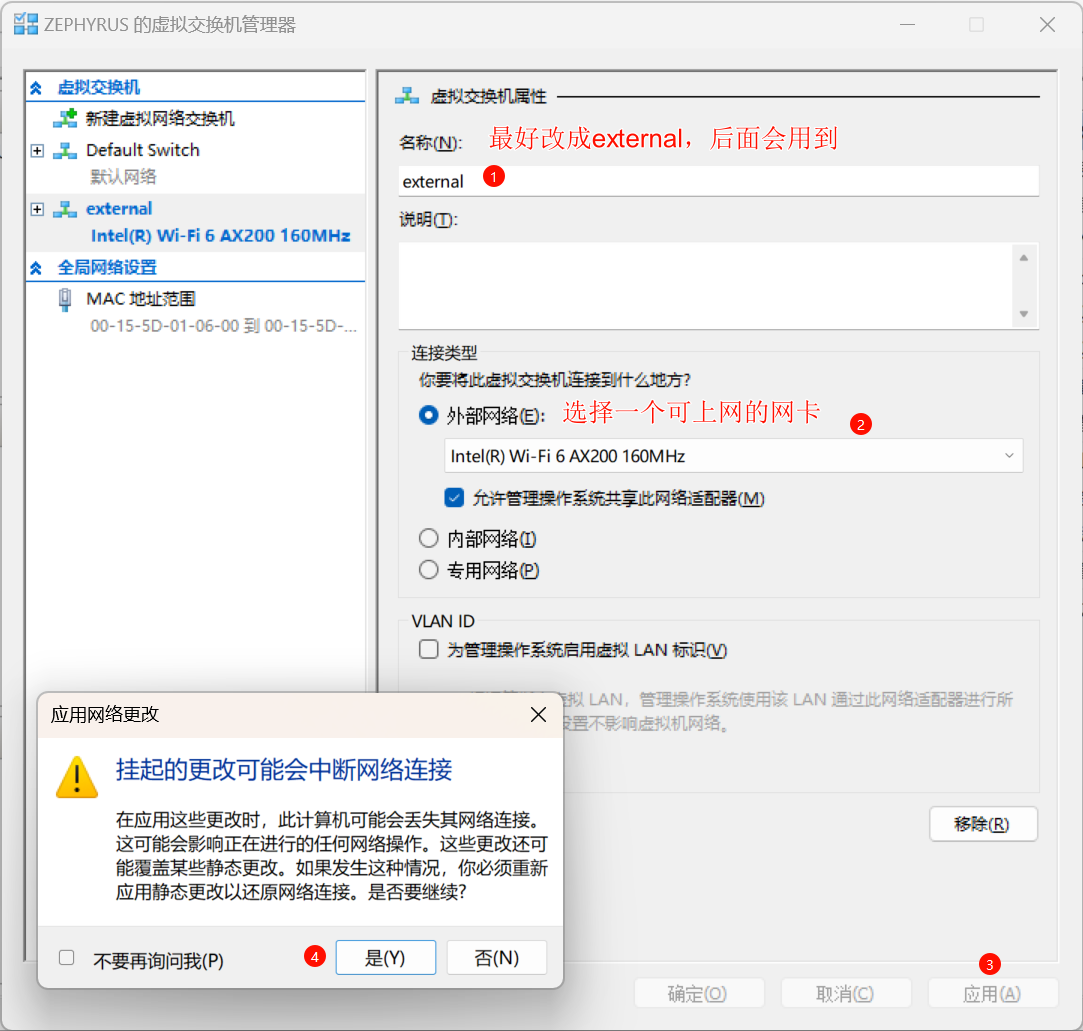

配置虚拟交换机属性

等待应用更改结束后就可以退出Hyper-V管理器了

只要双击打开下载好的Windows2022的iso文件,Windows就会自动对虚拟光驱进行挂载了。这里假设我挂载以后的盘符为D:\

首先在Windows宿主机上克隆构建工具的仓库

1 git clone https://github.com/cloudbase/windows-imaging-tools .git

以管理员权限执行Powershell,并进入刚刚clone的仓库目录下

为当前的Powershell临时加载镜像构建需要的模块

1 2 3 Import-Module .\WinImageBuilder.psm1Import-Module .\Config.psm1Import-Module .\UnattendResources\ini.psm1

指定配置文件的目录,并初始化对应的文件内容

1 2 $ConfigFilePath = ".\config.ini" New-WindowsImageConfig -ConfigFilePath $ConfigFilePath

(可跳过)快速初始化配置文件

1 2 3 Set-IniFileValue -Path (Resolve-Path $ConfigFilePath ) -Section "DEFAULT" `-Key "wim_file_path" `-Value "D:\Sources\install.wim"

因为有一些具体的参数还需要调整,因此这一步可以在下一步手动修改config的时候进行

手动完善刚刚通过命令行创建的config.ini文件,以下是一些注意事项和自己没搞明白的地方

image_name这个配置项需要对install.wim执行Get-WimFileImagesInfo来获取一个列表,然后选出你需要的那个镜像名字。比如对带有桌面环境的Windows Server 2022标准版而言,就是Windows Server 2022 SERVERSTANDARD[vm]的配置参数是指构建用的虚拟机的参数。在构建完成后这个虚拟机会被销毁,一般不用在意。在构建失败的时候可以通过管理员密码进入虚拟机查看信息[vm]的external_switch中需要填入的就是我们刚刚创建好的Hyper-V虚拟网卡名字,比如按照上图中我们选用的是external,这里直接填入即可。[drivers]的部分需要选择你下载的virtio镜像地址time_zone这块不太清楚格式应该怎么填,无论是Asia/Shanghai还是China Standard Time,在自己构建的时候都失败了。如果出现了同样问题的小伙伴建议就默认留空试试其他具体是用qcow2还是vhdx就按需填写即可

执行构建命令,等待镜像构建成功即可

1 New-WindowsOnlineImage -ConfigFilePath $ConfigFilePath

镜像构建的过程中,会有一段时间Powershell一直输出查询日志,这个时候可以去Hyper-V管理器那边查看创建好的虚拟机中的构建状态,如果出现了报错的话直接将虚拟机删除,重新调整配置文件再构建即可。

理论上来说整个构建流程都可以无人值守完成,构建成功了一次以后配置文件和路径在确定的情况下可以保留用于下一次的构建

构建成功后,生成的对应镜像会存放于config.ini中的image_path配置目录下。

整个构建流程对Windows宿主机一般而言不会有环境污染的问题。在构建完成以后,只需要删掉创建的Hyper-V虚拟交换机就可以恢复初始环境。如果在构建用虚拟机构建过程中出现问题,只需要删掉对应的虚拟机和虚拟机对应的磁盘文件即可。

如果是在加载驱动的过程中手动中止了构建,也只需要将挂载的虚拟目录弹出或删除,然后从头开始整个流程即可。

如果构建成功的话,虚拟机会自动关机并重启,这段时间可能会存在一段时间黑屏情况,不用太在意,等待一段时间以后Powershell会接收到虚拟机的配置信息,从而开始镜像的打包流程。

+

+ 小技巧

+

+

+

+

+

+

+ Windows

+

+ Cloud

+

+

+

+

+

+

+

+

+ 性能测试:跨墙的内网穿透工具选择

+ /p/59e029c8.html

+

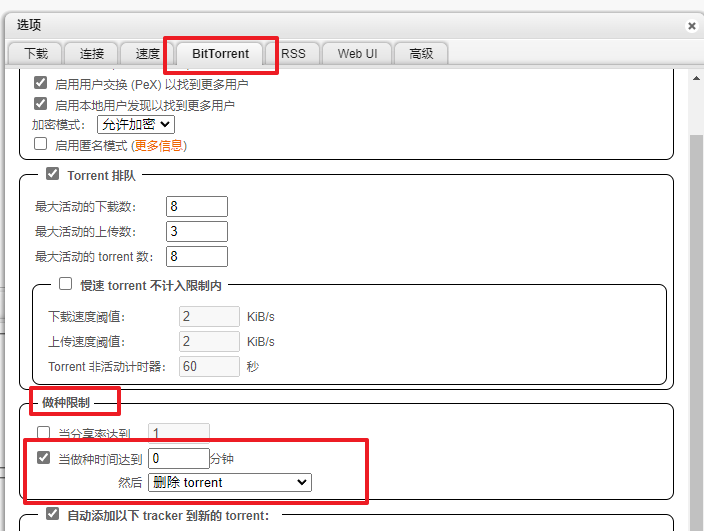

+ 由于需要将家里HomeLab的服务内网穿透到外网服务器上,如果使用Zerotier一类的服务进行穿透的话,在经过GFW以后速度会暴跌。因此需要使用带加密的服务来进行建立连接。

在大约一年前的时候使用了Frp作为跨墙的内网穿透工具,但是因为不知名的原因,当时Frps和Frpc的连接总是容易断开,当时也没有做具体的原因分析。这段时间在新购买了海外VPS之后决定花一些时间对不同的内网穿透工具在跨越GFW的情况下的性能和丢包做一个对比

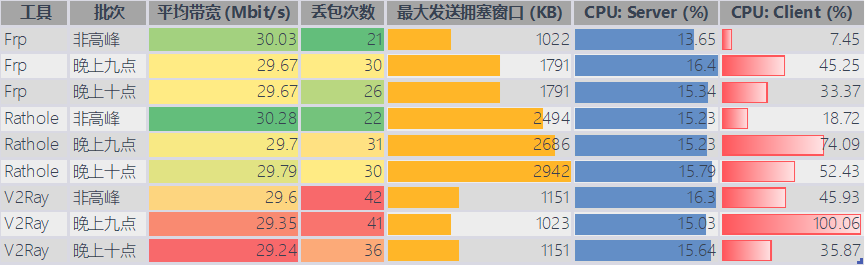

综合性能、带宽和丢包率来看,最新版本的Frp已经是不错的选择。不过目前还不确定在特殊时期Frp能否经历防火墙的考验,而V2Ray虽然在Benchmark的结果上不如人意,但是在跨墙可用性来说是身经百战的。Rathole在个人当前的应用场景下则没有太大的优势。

内网虚拟机一台,配置为2C4G,后文简称client。该机器位于家庭宽带环境中,没有公网IP。 外网机器一台,配置为1C1G,后文简称server。使用的是洛杉矶的机器,国内线路有做优化。 V2RAY:使用ws+tls协议,其中tls部分由nginx进行处理。版本为:5.4.1 FRP:服务端除了auth.token不添加任何多余的参数,性能方面均以默认配置文件为主。版本为:0.53.2 Rathole:同样以默认配置文件为主,最新的源码65b27f076c编译而来的二进制文件。版本为:0.5.0 其中V2RAY与FRP均使用Docker的方式进行部署,Rathole通过screen直接运行在后台。

该测试环境存在诸多不合理的地方,该测试主要为自己的特定使用场景做参考。如果有问题还请斧正

通过三套不同的工具,分别将client上的5201端口转发到server的5201(v2ray),15201(frp)和25201(rathole)上。

在server端输入以下指令,以Json文件获取120s内tcp连接的带宽和稳定性

1 iperf3 -J --logfile ./xxx_result.log -c localhost -p xxx -t 120s

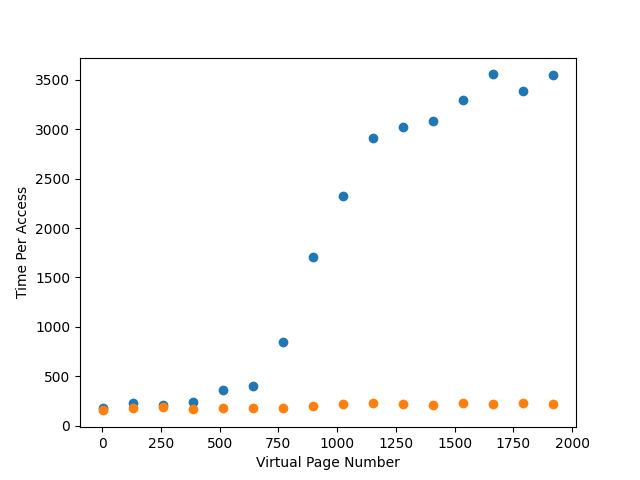

将测试结果统计后以可视化的形式进行对比

V2Ray:部署复杂度较高,配置文件可读性较差。对于ws+tls来说,不但要部署v2ray本身,在服务端还需要额外的域名和Nginx进行转发。同时如果我有多个client的时候,会出现不确定到底是代理到哪个机器的问题,在不进行额外配置的情况下容易出现502报错。 FRP;部署难度极低,配置文件可读性极好,上手难度极低。 Rathole:部署难度中等,每次添加端口需要同时修改服务端和客户端的配置文件,后续维护是最麻烦的。 在通过上述测试流程后,对日志进行分析统计,可以得到以下统计图表:

带宽:Frp和Rathole没有明显差距,V2Ray的带宽相对来说较低,但是没有拉开明显差距 丢包率:Frp相比Rathole略有优势,在晚高峰的时候依旧能保证丢包率控制在30以下。V2Ray相比之下则更容易丢包 由于网站只有小范围用户使用,因此对拥塞控制并没有很高的需求。不过从这份Benchmark中也可以看出,在高并发场景下,Rathole可能会更有优势 资源占用:V2Ray由于加密解密的严谨性,资源消耗相比Rathole与Frp都要多。在资源占用这一点上,Frp几乎是毫无悬念的领先 综上,从配置难度以及性能对比的角度来看,暂时使用Frp会是一个不错的选择。如果后续出现了性能的不稳定性也会在这里进行补充说明。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ Frp

+

+ Rathole

+

+ V2Ray

+

+ 内网穿透

+

+

+

+

+

+

+

+

+ 获取Cloudflare Tunnel下用户真实IP

+ /p/f09b73d7.html

+

+ 部署在内网中,在80端口部署了PHP的服务器一台。 使用了Cloudflare Tunnel对内网http://127.0.0.1进行了转发,并提供https支持 SSPanel需要拥有https的情况下才可以正常使用,但是使用Cloudflare Tunnel默认的设置的情况下,所有的用户登入请求都会被记录为Tunnel的转发地址(在这种情况下即127.0.0.1)。

在这种情况下,当用户通过Tunnel访问我的网站时,Cloudflare会通过CF-Connecting-IP这个HTTP请求头传递原始访问者的IP地址。因此也就可以通过修改Nginx配置的方法来获取到对应用户的真实IP地址了。

先在这里贴上修改了的配置文件和注释

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 server {listen 80 ;listen [::]:80 ;root /path/to/site/public;index index.php;server_name your.domain.com;set_real_ip_from 127.0.0.1 /32 ; real_ip_header CF-Connecting-IP;location / {try_files $uri /index.php$is_args $args ;location ~ \.php$ {try_files $fastcgi_script_name =404 ;include fastcgi_params;fastcgi_index index.php;fastcgi_buffers 8 16k ;fastcgi_buffer_size 32k ;fastcgi_pass unix:/run/php/php-fpm.sock;fastcgi_param DOCUMENT_ROOT $realpath_root ;fastcgi_param SCRIPT_FILENAME $realpath_root $fastcgi_script_name ;fastcgi_param REMOTE_ADDR $remote_addr ;

对于上面修改的不同配置项的作用如下

set_real_ip_from 127.0.0.1/32;

set_real_ip_from指令用于指定哪些IP地址可以设置真实IP地址。在这种情况下,127.0.0.1/32表示本地地址。这是因为Cloudflare Tunnel将流量转发到您的本地服务器,通常表现为来自127.0.0.1(即本地主机)的请求。 这条指令告诉Nginx,如果请求来自本地主机(127.0.0.1/32),则应该考虑使用另一个HTTP头中的IP地址作为访问者的真实IP地址。 real_ip_header CF-Connecting-IP;

real_ip_header指令用于指定包含真实客户端IP地址的HTTP头。CF-Connecting-IP是由Cloudflare设置的一个特殊的HTTP头,它包含了发起请求的原始访问者的IP地址。通过这个配置,Nginx将使用CF-Connecting-IP头中的值来重写访问者的IP地址,这样PHP应用程序就可以获取到访问者的真实IP,而不是Cloudflare Tunnel的本地地址。 在PHP FastCGI 配置块中添加的指令:

fastcgi_param REMOTE_ADDR $remote_addr;这一行将Nginx内部变量$remote_addr的值传递给FastCGI进程。由于我们已经使用set_real_ip_from和real_ip_header配置了Nginx,$remote_addr将包含经过Cloudflare处理的真实客户端IP。 通过将此参数传递给FastCGI(在这种情况下是PHP-FPM),在PHP应用程序中的$_SERVER['REMOTE_ADDR']将包含正确的客户端IP地址。

+

+ 小技巧

+

+

+

+

+

+

+ cloudflare

+

+

+

+

+

+

+

+

+ 虚拟化:初识IOMMU(TODO)

+ /p/4416e368.html

+

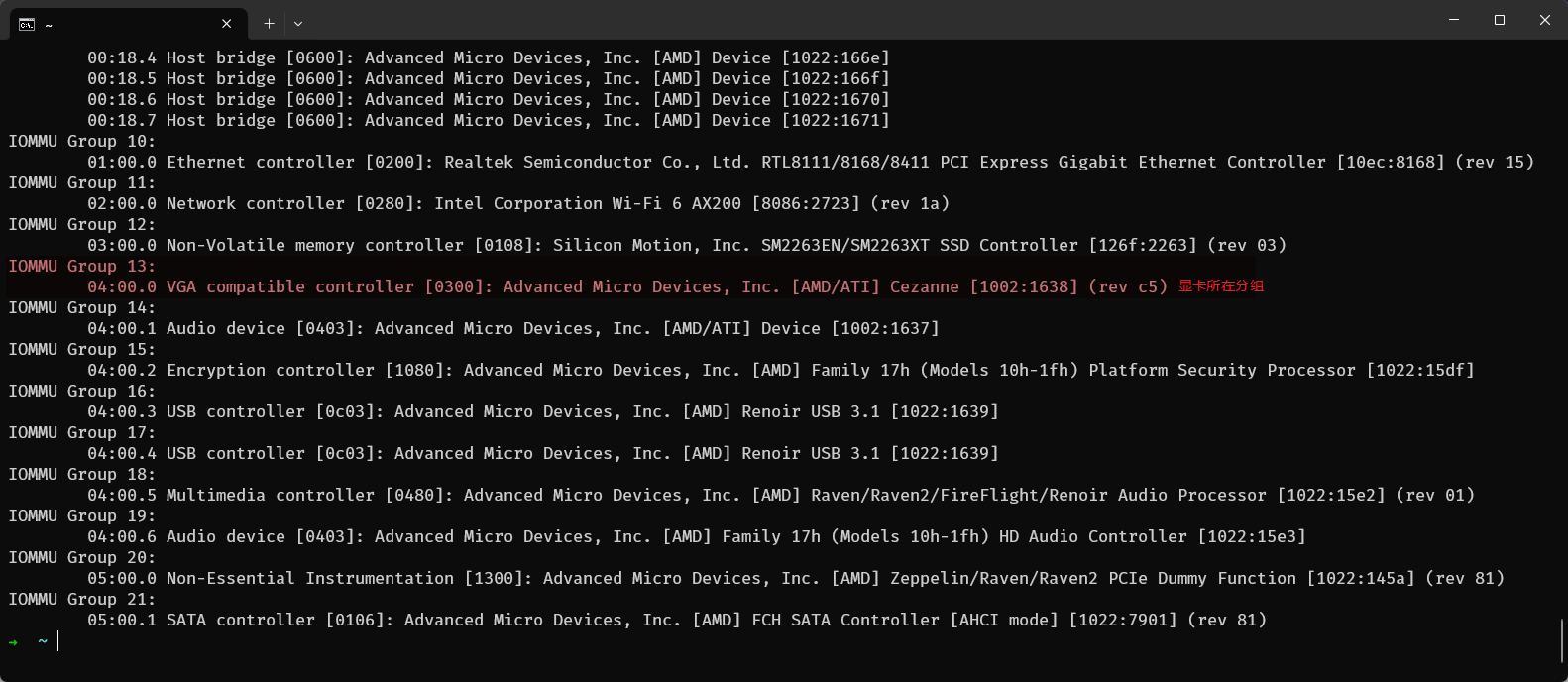

+ 最近在尝试给朋友的小主机安装ZStack作为虚拟化管理平台的时候,遇到了一个需求:通过HDMI直接将Windows虚拟机的画面输出到外界显示器。需要解决这个问题自然而然的就需要使用直通的方法将显卡直通给虚拟机。不过之前直通都是直接找别人的博客一步一步傻瓜式执行下去,对于每个指令发生了什么,以及iommu是如何工作的都不清楚。刚好趁着这个机会了解并记录下自己的学习历程

我自己现在有一台基于Proxmox VE的All in one小主机了,这里就叫做主机A,而我朋友的主机则称为主机B。在安装ZStack之前,我原以为直通的过程依旧可以无脑用脚本来实现,但是实际执行过程中却发现在PVE中应该成功的ACS的改动在ZStack中却并没有成功。这便引起我了从ACS到IOMMU作用的好奇。

首先,在主机A和主机B的BIOS上都启用IOMMU的功能,可以发现原本的iommu分组都十分混乱,大部分设备杂糅在一起。为了解决这个问题,便有了叫做ACS的技术。

ACS的主要功能

设备隔离 :ACS允许对PCIe设备进行更细粒度的控制,增强了设备间的隔离。这在虚拟化环境中尤为重要,因为它可以帮助确保虚拟机之间的安全隔离,防止一个虚拟机访问另一个虚拟机的PCIe设备。控制I/O访问 :ACS可以控制PCIe设备的I/O访问,例如控制哪些设备可以发起对其他设备或内存的直接内存访问(DMA)。提高安全性 :通过对设备间访问的更严格控制,ACS有助于提高系统的整体安全性,尤其是在多租户或需要高安全性的环境中。通过启用iommu的同时启用acs,就可以将系统中iommu的group分成更细的设备单位,具体修改的操作实现参数可能不尽相同,但是基本上都是先对/etc/default/grub中的GRUB_CMDLINE_LINUX进行修改,添加amd_iommu=on和pcie_acs_override=downstream,multifunction即可

对于分组情况的查看,在PCI passthrough via OVMF - ArchWiki (archlinux.org) 可以找到一个脚本来列出当前的IOMMU Groups的情况

1 2 3 4 5 6 7 8 # !/bin/bash

当我在自己的PVE主机上执行这个脚本之后,可以发现显卡是单独在一个Groups中的

但是在ZStack平台上执行以后可以发现核显并不是单独在一个Groups里面的

当时的log没有保存,这里假象一个其他的例子代替,是一个GTX 970显卡的例子,一般来说独显是会有单独的Groups的

1 2 3 4 5 6 7 ......

具体问题的产生原因还不清楚(找到问题以后会来更新博客),不过就IOMMU的分组情况大概是这样。

对于什么是iommu,找到这样一个简单扼要的概括

大家知道,I/O设备可以直接存取内存,称为DMA(Direct Memory Access);DMA要存取的内存地址称为DMA地址(也可称为BUS address)。在DMA技术刚出现的时候,DMA地址都是物理内存地址,简单直接,但缺点是不灵活,比如要求物理内存必须是连续的一整块而且不能是高位地址等等,也不能充分满足虚拟机的需要。后来dmar就出现了。 dmar意为DMA remapping,是Intel为支持虚拟机而设计的I/O虚拟化技术,I/O设备访问的DMA地址不再是物理内存地址,而要通过DMA remapping硬件进行转译,DMA remapping硬件会把DMA地址翻译成物理内存地址,并检查访问权限等等。负责DMA remapping操作的硬件称为IOMMU。做个类比:大家都知道MMU是支持内存地址虚拟化的硬件,MMU是为CPU服务的;而IOMMU是为I/O设备服务的,是将DMA地址进行虚拟化的硬件。

而在这其中,IOMMU分组则是实现设备直通的关键,每个分组都包含了可以共享一同一个虚拟内存映射的设备集合。如果一个设备独占一个IOMMU分组,直通它是很简单的。但是如果多个设备共享同一个分组,比如显卡和USB接口,那么就无法只直通其中一个设备。

后续就是找时间尝试研究为什么ACS在ZStack中没有正常被启用,并将结论补充到这篇博客当中。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ iommu

+

+

+

+

+

+

+

+

+ 知识复盘:操作系统的作用

+ /p/e429c37a.html

+

+ 该部分博客为自己在学习《程序员的自我修养:链接、装载与库》的时候对于过去零碎知识点的一个整理和复盘,并非照搬原文,其中会加入一些自己的联想与理解,如有错误还请指出。

操作系统在计算机中主要有两个功能:

在计算机的使用过程中,需要消耗时间的任务部分大致可以分为两种情况:

消耗CPU算力的计算密集型操作 需要等待设备响应处理的I/O密集型操作 我们知道在计算机中有南桥和北桥两个概念,北桥连同了CPU等高速芯片,而南桥则负责了磁盘、鼠标、键盘等低速设备。因此我们可以抽象出一个结论:计算密集型操作 和 I/O密集型操作 是由不同的设备分别处理的。接下来对于操作系统调度分析则会都以这一前提条件进行分析。

假设我们现在需要完成一个很复杂的数学问题,且假设完成这个数学问题分为两个步骤:

在草稿纸上"随意"的打草稿并推演计算过程,最终计算出答案(计算密集型操作) 将整个推演过程有条理并工整的誊抄在答卷上,便于他人阅读自己的答案(I/O密集型操作) 那么如果我们有很多个这样的题目需要完成。那么最高效的方法自然是分配两个同学A和B。假设同学A的计算能力很强,同学B的书写则十分端正,同时可以看懂同学A的草稿,那么我们便可以让同学A只需要负责计算和打草稿,只要做完了第一题就直接开始写第二题,而同学B则在同学A开始计算第二题的过程中开始誊抄第一题的答案。这样便可以让同学A和同学B的时间都统筹利用起来,以此提升效率。

在计算机中也是同样的道理。在计算机刚刚发展的时候,每次执行一个任务都需要先让CPU计算完后,CPU还要等待诸如打印机等设备输出了结果以后,再进行下一个问题的计算。

为了解决这个问题,人们便想到使用一个监控程序来监管CPU的运算,当监控程序发现在CPU进行完毕某一次运算以后,如果后续还有其他问题需要使用CPU进行计算的话,则让CPU直接进行下一个问题的计算,而不是等待第一个问题的I/O操作进行完毕以后再进行第二个问题的计算。这就是多道程序的雏形

但是随着计算机功能的逐步发展,多道程序则体现出了一个弊端:那就是任务的执行需要所有人都依次排队,前面的人如果没有解决他的问题就轮不到下一个人。

假设在银行中有一个人的业务处理需要花费特别特别长的时间,从而导致后面所有人直到银行下班都没完成自己的业务,这无疑是非常令人恼火的一件事情。但是如果这个人将自己的一个任务拆分成多个不同的部分,每完成一个部分就让后面的人先处理下,这样相对而言就能顾及他人的感受,有利于提高处理问题数量的效率。

因此,我们就了分时系统的概念,在分时系统中,程序可以通过在编写的时候主动调用某个“系统调用”来实现通知操作系统我现在这部分的工作已经完成了一部分,如果后面有其他任务需要执行的话可以先执行其他的任务,再来执行我的任务。从而在一定程度上解决了阻塞问题。

但是分时系统在计算机的衍变过程中也展现出了自己的弊端。

依据以下两个分时系统 的特点:

是否让出CPU是由程序自身决定的。程序需要主动调用特定的系统调用来通知操作系统它愿意让出CPU。 这种机制的问题是,如果一个程序不主动让出CPU(例如,由于编程错误或恶意行为),那么操作系统不能强制地从该程序中夺回CPU控制权。因此,其他程序可能会被迫等待,导致整个系统的响应性下降。 假设我们遇到一个程序员在程序中忘记调用分时的“系统调用”,还写了一个死循环的错误代码。那么整个操作系统都将会因为这个问题而出现宕机。

由此我们就需要一个更高端的操作系统来解决我们的问题,即现代操作系统的解决方案:多任务系统。

多任务系统 的基础是建立在此时操作系统对所有硬件资源进行了直接的接管。而所有的应用程序都以进程(Process)的方式运行在操作系统这个大Boss之下。所有进程的调度都需要受到操作系统的管理,并且每个进程和进程之间就像是一个小房间,他们的地址空间也都是相互隔离且独立的。

在这种情况下,CPU就变成了操作系统大Boss来进行管理的一个资源,而不是和之前分时系统一样由应用自己直接对CPU进行管理了。这样的好处是可以让所有程序都听操作系统这个领导的话,而不是和之前一样我想一直占用CPU就一直占用,如果我不调用接口主动释放CPU你们谁都别想用上CPU。

对于操作系统来说,每个进程就是一个任务,每个任务则又有自己的任务优先级。对于优先级高的任务,操作系统会先进行;对优先级低的任务则后执行。如果一个进程的运行时间超过了某个限制,则会将该程序暂停以分配给其他同时间内也许更需要CPU资源的线程任务。

在此基础上还会牵扯到一些诸如多级反馈队列、上下文切换开销等问题。这里就不做过多的展开。

这里放一个之前写OSTEP课后实验相关的博客链接,便于自己查阅

有关于设备驱动的内容直接概述过于枯燥无味,因此下面这段解释为使用 GPT-4 生成的一个概述,觉得生动有趣就搬上来了

想象一下,你正在玩一个超级复杂的电子游戏,但你只需要按下一个按钮,就能完成一个复杂的动作,比如打怪兽或跳跃。这个按钮就像是操作系统,而那些复杂的动作就是硬件的操作。你不需要知道每一个细节,只需要按下按钮,游戏就会为你完成所有的事情。

操作系统就是这样的“神奇按钮”。它位于硬件之上,为上层的应用程序提供了一个统一的方式来访问硬件。想象一下,如果每次你想在屏幕上画一条线,都需要知道你的电脑使用的是什么显卡、屏幕的大小和分辨率,然后写一大堆复杂的代码。这听起来很麻烦,对吧?但是,有了操作系统,你只需要调用一个简单的函数,比如LineTo(),然后操作系统会为你处理所有的细节。

在操作系统的早期,程序员确实需要直接与硬件交互,这是一件非常繁琐和复杂的事情。但随着时间的发展,操作系统逐渐成熟,它开始为程序员提供了一系列的“抽象”概念,使得程序员可以更加轻松地开发应用程序,而不需要关心硬件的细节。比如,在UNIX系统中,访问硬件设备就像访问普通文件一样简单;在Windows系统中,图形和声音设备被抽象成了特定的对象。

但是,谁来处理这些复杂的硬件操作呢?答案是:硬件驱动程序 。它们是操作系统的一部分 ,专门负责与特定的硬件设备交互。这些驱动程序通常由硬件制造商开发,而操作系统提供了一系列的接口和框架,使得这些驱动程序可以在操作系统上运行。

最后,让我们以读取文件为例。当你想读取一个文件时,你不需要知道这个文件在硬盘上的具体位置。你只需要告诉操作系统你想读取的文件名,然后操作系统会找到这个文件在硬盘上的位置,读取它,并将数据返回给你。这一切都是由文件系统和硬盘驱动程序共同完成的。

总之,操作系统就像是一个超级英雄,它为我们处理了所有复杂的硬件操作,使得我们可以更加轻松地开发和使用计算机程序。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ OS

+

+

+

+

+

+

+

+

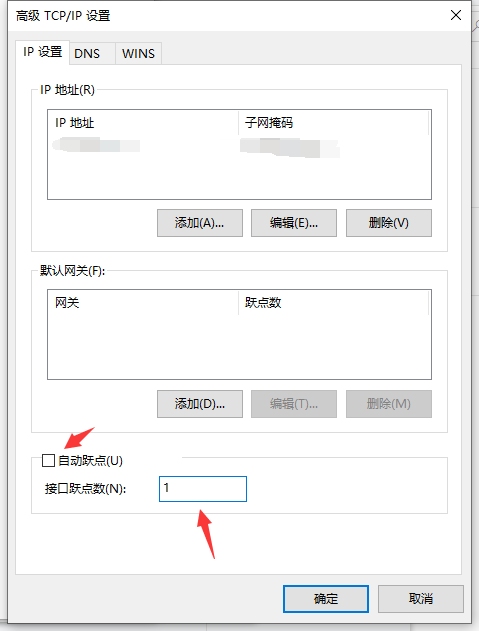

+ DNS问题排查思路

+ /p/23c3db21.html

+

+ 这篇博客主要是在推特中无意翻到了这篇博客,尝试以翻译的形式做一套笔记,分享的同时加强自己的记忆。

当我们发起一个DNS请求的时候,基本上发生的就是下面两件事

电脑向一个被标记为resolver的服务器发送一个DNS请求。 resolver服务器首先会检查缓存,并且在必要的时候再向authoritative nameservers发送查询请求。但是在这两件事情背后,我们有几个问题需要思考

解析服务器(即上面提到的resolver)的缓存中存放了一些什么东西?

在计算机中,在发起一个DNS请求的时候调用的是哪一部分的库?

举个例子,一个请求有可能是由libc中提供的getaddrinfo发起的,这部分代码或是来自glibc,或是musl,又或者是apple提供的库文件;这个请求也有可能是在浏览器中发起,由浏览器进行处理;当然也有可能是某些特定的自定义实现。

在不同的阶段和方法进行DNS请求做的事情都会略有不同,他们或多或少会有不一样的配置、缓存以及功能。举个例子来说,直到今年(2023)musl的DNS才开始支持TCP询问

解析器和权威域名服务器(即上文中提到的authoritative nameservers)之间是如何进行通话的?

在这里我们如果能知道在DNS请求期间询问了哪些下游的权威域名服务器,以及他们提供了哪些信息,则很多东西都会非常好理解。

为了让我们可以在获取DNS请求的时候,获取到更多的调试信息,我们可以尝试用dig工具来获取一些信息。一个例子如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 $ dig @223.5.5.5 whatdontexist.lol ] 8:26 PM

在上面这个示例中,我通过向一个不存在的域名:whatdontexist.lol发起了一个DNS请求。我们可以在这里看到许多有意思的信息,比如我们是对223.5.5.5这个DNS服务器,通过UDP发起的请求等等。

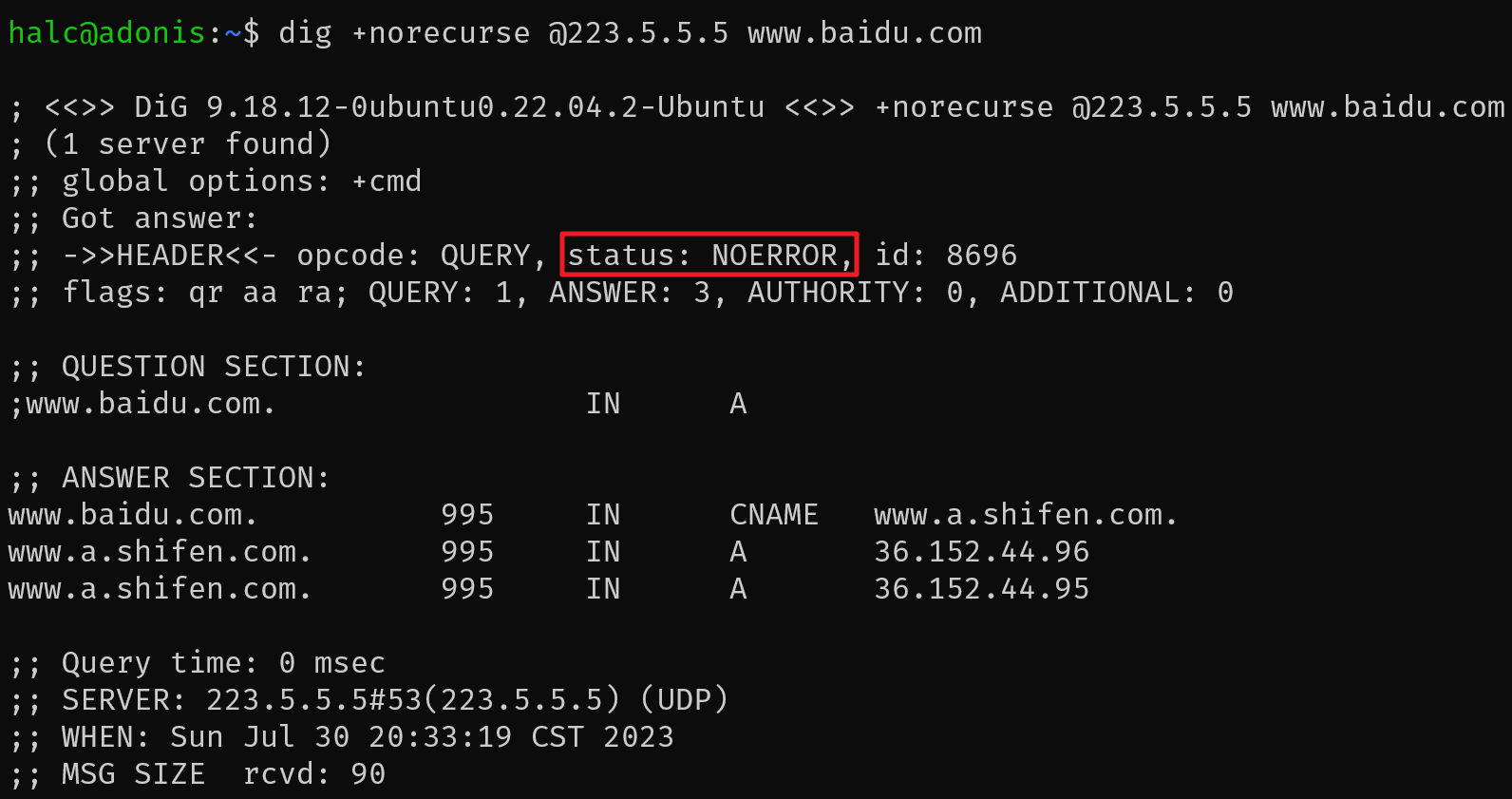

通过使用dig,我们可以知道很多额外的信息。举个例子,我们可以使用dig +norecurse指令来弄清楚DNS解析服务器目前有没有针对某个特定记录的缓存。对于某个特定的记录,如果不存在缓存,则会返回一个SERVFAIL的状态

举个例子,我们首先可以向223.5.5.5这个阿里的DNS请求www.baidu.com的DNS条目(大概率来说应该是缓存了百度的域名解析的)

我们可以看到上图中获取到的status为NOERROR,也就意味着百度在阿里云的DNS服务器中可以正常返回需要的结果。

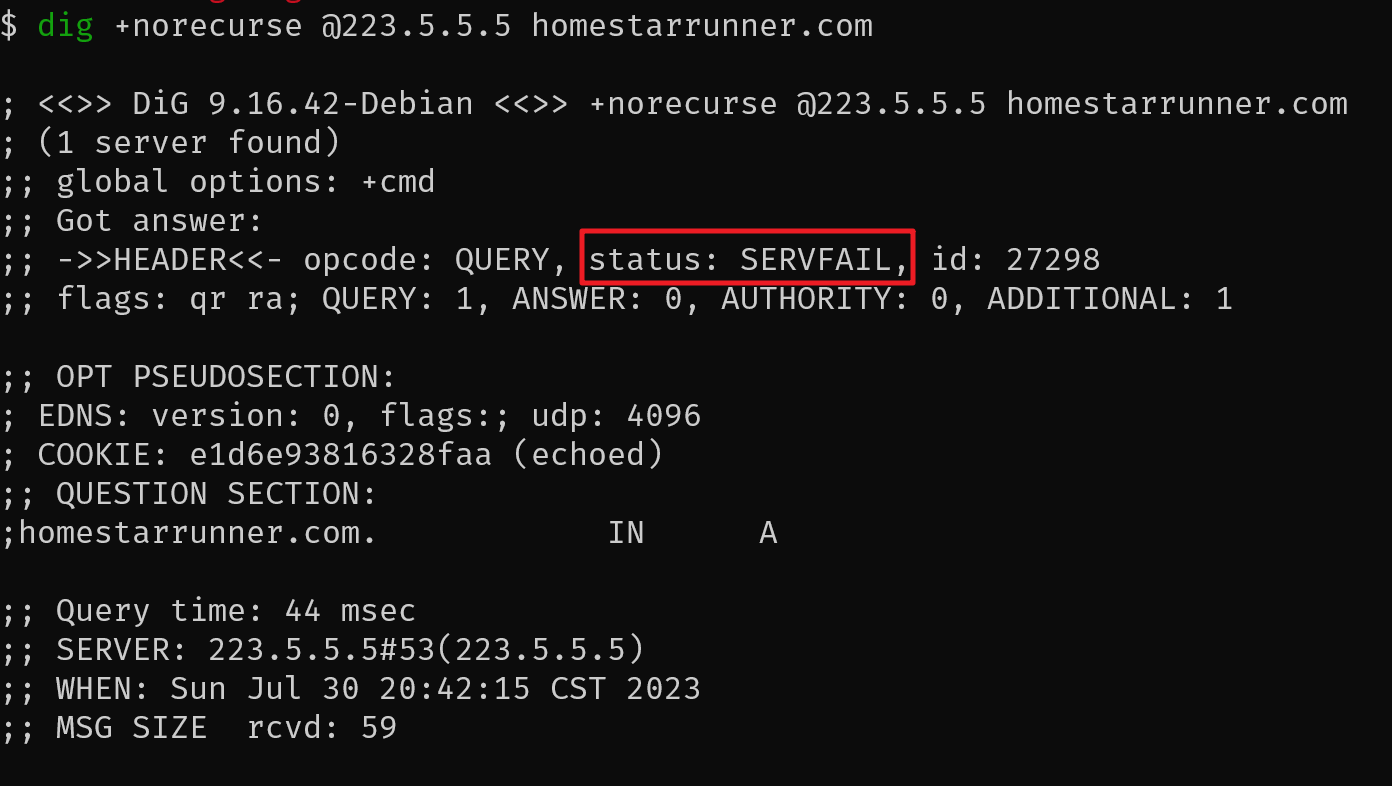

现在我们再尝试请求一个不是很常见的域名homestarrunner.com,我们可以发现status变成了SERVFAIL

这里的SERVFAIL并不代表不存在对于homestarrunner.com的域名解析,只是在阿里云的服务器中并没有缓存这个域名而已。

不过对于上面这一长串由dig提供的调试信息,如果我们不是经常和它打交道的话看着还是会有点迷惑。比如:

->>HEADER<<-,flags:,OPT PSEUDOSECTION:,QUESTION SECTION:,MSG SIZE rcvd: 59这些都是啥玩意?为什么有的地方看起来是新内容但没换行(比如OPT PSEUDOSECTION:和QUESTION SECTION:)? 为什么有的返回报文中MSG SIZE rcvd: 59这里是59,而有的报文又是90?不同的报文之间是有啥不同的字段吗? 总之,从上面的一些问题中,我们可以发现dig的一些输出内容有点像是某些人临时写的一个用于获取这些信息的脚本,而并非有意为了可读性进行一些刻意的设计,为此我们有的时候需要查阅文档来搞懂发生了什么。

这里有一篇文章是原博客作者介绍了如何使用dig的:How to use dig (jvns.ca)

还有三个工具可以用于更友好的进行一些简单的调试:

不过对于这些工具有的时候会缺少一些高级功能,比如在原博客发布的时候dog和doggo都还不支持+norecurse这样的功能。所以有的时候学会dig还是有用的

通过添加一个+yaml的参数,可以让dig的输出信息更加格式化。不过这样的缺点是返回的信息有点太多了。

在DNS请求中,总是会出现一些奇奇怪怪但是容易不小心就掉进去的陷进。

一些更常见的问题可以翻阅这篇博客:Some ways DNS can break (jvns.ca)

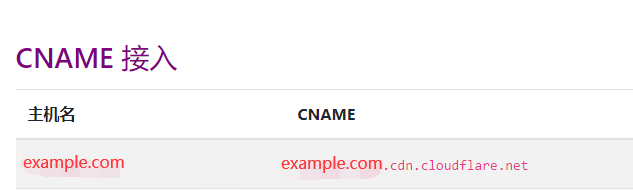

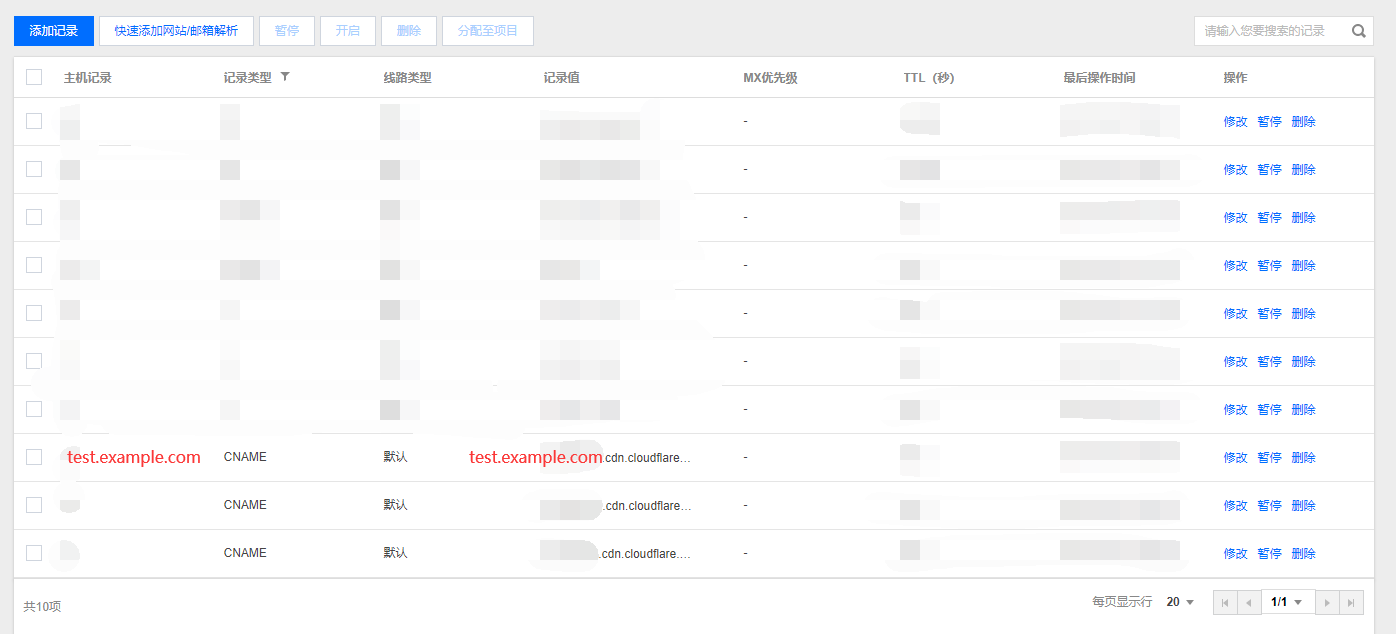

被动缓存:由于DNS会记录不存在的域名 ,因此假设你在类似cloudflare一类的平台添加自己的DNS解析之前,如果先在自己电脑上访问并被系统缓存了"该域名不存在解析条目"这个结果,即使你后面为这个域名添加了有效的记录,但也要等到之前那条缓存失效了,新的有效结果才能被识别到。

在不同平台上对于getaddrinfo的实现并不相同,比如在今年之前,你是没法通过tcp来在musl平台上发起一个dns请求的。

有的解析服务器并不尊重解析本应该有的TTL,比如原本你设置了一个域名abc.com的TTL为一分钟或者两分钟。但是路由器认为大部分网络服务都是稳定的(对于非开发人员来说其实倒也是),有可能就会忽略这一点,而硬给你设置一个比如一两个小时的TTL。结果就会导致本来两分钟就应该生效的修改过了一两个小时都没好

在Nginx中,如果你按下面的方式配置了一个反向代理

1 2 3 location / {proxy_pass https://some.domain.com;

那么Nginx只会在第一次启动的时候尝试解析这个域名,之后则再也不会进行解析。如果你在这个过程中修改了some.domain.com域名指向的IP,就很有可能会出现一些不应该出现的问题。

这个问题实际上也有一些解决方案,不过不是这篇博客的重点

ndonts会使得k8s中的DNS请求变慢:Kubernetes pods /etc/resolv.conf ndots:5 option and why it may negatively affect your application performances (pracucci.com)

由于我自己对k8s目前接触不多,因此这里只是贴了一个链接。等以后有接触以后再回过头来研究研究

在DNS上踩坑往往可能是一件不起眼,但是遇到了就挺难排查的问题。也许最好的解决方案还是尽可能的去见识下别人遇到的问题。再放一次作者记录的常见问题:Some ways DNS can break (jvns.ca)

]]>

+

+ 知识记录

+

+

+

+

+

+

+ DNS

+

+

+

+

+

+

+

+

+ 网络抓包记录

+ /p/3930e42b.html

+

+ 这个博客主要记录了自己尝试通过抓包分析并解决一些问题的心路历程,从结果上来说很可能问题并没有解决,但是尝试解决这个问题的过程中遇到的一些问题以及自己的思考想通过写博客的方式先记录下来,在以后自己知识储备扩充的时候也许就可以回过头来看看解决下。

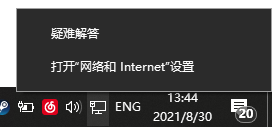

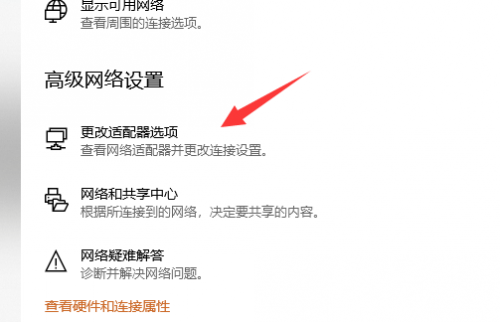

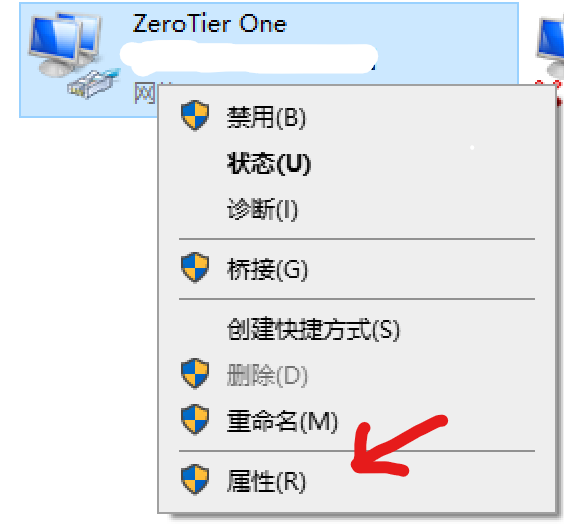

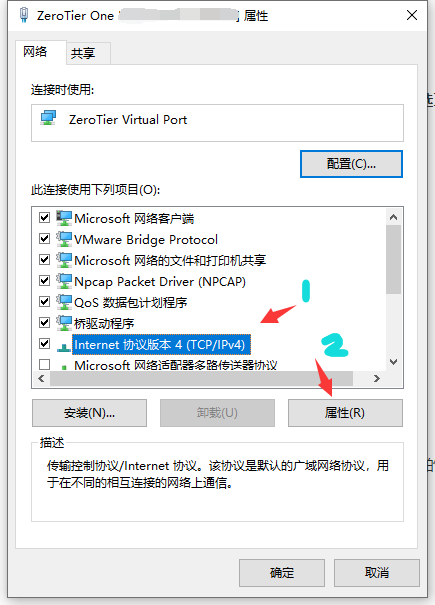

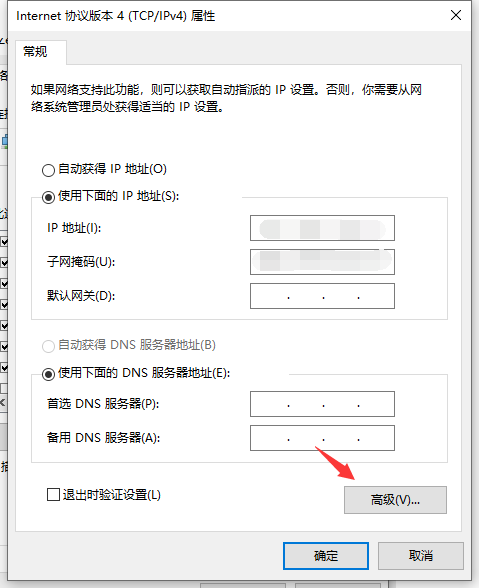

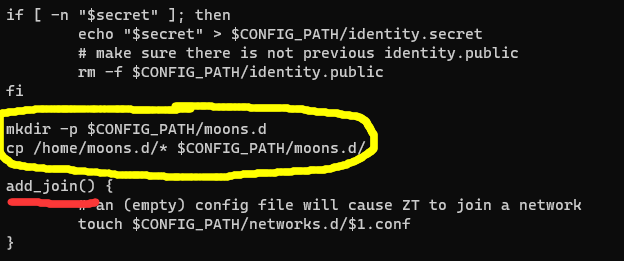

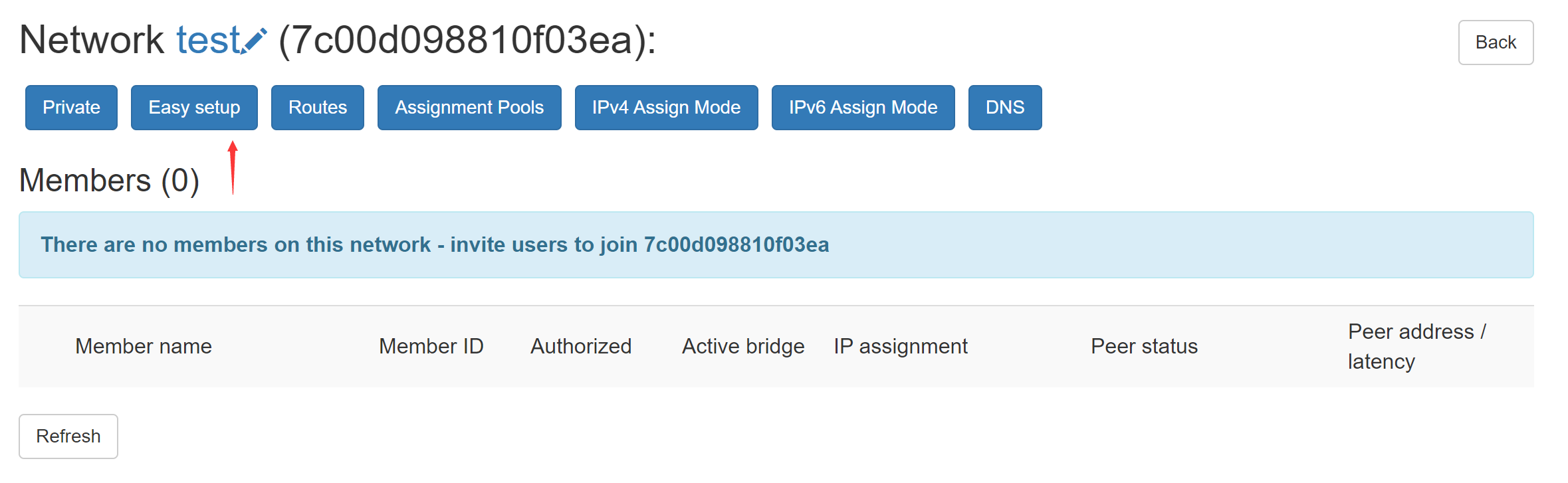

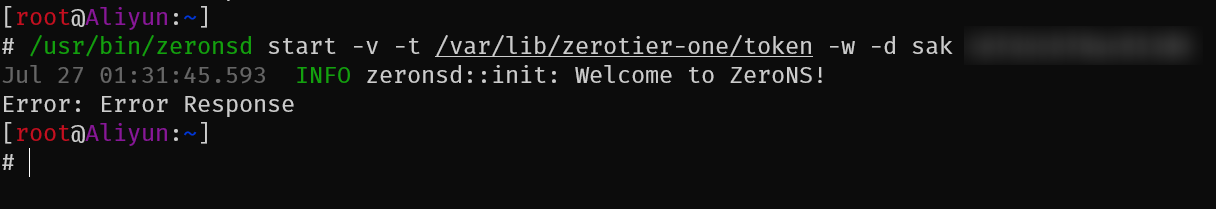

今天在尝试部署zerotier的zeronsd私有DNS服务的时候遇到了一个问题:无论是在我之前国内的服务器A上还是香港的服务器B上,zeronsd的部署都是只需要无脑复制粘贴指令就能成功,但是今天尝试在新租赁的国内服务器C上部署的时候则遇到了一个报错:Error Response

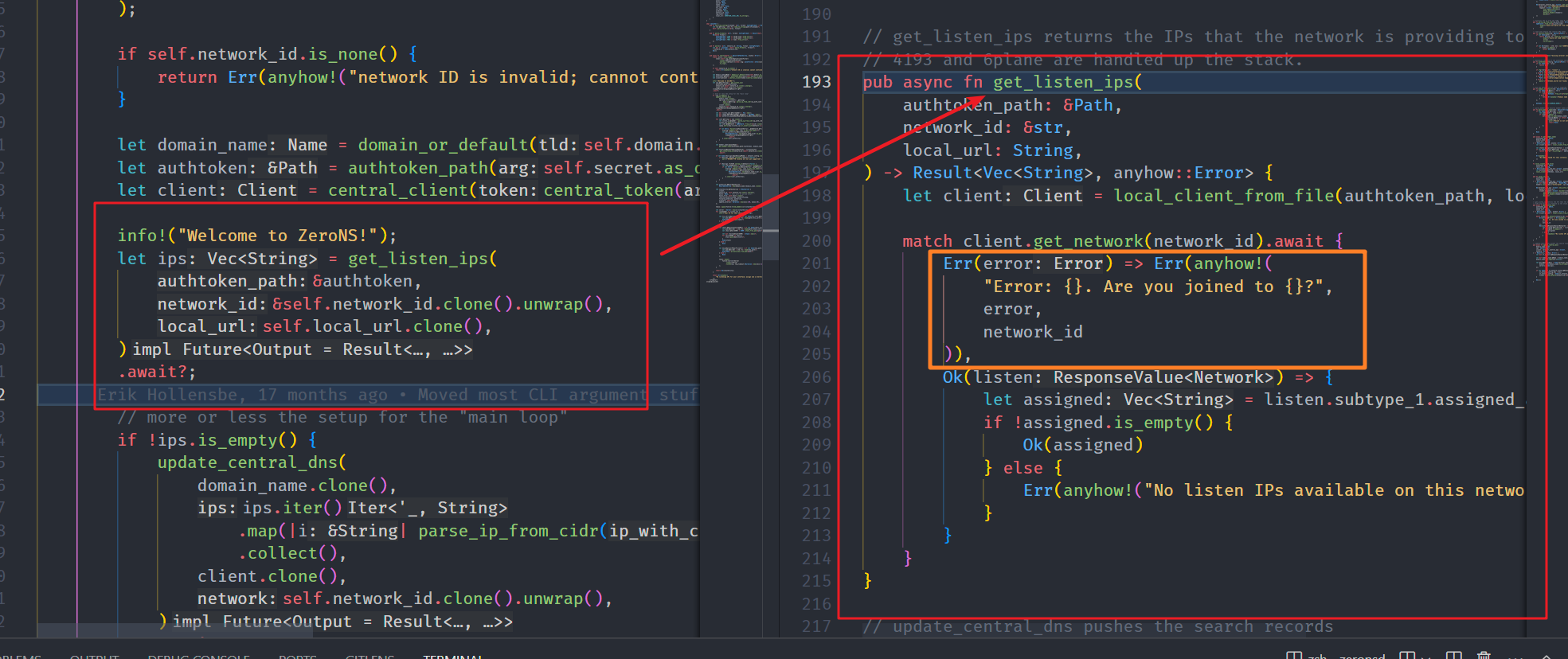

在翻阅zeronsd源码的时候发现这块逻辑本来应该是对应请求zerotier那边获取到局域网内所有设备的IP以便于创建私有的DNS条目。

可以看见这部分错误处理里面并没有Error Response的产生原因,而且同时我在香港的服务器上依旧可以正常使用zeronsd。因此也产生了想尝试通过抓包找到问题所在的想法。

lsof获取目标IP既然知道了问题是来自于zeronsd,而且应该是一个和网络Response有关系的问题,那么通过抓包应该是最通用的排查方法。在这里首先通过lsof工具查询zeronsd打开的连接

最开始找到的指令是先通过pidof zeronsd找到进程的pid,然后通过pid来用lsof查询,指令大概是lsof -p $(pidof zeronsd),结果后面翻了下lsof的手册,发现可以直接用-c来找进程,不过pidof以后也感觉会用到,姑且做个记录。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 [root@Aliyun:~]# lsof -c zeronsd

可以发现下面有创建一个TCP连接,并且是处于SYN_SENT的状态。同时在我短时间内重复输入lsof的指令(蠢但有效.jpg),发现返回的依旧是SYN_SENT。一般来说SYN握手的速度应该是很快的,这里很长时间内都处于SYN_SENT的状态就明显很不对劲,所以接下来就需要通过抓包来分析。

在我多次尝试了lsof之后,发现即使有的时候能让连接处于ESTABLISHED的状态,但是过了一会以后依旧会被掐断,并且返回Error Response。通过分析不同的lsof建立TCP连接的目标ip,发现服务器总是向151.101.109.91和146.75.113.91建立连接,应该是请求的域名有做CDN所以解析到了不同的IP。接下来知道了目标IP,抓包就很容易了。这里采取的是通过tshark在配置较弱的服务器上获取到了数据包以后再导出到本地计算机的Wireshark的方法进行分析。

tshark抓包分析首先使用下面的指令对所有http请求进行抓取,并将抓包的内容保存在data.cap文件中

1 tshark -d tcp.port==443,http -w data.cap

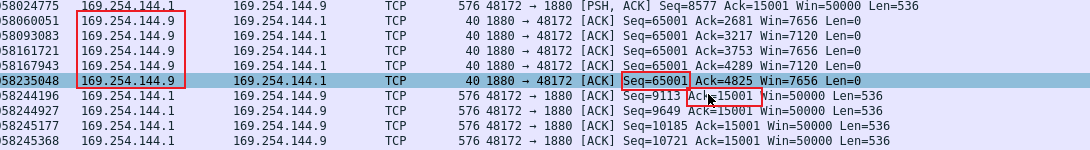

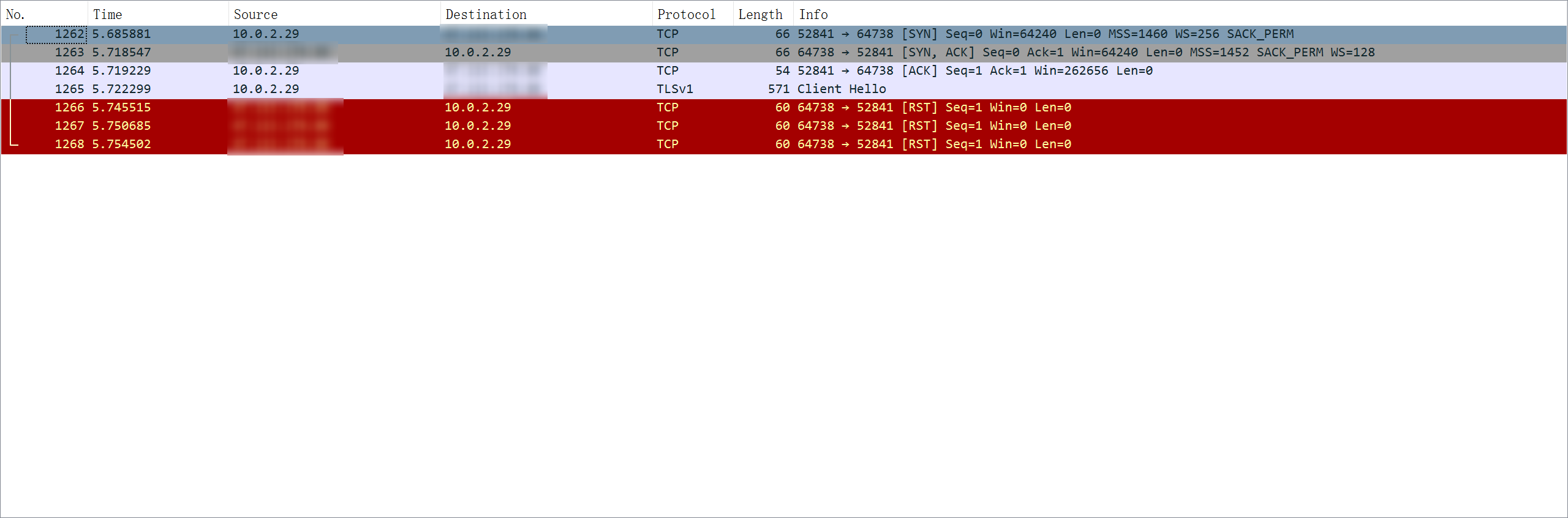

之后再将这个文件下载到本地电脑使用Wireshark过滤选定目标IP追踪TCP流,可以发现数据流如下图

可以发现就这一次的数据来说SYN握手的部分是成功了的,TLS的四次握手也能成功建立,但是在发送了一些应用数据之后,云的服务器就开始向远端服务器发送RST报文来请求强制终止连接了。重新抓包以后又发现出现了多次TCP数据包的重传。

对于在TCP连接中,先发送了FIN,然后发送RST的一个可能性的原因如下:

您的流中的FIN和RST数据包并不直接相关。通过发送FIN,表示没有更多要发送的数据。它仍然可以从连接的另一端接收更多数据。然而,当有更多数据到达时,发送RST来表示应用程序将不再从套接字读取任何数据。

如果一个应用程序想要干净地关闭TCP连接而不引发任何RST数据包,则必须首先使用shutdown系统调用关闭写入套接字,同时保持读取套接字处于打开状态。在关闭写入套接字之后,它仍然需要读取所有对方要发送的数据,然后才能完全关闭套接字。

但是zeronsd对于这次连接的重置是返回了Error的,所以基本上可以判断并不是zeronsd本身发送的rst阻断连接。

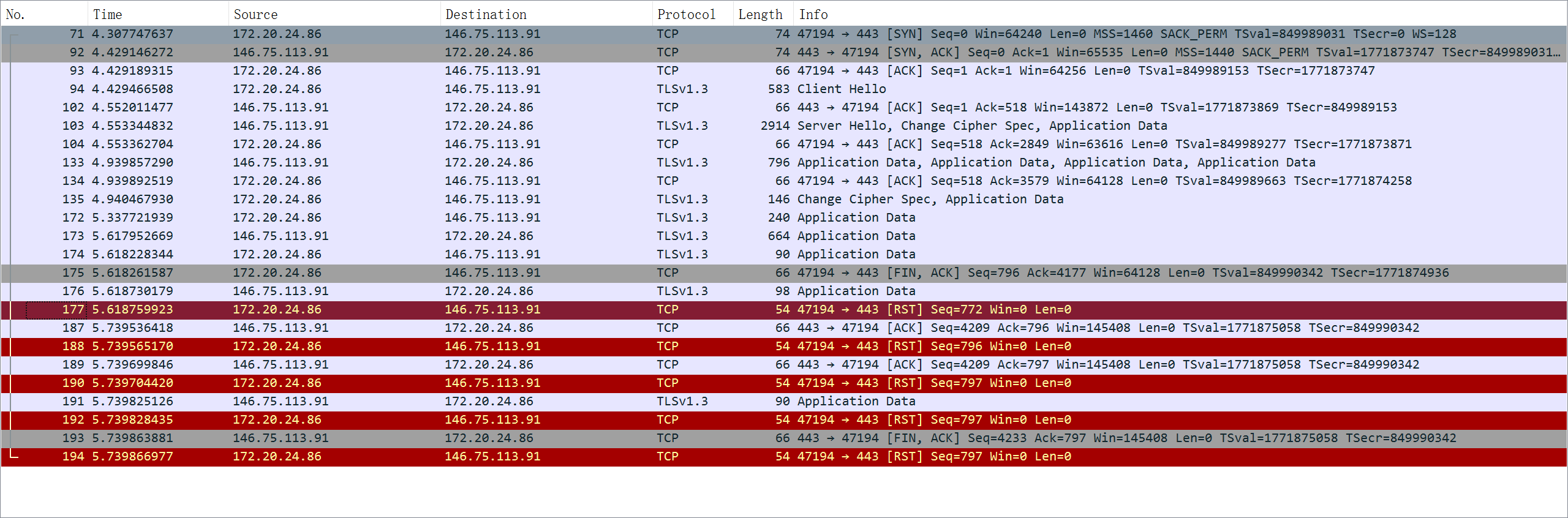

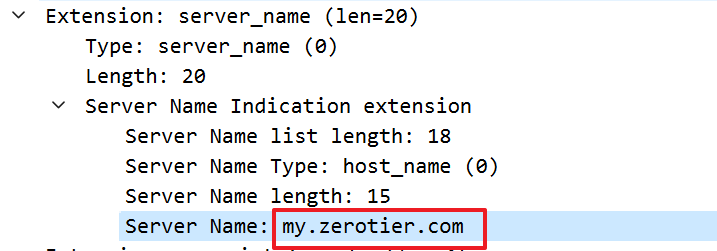

在这里为了让后续抓包更容易复现,首先对于TLS建立握手的第一个数据包,我们可以直接查询到域名

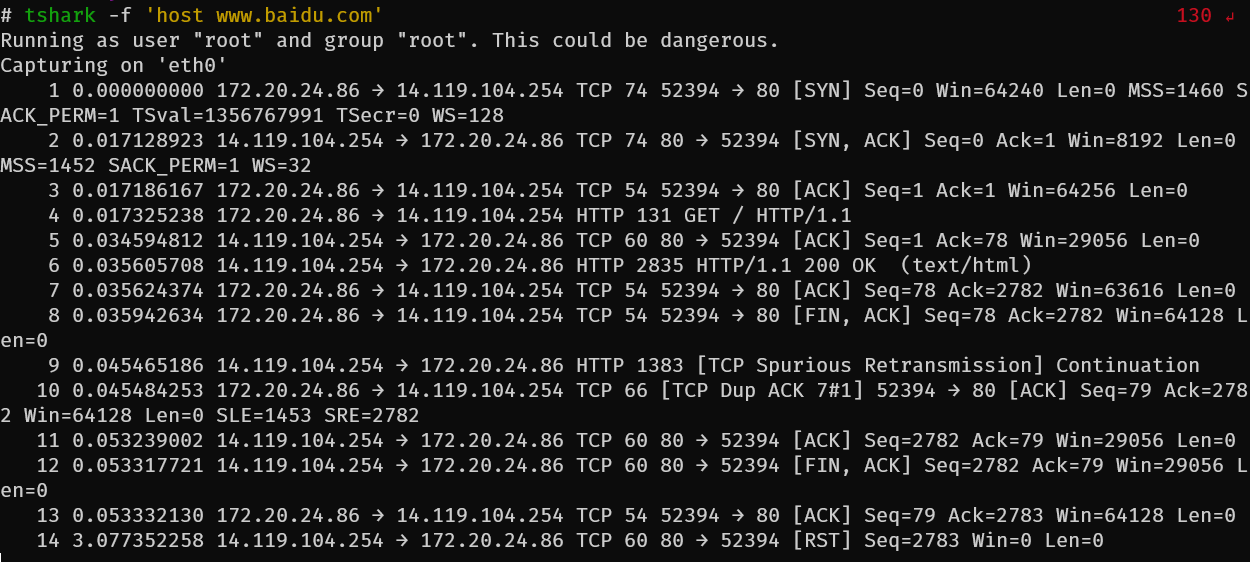

之后我就尝试通过curl -vL my.zerotier.com的方法来通过抓取curl包分析问题。为了区分成功和失败的区别,我在这里也使用了curl -vL www.baidu.com作为对照组。

返回的抓包内容大致如下:

可以发现整个连接没有大问题,只是在连接结束以后百度那边发送了一个rst包给我们,但是tcp的四次挥手是正常完成了的。

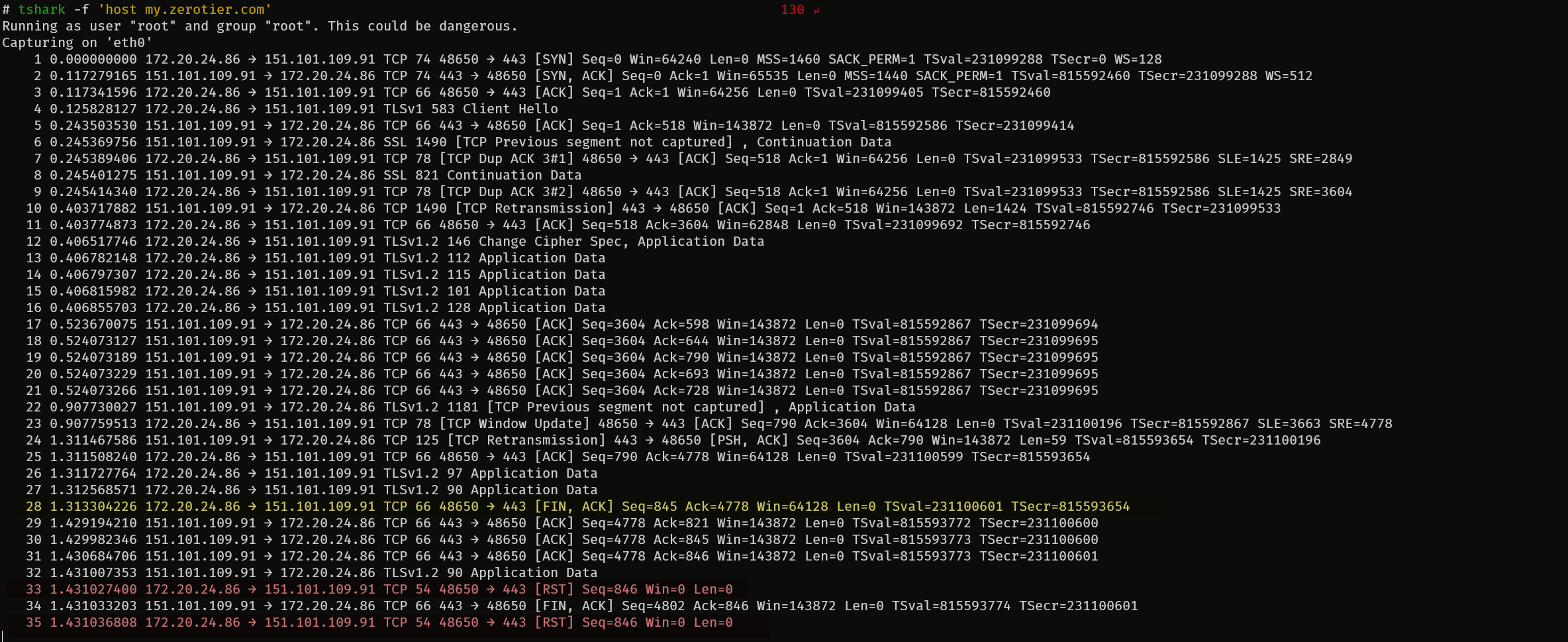

可以发现在想要结束连接的时候并没有正常挥手,在客户端这边接收到服务器那边的FIN之前就开始给服务器发送RST报文尝试断开连接

这次抓包本身没有获取到啥决定性的信息可以确定问题产生的原因,因此目前自己也只能借由Zerotier和百度请求的对比,怀疑是因为Zerotier是国外网站,被服务商阻断了(但是在FIN之后再阻断也很奇怪,虽然会在FIN之后发送RST报文,但是curl还是可以读取到my.zerotier.com的网页信息),暂时对进一步的排查没有头绪。

我尝试在同一台服务器上部署一个VOIP服务器。也是一样使用别的服务器的时候一点问题都没有,但是在这台国内的服务器上就遇到问题了。这次遇到问题就想尽可能的搞懂原因,因此做了以下实验

实验设备:一台香港服务器(对照组),一台阿里云国内服务器(样本组),以及自己的Windows设备

实验情景:在香港和国内服务器上都部署Mumble的服务器(一个VOIP程序),然后使用Windows对这两台服务器进行连接,其中Mumble连接采取了TLS加密的方式,加密证书均为自签。

实验步骤:

使用IP直连香港服务器上在端口64738部署的murmur(Mumble服务端的别称) 使用域名voice1.abc.com连接香港服务器在端口64738部署的murmur 使用IP直连国内服务器上在端口64738部署的murmur 使用域名voice2.abc.com连接国内服务器在端口64738部署的murmur 实验期望:四种不同的方式连接murmur都能成功,且不会有明显区别

实验结果:方法1-3都可以正常访问,但是方法4连接被服务器阻断

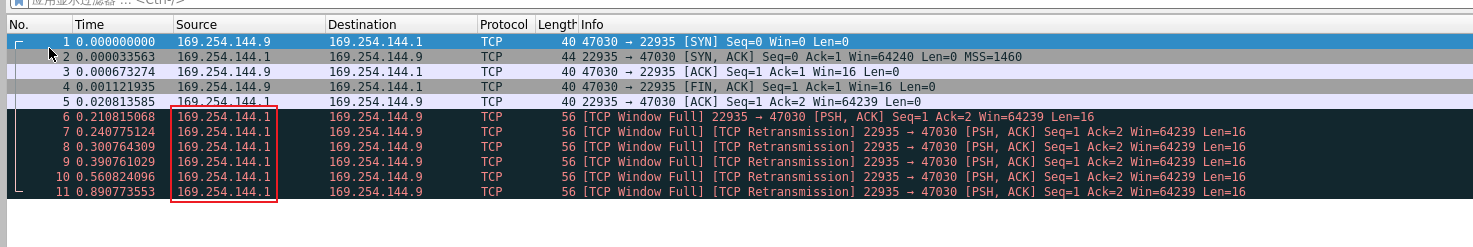

在对以上四种情况进行抓包以后,获取到的Wireshark图像大致如下

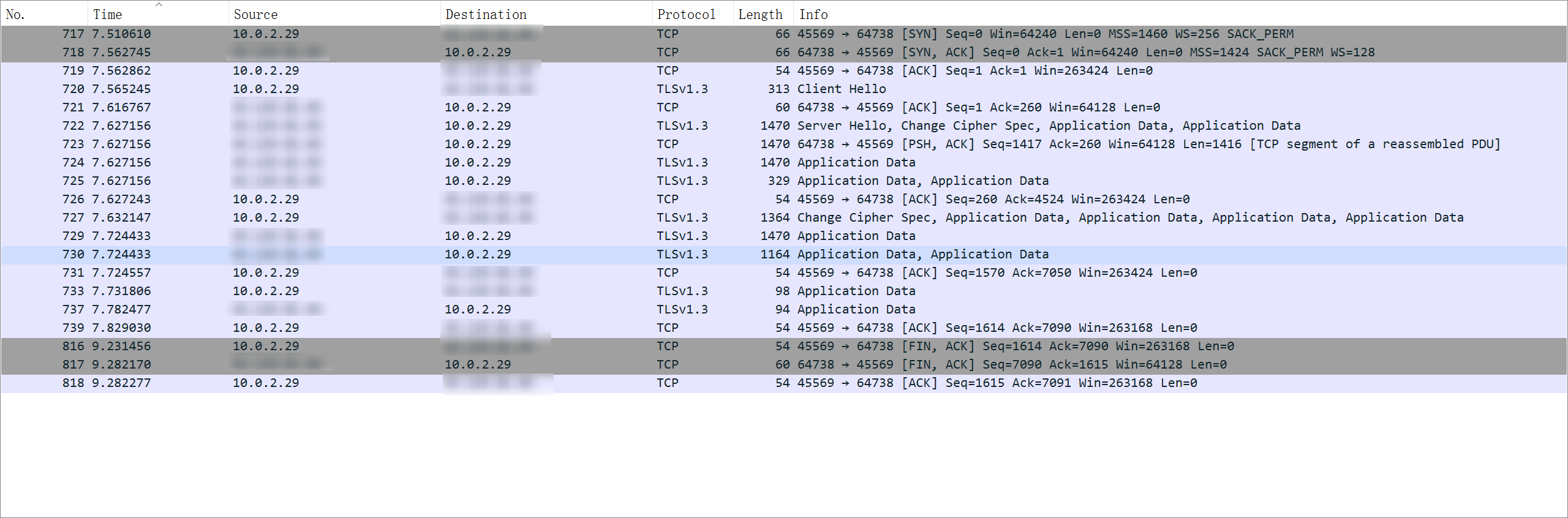

香港服务器使用域名连接

香港服务器使用IP直连

国内服务器使用IP直连

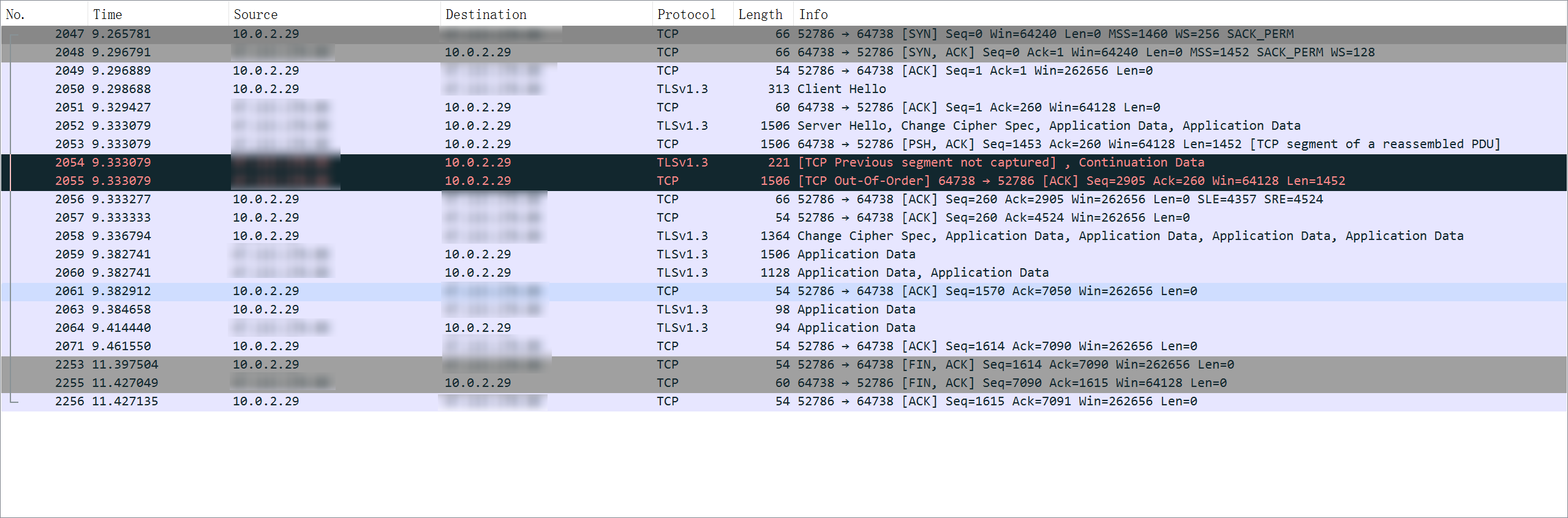

国内服务器使用域名连接

到这里基本上很明显可以发现只有在国内服务器使用域名连接的时候,服务器那边会在进行TLS握手的时候直接进行阻断,让你无法成功建立TLS连接

这次抓包也没获得啥特别有用的信息。不过由于这个问题是在用阿里云的时候才遇到,之前用同样在国内的腾讯云没有遇到,则初步怀疑是阿里云对任意端口(非443)现在都做了备案检测,只要是没备案的域名/网站,无论是TLS还是明文,只要检测到你用了域名就禁封。相比之下腾讯那边就要宽松一些,至少murmur在腾讯云上是可以正常使用域名进行连接通讯的。

]]>

+

+ 小技巧

+

+

+

+

+

+

+ Wireshark

+

+

+

+

+

+

+

+

+ 基础算法(一)

+ /p/83fa91fc.html

+

+ 题目链接:785. 快速排序 - AcWing题库

快排的主要思想是基于分治

对于一整串数组,首先找到一个值作为分界点。分界点的取值有三种取值方法:

让分界点(设为x)前面的区间部分全都是小于等于x的值,数组后面的部分则都是大于等于x的部分。

再对区间的左和右分别进行排序,只要两侧都成功排序那么整个区间就完成了排序。

该问题在处理的过程中主要的操作就是调整区间。并且最后的效果是让区间处于了两种互斥的不同状态。因此可以用双指针的做法,同时从前和末端向中间进行扫描,当他们一方扫描到需要进行交换的异端分子的时候,就等待另一端也扫描出同样的异端分子。当双方都扫描到对方的异端分子的时候,只需要将这两个异端分子同时交换,当两个指针相遇的时候,也就是处理好了所有异端分子的时候。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 void quick_sort (int q[], int l, int r) if (l >= r)return ;int x = q[(l + r) / 2 ], i = l - 1 , j = r + 1 ;while (i < j) {do while (q[i] < x);do while (q[j] > x);if (i < j)swap (q[i], q[j]);quick_sort (q, l, j), quick_sort (q, j + 1 , r);

题目链接:786. 第k个数 - AcWing题库

分界点的选取和快排相同。不同的是由于我们这里只需要第k小的数,因此在此时对划分出来的区间长度进行判断。如果k的大小小于左区间长度l,那么说明k在左区间,继续从左区间寻找第k小的数。如果k的大小大于l,说明k在右区间,在右区间寻找第(k - l)小的数。

代码实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 int k_sort (int l, int r, int k) if (l >= r)return q[l];int x = q[(l + r) >> 1 ], i = l - 1 , j = r + 1 ;while (i < j) {do while (q[i] < x);do while (q[j] > x);if (i < j)swap (q[i], q[j]);int sl = j - l + 1 ;if (k <= sl)return k_sort (l, j, k);else return k_sort (j + 1 , r, k - sl);

题目链接:787. 归并排序 - AcWing题库

确定分界点:mid = (l + r) / 2 分别递归排序左区间和右区间 将两个数组合并 归并排序的主要思路就是将原本一个大数组,使用分治的思想,从单个数字的小数组进行不断的归并,最后获得的就是一个有序的新数组。因此主要的操作也就是在合并的这个操作上。

我们需要合并的数组有两个,因此这部分只需要用两个数组分别指向这两个数组的开头。然后再创建一个临时数组用于存放归并的结果。归并的过程中只需要每次都将两个指针中最小的那个输入加入临时数组中,然后将存入的指针后移,直到两个数组中其中一个被归并完毕,再将另外一个数组后面所有的结果合入答案的临时数组,最后将临时数组的结果写入原数组中即可。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 void merge_sort (int q[], int l, int r) if (l >= r)return ;int mid = (l + r) >> 1 ;merge_sort (q, l, mid), merge_sort (q, mid + 1 , r);int merged = 0 , i = l, j = mid + 1 ;while (i <= mid && j <= r) {if (q[i] <= q[j]) {else {while (i <= mid) {while (j <= r) {for (i = l, j = 0 ; i <= r; i++, j++) {

题目链接:788. 逆序对的数量 - AcWing题库

逆序对:5 2 2 1 4,只要前面一个数比后面一个数字大,即为一个逆序对,因此有[5, 2], [5, 2], [2, 1], [5, 1], [5, 4]。这五个逆序对

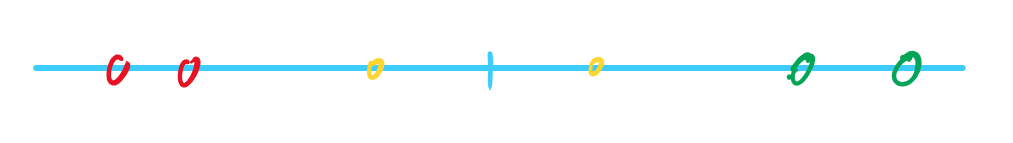

首先,这个问题可以在对一个区间对半切割以后分为三种情况

在左区间中存在两个数字是逆序对 在右区间中存在两个数字是逆序对 在中间的两个黄色中,左区间存在一个数字是右区间的逆序对 其次,在这里引入归并排序的思想。在归并排序中,对于整个区间的排序本质上是对于最小区间(两个数字)之间的大小比较和扶正,最后扩展为整个区间的大小比较和扶正(分治)。带入到这个问题中,其实就是首先视 第三种情况 为最小的情况,然后最后的所有结果其实都是第三种情况的总和,所谓的第一种情况和第二种情况将会在最小区间的过程中被直接统计进入结果当中,也就是说我们只需要求出所有第三种情况逆序对的数量再加起来就是最后答案。

目前我们只考虑黄色的情况,因此对于一个区间,我们可以分成p和q两个部分来考虑。假设在p和q上有符合归并排序的两个指针i和j,且当前的情况符合了逆序对的p[i] > q[j]的定义。此时我们可以很容易就知道从i到mid这整个区间的数字都是大于q[j]的,而这个区间内数字的数量为mid - i + 1。通过这个规律,我们就可以知道如果我们想要统计所有的黄色情况中逆序对的数量,我们只需要将所有符合p[i] > q[j]情况的mid - i + 1数量加起来,就是最后答案。

代码实现:

关于计算逆序对的数量问题,假设总共有n个数据,由于每两个数据是一组,从n和n-1可以为一组的情况下来考虑,最后总共可以有(n(n - 1))/2大小的答案,如果数据集到达了类似100000量级的时候,最后答案会超过int的范围,因此有可能需要使用long long

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 const int N = 100010 ;int tmp[N], q[N], n;long long count_pair (int l, int r) if (l >= r)return 0 ;int mid = (l + r) >> 1 ;long long res = merge_sort (l, mid) + merge_sort (mid + 1 , r);int merged = 0 , i = l, j = mid + 1 ;while (i <= mid && j <= r) {if (q[i] <= q[j]) {else {1 ;while (i <= mid) {while (j <= r) {for (i = l, j = 0 ; i <= r; i++, j++) {return res;

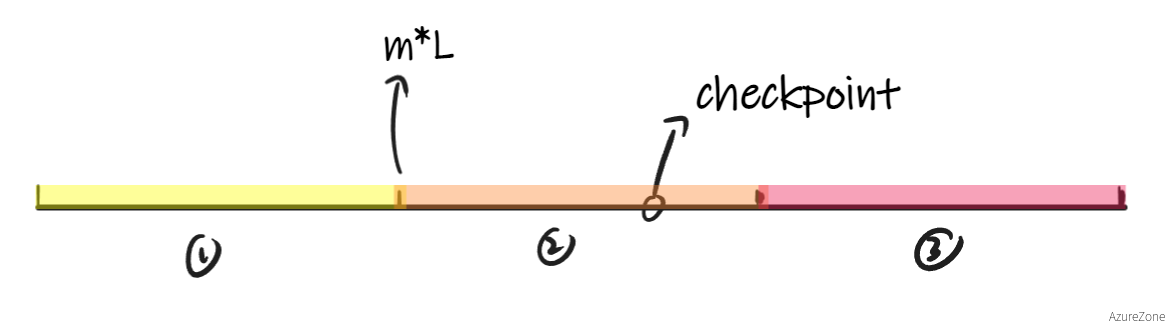

二分算法的本质为在一个区间中,存在一个位置使得区间的性质发生了变化,进而来寻找这个变化的点。

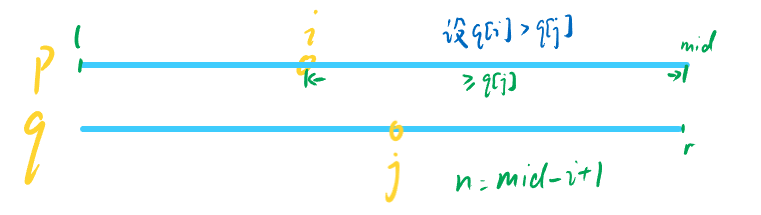

以上面这个图为例,对于红色区间和绿色区间,假设他们有不同的性质,且一个以A作为分界点,一个以B作为分界点。那么在使用二分的时候就有两种考虑

在分类之前,首先对于所有的二分情况都有一个check()函数,用于判断某个点是否符合某个状态。在这里我们假设为某个点是否符合某个颜色(红/绿)区间的范围内

如果我们需要使用二分法来取得A点的位置,那么假设我们先设了中点mid=(l + r)/2,那么就有两种情况。第一种情况是mid处于红色范围内,那么我们便很容易可以知道点A一定在mid到r之间

此时我们只需要有新的l = mid,然后从l到r中再次进行二分,直到l和r不为l < r的关系即可

和上图相反,如果我们是mid处于了绿色范围中,那么我们首先可以知道的是,mid这个点自身是不符合红色区间的范围的。因此我们也只需要有新的r = mid - 1即可。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 12 int bsearch_left (int l, int r) while (l < r) {int mid = (l + r + 1 ) >> 1 ;if (check (mid)) {else {1 ;return l;

绿色区间和红色区间主要思路完全相同,只有区间在移动边界的时候条件不同。当需要右移区间的时候,有l = mid + 1,而区间如果要左移,只需要r = mid即可。因为这里这里不存在mid当区间长度为2的时候,如果右移区间会死循环的问题,因此mid直接取(l + r) >> 1即可。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 int binary_search (int l, int r) while (l < r) {int mid = (l + r) >> 1 ;if (check (mid)) {else {1 ;return l;

题目链接:789. 数的范围 - AcWing题库

首先对于二分的题目,首先找出区分***红色区间***和***绿色区间*的check()函数。在这个题目中,主要目的是找到针对某个数字target,求出在数组中target最小的区间边界和最大的区间边界。因此可以通过 大于等于target和 小于等于target**来写出两个二分的函数,分别用于寻找左边界和右边界的位置

代码实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 int bsearch_left (int l, int r, int value) while (l < r) {int mid = (l + r) >> 1 ;if (numbers[mid] >= value) {else {1 ;return l;int bsearch_right (int l, int r, int value) while (l < r) {int mid = (l + r + 1 ) >> 1 ;if (numbers[mid] <= value) {else {1 ;return l;

题目链接:791. 高精度加法 - AcWing题库

高精度加法本质就是以字符串将数字读入以后,代码模拟手动计算十进制的过程,大于十就进一位。

模板实现:

这里一定要注意A[i]或者B[i]是否为数字,如果是字符的话还需要进行- '0'来让结果变成数字

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 vector<int > add (const vector<int > &A, const vector<int > &B) {int > C;int t = 0 ; for (int i = 0 ; i < A.size () || i < B.size (); i++) {if (i < A.size ())if (i < B.size ())push_back (t % 10 );10 ;if (t)push_back (1 );return C;

题目链接:792. 高精度减法 - AcWing题库

高精度减法在实现之前,首先要确定被减项比减去的值要大,如果小的话则要提前分类讨论输出一个负号。

判断大小的一个简单实现:

1 2 3 4 5 6 7 8 9 10 11 bool operator >(const vector<int > &rhs, const vector<int > &lhs) {if (rhs.size () != lhs.size ())return rhs.size () > lhs.size ();for (int i = rhs.size () - 1 ; i >= 0 ; i--) {if (rhs[i] != lhs[i]) {return rhs[i] > lhs[i];return false ;

对于减法的模拟流程,和加法主要的不同就是借位的操作。借位主要体现在计算第i位的A[i]和B[i]的运算的时候,如果有A[i] - B[i]结果是负数的话,那么A[i]就需要向A[i + 1]进行借位。这个时候我们只需要单独使用一个变量t,如果当前运算结果为负数需要借位了则让t为1,并且在每次运算前让A[i]减去t来实现借位的操作。

同时在执行完了减法的逻辑之后,由于减法和加法不同,可能会出现"0001"这种数字,我们还需要将所有除了最后一位(因为答案可能为"0")的所有0给去掉。因为通过vector存储的数字是倒序,也就是说"0001"在数组里面是[1, 0, 0, 0]。因此我们只需要每次都把答案的末尾给剔除即可。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 vector<int > sub (const vector<int > &A, const vector<int > &B) {int > ans;for (int i = 0 , t = 0 ; i < A.size (); i++) {if (i < B.size ())push_back ((t + 10 ) % 10 );if (t < 0 ) {1 ;else {0 ;while (ans.size () > 1 && ans.back () == 0 )pop_back ();return ans;

题目链接:793. 高精度乘法 - AcWing题库

高精度乘法的主要思路和高精度加法差不多,这类题目通常为一个大整数乘以一个小整数。对于这种情况下的乘法,我们只需要先将大整数和之前一样序列化成一个vector<int>的变量,然后和加法一样让容器每一位都和小整数相乘,大于10的部分留给下一位用于进位即可。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 vector<int > mul (const vector<int > &A, int b) {if (b == 0 ) {return {0 };int > ans;for (int i = 0 , t = 0 ; i < A.size () || t; i++) {if (i < A.size ())push_back (t % 10 );10 ;return ans;

题目链接:794. 高精度除法 - AcWing题库

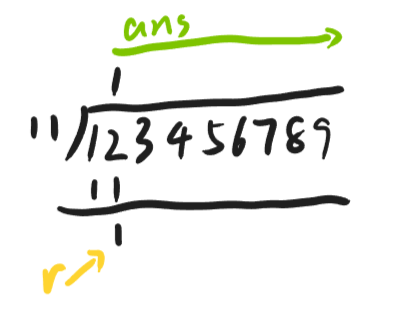

高精度除法的题目一般形式为一个大数除以一个小数。此时假设大数是123456789,小数是11。这种情况下按照正常计算逻辑大致如下:

由于在加减乘法中,我们都是将数字以[9, 8, 7, 6, 5, 4, 3, 2, 1]的顺序存储的,因此我们在计算除法的时候需要从A[A.size() - 1]的位置开始正常除法的计算逻辑,直到A[0]。其中在每次除的过程中,假设经过上次运算(默认的r = 0)的r是r',那么在下一次计算的时候用于计算的余数则是r = r' + A[i],然后只需要将除数放入ans的数组中,然后余数继续留给下一次计算即可。

模板实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 vector<int > div (const vector<int > &A, int diver, int &reminder) {int > ans;0 ;for (int i = A.size () - 1 ; i >= 0 ; i--) {10 + A[i];push_back (reminder / diver);reverse (ans.begin (), ans.end ());while (ans.size () > 1 && ans.back () == 0 ) {pop_back ();return ans;

+

+ 知识记录

+

+

+

+

+

+

+ 算法

+

+

+

+

+

+

+

+

+ 使用clink优化cmd

+ /p/82bd449c.html

+

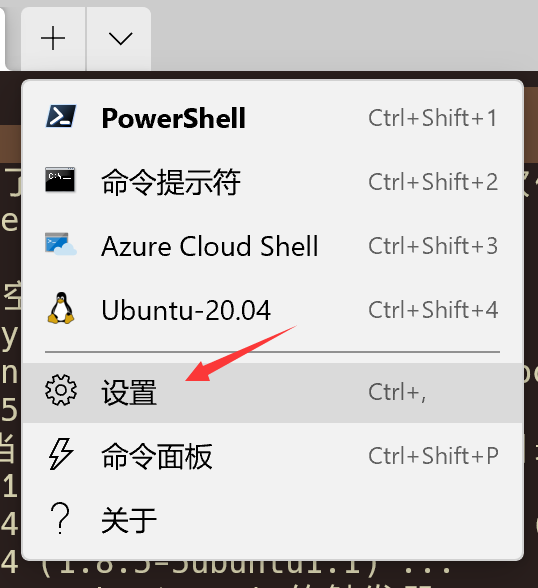

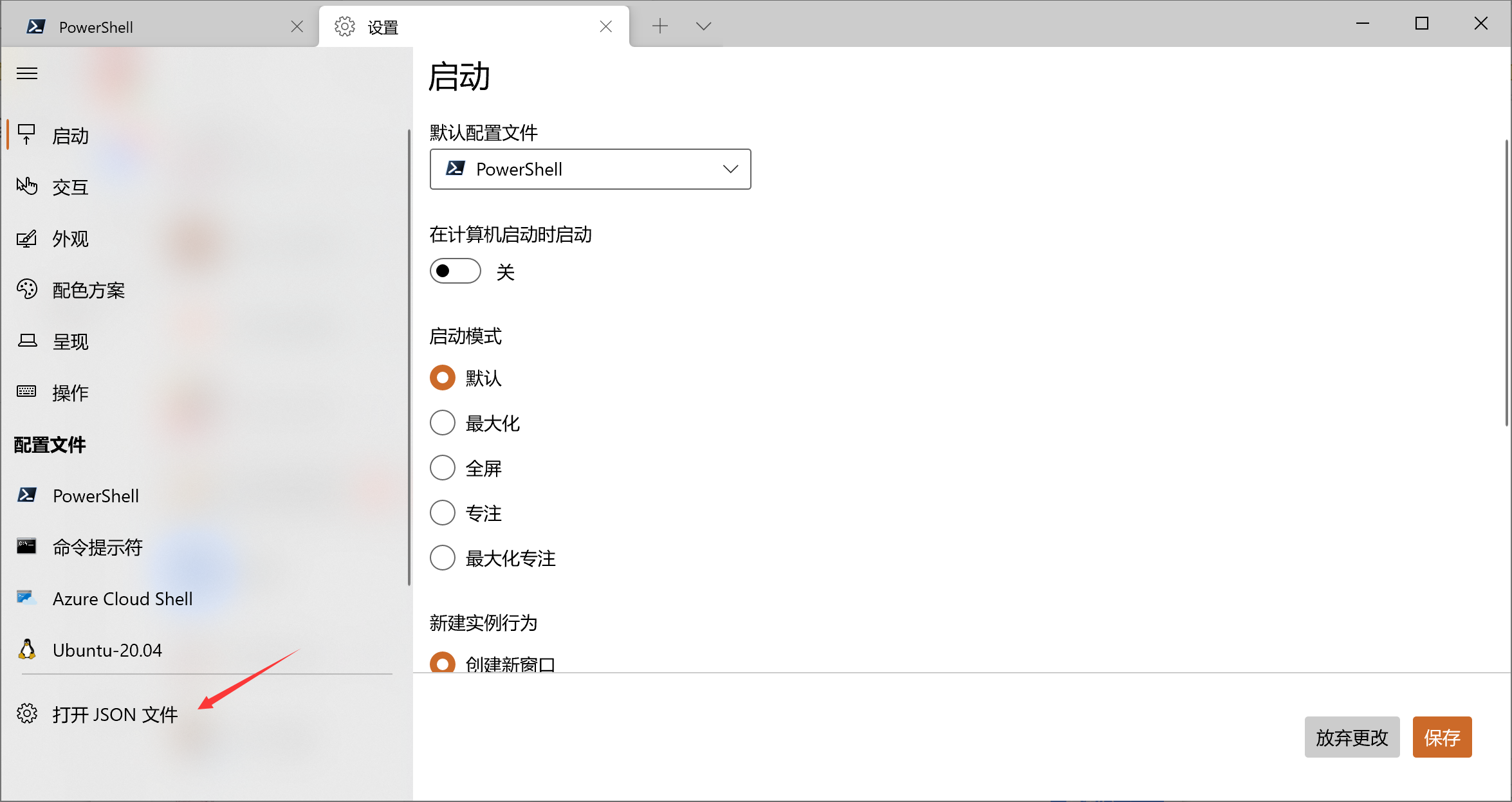

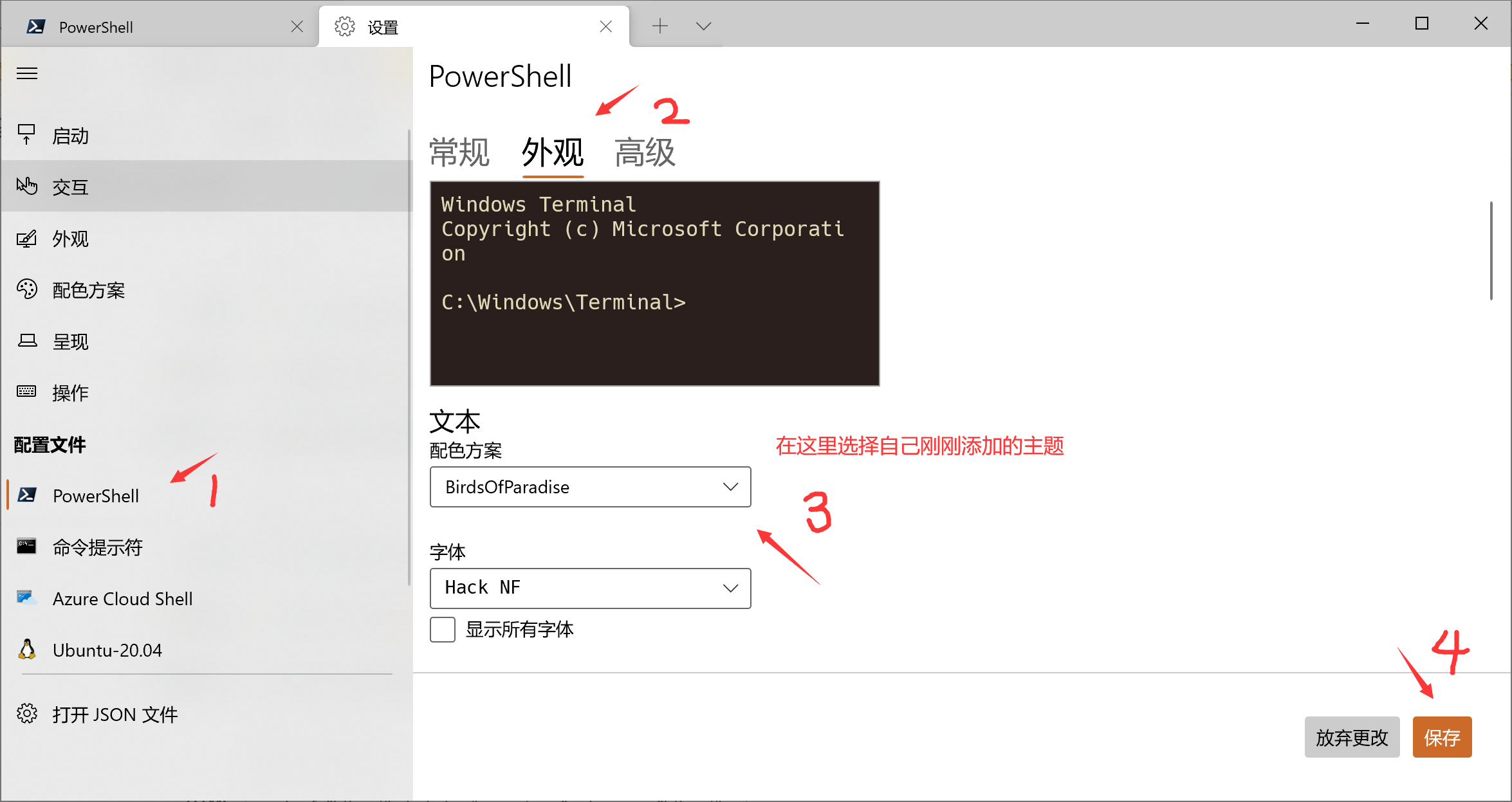

+ 苦于powershell每次都要一秒多的启动速度,偶然这两天发现了clink这个用于提升cmd体验的工具,尝试了下发现经过简单的配置以后可以替代平时绝大部分ps的需求。因此在这里记录一下基本配置流程。

clink和clink-flex-prompt都可以使用scoop在Windows中完成安装。其中clink的大致效果就是在启动cmd的时候进行注入,来实现一些额外功能的扩展。clink-flex-prompt提供的功能则是类似oh-my-zsh的prompt自定义,让交互界面不至于太苍白

1 scoop install clink clink-flex-prompt

这两个组件都是在scoop默认的main仓库就有,不需要添加额外的bucket就能直接安装。

在使用scoop安装了clink之后,还需要使用

指令来实现每次启动cmd之前都自动启用clink,也可以使用clink inject来在当前的cmd当中暂时体验一下clink的效果

依据Clink官方文档 中的提及,原本是会有一个Use enhanced default settings的选项来默认实现一些自动填充或快捷键的功能。但在使用scoop安装clink的情况下,至少可以发现自动显示suggestions补全的功能是没有被配置好的。

对于autosuggest的功能,只需要执行下面的指令就可以实现

1 clink set autosuggest.enable true

类似zsh有一个.zshrc,对于clink来说也有一个.inputrc的文件用于初始化clink的配置文件。

使用CMD输入下面的指令来在Windows的用户目录创建inputrc

1 notepad %userprofile% \.inputrc

创建好了以后可以在其中粘贴以下内容来实现一些基本的功能:

1 2 3 4 5 6 7 8 9 10 11 12 13 # Some common Readline config settings.set colored-stats on # Turn on completion colors.set colored-completion-prefix on # Color the typed completion prefix.in Clink.if clinkset search-ignore-case on # Case insensitive history searches.set completion-auto-query-items on # Prompt before showing completions if they'll exceed half the screen.

对于具体inputrc的配置写法可以看这里:Init File

使用scoop安装了flex-prompt以后的使用方式也很简单。只需要在cmd里面执行flexprompt configure以后,就可以像p10k那样来自定义一个自己需要的,较为美观的终端提示了。这一块都是有可视化交互的,就不做过多的赘述。

平时写代码的时候因为也主要是用Linux系统,对ls和rm这种指令已经敲出肌肉记忆了。Powershell里面对这些指令做了兼容,因此用的时候没有什么额外的感觉,但是切换到cmd的时候就会发现这些指令都不一样了,dir和del一类的指令用的很不顺手。这个时候就有两种解决方法。一种方法算是曲线救国,通过调用git-bash里面提供的工具来实现类似原生Linux的指令,这也是比较推荐的一种方式。

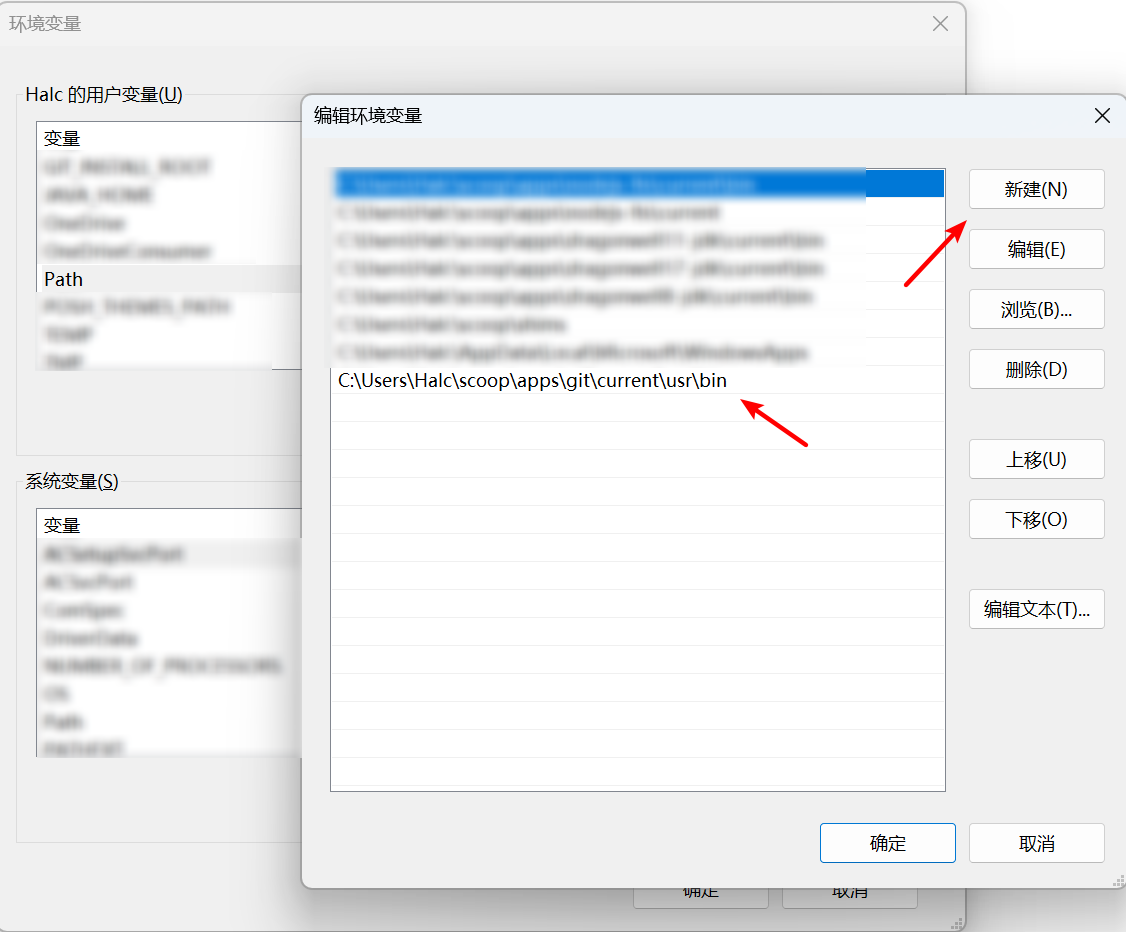

在Windows中安装好了Git之后,往往都会有一个git-bash,而我们则可以通过git-bash来实现一些本来在Linux才能执行的指令。而之所以能达到这种效果,是因为Git在安装好了以后在安装目录下有一个/usr/bin的文件夹,里面已经预先放好了可以使用的类似Linux中的一些基本指令,诸如ls和cat这种常用工具都已经有了。因此我们只需要在系统的环境变量中,将<Git的安装路径>\usr\bin添加到PATH中即可。

比如我是使用scoop安装了git,因此我的git安装路径如下:

1 C:\Users \Halc \scoop \apps \git \current \usr \bin

然后我就只需要在环境变量中把这个路径添加到PATH中,我就可以使用我需要的基础工具了:

cmd脚本预先配置好alias还有一种方式是创建alias,以替代原生cmd的一些指令。这种方法是我最先使用的方法,后面发现了git-bash中的工具是需要额外配置环境变量以后就没有使用这种方法了。

在Windows上创建alias的方法是使用doskey来执行创建,clink则支持在启动的时候自动执行一个cmd脚本,来实现doskey的读入。为此clink默认会从以下路径来寻找clink_start.cmd文件,用以初始化cmd控制台

Windows XP: C:\Documents and Settings\<username>\Local Settings\Application Data\clink Windows Vista以及更高的版本:C:\Users\<username>\AppData\Local\clink 如果需要修改clink_start.cmd的位置,可以参考这部分文档:File Locations

在这里我的操作系统目前是Windows 10,因此我只需要在C:\Users\<username>\AppData\Local\clink目录下创建clink_start.cmd文件,并写入以下内容

1 2 3 4 5 6 @echo off

然后保存以后,就会在下一次启动cmd之前执行这些doskey指令,来实现alias的效果了。

最后的最后,只需要在Windows Terminal里面设置cmd为默认的应用,就可以实现每次启动wt的时候,都是秒开cmd的效果了,再也不用每次都等powershell启动才能输入指令了。

+

+ 安装引导

+

+

+

+

+

+

+ Windows

+

+ cmd

+

+

+

+

+

+

+

+

+ CS144-Lab6 计算机网络:路由转发

+ /p/195b5fa9.html

+

+ 这个实验就是最后一个需要写代码的实验了。主要需要解决的问题是一个IP数据包传入之后,如何通过已有的路由表确定下一跳的IP地址

这个实验中主要的问题点就是CIDR的匹配。解决这个问题,我们只需要先将CIDR转为子网掩码,也就是以0为基数,左移(32 - 前缀)位,最后得到的也是子网掩码的值。但是这里有一个问题就是,当mask是uint32_t的时候,如果前缀的长度为0,那么子网掩码会变成255.255.255.255,但是实际上应该是0,因此我们需要对前缀是否为0进行判断。

在判断完毕之后,只需要将网关的IP地址和子网掩码按位与运算,然后将目标IP地址也和子网掩码按位与运算,如果最后的结果相同,那么就说明子网匹配

1 2 3 4 5 6 7 8 9 10 11 auto path = _route_table.end ();const auto &dst_ip = dgram.header ().dst;for (auto entry = _route_table.begin (); entry != _route_table.end (); entry++) {const uint32_t &mask = entry->prefix_length ? (~0U ) << (32 - entry->prefix_length) : 0 ;const auto network_address = entry->route_prefix & mask;if ((dst_ip & mask) == network_address) {

如果没有匹配到对应的路由规则,或者这个数据包已经经过了太多次转发都没有找到目的地,那么就将这个数据包丢弃掉。

1 2 3 4 if (path == _route_table.end () || dgram.header ().ttl-- <= 1 ) {return ;

如果没有丢弃的话,那么就只需要按照正确的接口将数据包发送出去就行,如果没有下一跳的IP地址,说明数据包已经到达了对应的目的地,只需要直接发送给目标IP即可

1 2 3 4 5 6 7 if (path->next_hop.has_value ()) {send_datagram (dgram, path->next_hop.value ());else {send_datagram (dgram, Address::from_ipv4_numeric (dgram.header ().dst));

终于也是写完了Lab0-6的所有博客总结😭,Lab7的部分不需要写代码,只需要直接运行程序聊天就行,就不写博客总结了

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ CS144-Lab5 计算机网络:Network Interface的功能

+ /p/db490294.html

+

+ 在通过TCP协议将数据包进行封装准备好以后,就需要“快递公司”来对这些数据包进行分发了。这个过程可以划分为两个部分,一个是数据包在中转转发的过程中需要经过的“中转”设备有哪些,其次就是如何选择“中转”的线路。

在网络接口的部分,主要实现的逻辑是作为发送的某一个节点,在知道了下一个中转站的IP地址以后,如何将数据包进行交付。

首先对目前的知识进行一个梳理。首先在前面四个Lab里面,主要完成的是TCP数据包从一串简单的字符串,到最后封装成一个完整的,可以用于建立连接沟通的TCP数据包。TCP数据包本身并不关心数据包是如何从源IP到目标IP的,这一部分的主要实现是由网络层的IP路由和数据链路层进行沟通。

在数据链路层中,我们假设已经通过网络层的路由知道了下一条的IP地址,但是要知道一个网口今天可以是192.168.1.1,明天就可以是10.0.0.1,因此我们只知道IP地址是不足以让我们从硬件层面将数据包进行中转发送的,我们还需要针对每一个特定网口本身的硬件地址,也就是MAC地址,来硬件和硬件之间可以正确的发送数据。

由于硬件地址和IP地址的映射关系有可能是动态的,而每次发送数据都向所有设备广播询问一次MAC和IP的映射关系的话在交流频繁的网络情况下资源利用率十分低下,因此我们也需要在中转设备中动态维护一个缓存用的映射表,同时为这个映射表中每一个条目设定对应的TTL来保证数据的实时性,在超过一定时间以后就删除该缓存。

1 2 3 4 5 6 7 8 9 10 11 12 struct ArpEntry {uint32_t raw_ip_addr;bool operator <(const ArpEntry &rhs) const { return raw_ip_addr < rhs.raw_ip_addr; }const size_t arp_max_ttl = 30000 ;size_t > _arp_table{};

而获取IP和MAC地址对应关系的这个步骤则是由ARP协议实现,在硬件自己不知道要发送的下一个网口的MAC地址的时候,他就会给所有的网口广播ARP,正确的设备识别到了这个ARP是发送给自己的以后就返回自己的MAC地址,如果不是发送给自己的则丢弃不处理。同时和TCP中的超时重传一样,ARP探针自己也有可能会因为硬件链路的问题而导致对方没有收到自己的报文,所以也需要有一个超时重传的逻辑,来让自己尽可能的收到对方的回复。

1 2 3 4 5 6 7 8 9 10 11 12 struct ArpEntry {uint32_t raw_ip_addr;bool operator <(const ArpEntry &rhs) const { return raw_ip_addr < rhs.raw_ip_addr; }const size_t arp_probe_ttl = 5000 ;size_t > _probe_table{};

在有了以上两个大体部分以后,我们就只需要实现

发送(IPV4/ARP)报文 接受(IPV4/ARP)报文 超时重传探针,以及管理ARP映射的TTL 两个部分即可。

在发送报文之前,我们首先需要将IP地址转换为uint_32,以用于报文的封装,然后检查这个IP地址我们是否已经缓存了它对应的MAC地址

1 2 3 4 5 6 7 8 9 10 11 const uint32_t next_hop_ip = next_hop.ipv4_numeric ();for (const auto &entry : _arp_table) {if (entry.first.raw_ip_addr == next_hop_ip) {break ;

如果这个IP地址对应的MAC地址我们已经缓存了,那么就只需要将这个IP报文封装成网络帧进行发送

1 2 3 4 5 6 7 8 if (next_eth.has_value ()) {header () = {next_eth.value (), _ethernet_address, EthernetHeader::TYPE_IPv4};payload () = dgram.serialize ();push (eth_frame);return ;

如果这个IP地址在我们维护的ARP映射表中并不存在对应的映射关系,那么我们首先要判断我们是否就这个IP发送过ARP探针,如果发送过探针了那么我们也没必要再发送一次,只要等待之前的探针让对方返回正确的MAC地址给我们即可。

1 2 3 4 5 6 for (auto &probe : _probe_table) {if (probe.first.raw_ip_addr == next_hop_ip) {return ;

如果没有发送的话,那么我们就需要封装一个ARP探针,用于检测目标IP对应的MAC地址,探针目标的IP地址就是IP数据包下一跳的IP,MAC地址则是广播地址(在该实验中直接将目标MAC设置为空即可)。

1 2 3 4 5 6 7 8 9 10 11 ipv4_numeric ();header () = {ETHERNET_BROADCAST, _ethernet_address, EthernetHeader::TYPE_ARP};payload () = arp_probe.serialize ();push (probe_frame);

同时由于探针有超时重传的机制,因此对于这个新发送的报文,我们也需要将其加入缓存表中并设定TTL

1 2 3

所有的代码

在接受报文的部分,我们无非会收到两种报文,一种是包含IP数据的报文,一种是对方给我们发过来的ARP报文

对于这两种报文,首先我们判断它是不是要发送给我们的或是否是一个广播的网络帧

1 2 3 4 if (frame.header ().dst != _ethernet_address && frame.header ().dst != ETHERNET_BROADCAST) {return {};

如果这是一个确定源MAC和目标MAC的IP数据包,那么我们只需要接受这个数据包然后返回对应的数据即可

1 2 3 4 5 6 if (frame.header ().type == EthernetHeader::TYPE_IPv4) {parse (frame.payload ());return datagram;

但是如果这是一个ARP探针,我们首先对其进行分析

1 2 3 4 5 6 7 parse (frame.payload ());

其中_update_arp_table用于更新arp表,具体代码如下

1 2 3 4 5 6 void NetworkInterface::_update_arp_table(initializer_list<ArpEntry> arp_entry) {for (auto &entry : arp_entry) {

在解析了网络帧之后,我们大致可以得到以下三种分类

丢弃过滤

1 2 3 4 if (dst.raw_ip_addr != _ip_address.ipv4_numeric ()) {return {};

返回我们的MAC地址

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 if (arp_msg.opcode == ARPMessage::OPCODE_REQUEST) {ipv4_numeric ();header () = {src.eth_addr, _ethernet_address, EthernetHeader::TYPE_ARP};payload () = reply.serialize ();push (reply_frame);return {};

更新自己的ARP映射表,同时检查是否有对应目标MAC地址的报文等待发送

1 2 3 4 5 6 7 8 9 for (auto entry = _probe_table.begin (); entry != _probe_table.end ();) {if (entry->first.raw_ip_addr == src.raw_ip_addr) {send_datagram (entry->first.datagram, Address::from_ipv4_numeric (entry->first.raw_ip_addr));erase (entry);else {

在这里我们只需要做两件事

对于正常的条目和探针,我们只需要让其TTL减少即可,代码如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 void NetworkInterface::tick (const size_t ms_since_last_tick) for (auto entry = _arp_table.begin (); entry != _arp_table.end ();) {if (entry->second < ms_since_last_tick) {erase (entry);else {for (auto entry = _probe_table.begin (); entry != _probe_table.end (); entry++) {if (entry->second < ms_since_last_tick) {ipv4_numeric ();header () = {ETHERNET_BROADCAST, _ethernet_address, EthernetHeader::TYPE_ARP};payload () = re_probe_arp.serialize ();push (re_probe_frame);else {

这个实验主要实现的逻辑都是数据链路层的,和之前几个Lab没有直接的关系。不过值得一提的就是在Lab4测试的时候运行的TUN和TAP很有意思。这两个词之前好奇还是在使用Clash的时候既可以是TUN也可以是TAP模式,而且通常来说TUN模式的性能要比TAP要好。当时还不知道为什么,在写完这个实验以后搜了一些资料,目前浅显的理解大致认为是TAP的网络代理模拟是有处理到数据链路层的,也就是MAC地址也进行了模拟,而TUN则只是模拟到了IP层,并没有自己的MAC地址,因此损耗也要少一些。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ CS144-Lab4 计算机网络:TCP Connection的实现

+ /p/10e77bc5.html

+

+ TCP Connection的部分本身并不难,这个实验的主要核心是学习使用tshark或wireshark一类的工具对TCP的网络状况进行分析,找出正确或错误的数据包。

在这个实验中我们需要将前面写的TCP Sender和TCP Receiver两个部分的逻辑进行合并,使得两者之间可以进行数据的传输。

除了几个可以直接调用前面实验函数的函数以外,我们主要需要完成的我认为是收到某个报文以后的处理函数segment_received(const TCPSegment &seg)和时间函数tick()。

对于接受报文这个函数,首先通过对实验报告的分析,我们可以知道我们主要要做的事情可以分为以下三个大逻辑:

记录收到这个报文的时间,无论对错 检查这个报文是否是带RST标志的报文,如果是的话则直接断开连接 如果是在LISTEN状态的时候接受到这个报文的,则要判断对方是否连接 代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 0 ;if (seg.header ().rst) {stream_out ().set_error ();stream_in ().set_error ();false ;return ;if (not _receiver.ackno ().has_value ()) {if (seg.header ().syn) {fill_window ();else {return ;

接受这个报文,如果带有ACK信息则更新对方已经确认了的ackno和对方当前的window_size

1 2 3 4 5 6 7 segment_received (seg);if (seg.header ().ack) {ack_received (seg.header ().ackno, seg.header ().win);

这部分是我认为Lab4里面在理解上较难的部分。其中,TCP的断开分为三种不同的情况:

由于RST标志导致的强制退出(unclean shutdown) 正常的通讯结束而导致的关闭(clean shutdown) 但是对于第二种情况,我们可以进一步分为两种情况:

首先是最简单的四次挥手报文:

Client发送完毕数据,告诉Server我结束(FIN)了Client客户端在给Server发送完毕了所有数据以后,主动发送FIN数据包,表示自己的数据已经发送完毕了。然后Server在收到Client的FIN报文并处理完毕以后则会返回一个FIN ACK报文,来告诉Client他发过来的数据已经在服务端被处理完成了。

Server也发送完毕了数据,告诉Client我结束(FIN)了Server也会给Client发送一个FIN的报文,同样等待Client那边确认,如果Client发送了确认报文来确认这个ACK,则代表客户端那边也处理完了,这个时候按理来说首先提出数据发送完毕的Client就可以断开链接了。

但是,服务端有可能收不到 这最后一个ACK确认报文,从而导致自己一直在等待客户端向自己发送ACK确认报文。

为了避免这种情况,最简单的处理方法就是让Client给Server发送了FIN ACK报文以后不要急着断开连接,而是设置一个计时器,等待看看Server会不会重传FIN报文。

如果重传了FIN则代表Server并没有收到先前发送的FIN ACK,这个时候Client就需要重新发送一个ACK回去,告知Server可以断开连接了。

如果超过了计时器的时间,Client也没有收到Server的重传报文,那么我们就假设Server已经收到了FIN ACK,并且已经关闭了他那边的连接,这个时候Client就可以断开连接了。而这段计时器的等待时间,就是实验中的linger_time = 10 *_cfg.rt_timeout,这个时间往往是比Server超时重传的时间大很多的,也就留给了Server足够多的时间来重传FIN报文。

服务端这边就很简单了,在发送完自己的FIN之后,只需要正常等待Client的ACK确认报文,如果没有等到则重传FIN,如果等到了则直接断开连接。

知道了上面的区分以后,我们实现起来就很简单了,只需要通过添加一个变量_linger_after_streams_finish来判断到底是对方先结束还是自己先结束。如果是对方先结束,则我们不需要等待linger_time,在后面收到了FIN报文以后直接断开连接即可。否则则需要在后面tick()函数的部分添加超时断开连接的逻辑。

1 2 3 4 5 6 7 8 9 10 11 12 if (_receiver.stream_out ().eof () && not _sender.stream_in ().eof ()) {false ;if (_sender.stream_in ().eof () && bytes_in_flight () == 0 && not _linger_after_streams_finish) {false ;

这部分逻辑就很简单了,如果在接受了对方传来的有序列号消耗数据包以后,我们并没有数据要传输(即无法告知对方我们接受到了数据),那么我们就需要单独传输一个ACK数据包给对方,告知我们已经接收到了对方的数据。(如果对方发送给我们的是一个ACK数据包,我们则不需要回复,也就是收到了占用序号为零的包)

1 2 3 4 if (_sender.segments_out ().empty () &&length_in_sequence_space () || seg.header ().seqno != _receiver.ackno ())) {send_empty_segment ();

其中seg.header().seqno != _receiver.ackno()代表的是一种特殊情况,在TCP连接中,有的时候为了确认当前连接是否依旧有效,对方有可能会随机发送一个错误的序列号给我们,这个时候我们就需要回复一个ACK报文给对方,以此告知对方这个连接依旧是有效的,同时也可以让对方更新我们的窗口大小。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 void TCPConnection::segment_received (const TCPSegment &seg) 0 ;if (seg.header ().rst) {stream_out ().set_error ();stream_in ().set_error ();false ;return ;if (not _receiver.ackno ().has_value ()) {if (seg.header ().syn) {fill_window ();else {return ;segment_received (seg);if (seg.header ().ack) {ack_received (seg.header ().ackno, seg.header ().win);if (_receiver.stream_out ().eof () && not _sender.stream_in ().eof ()) {false ;if (_sender.stream_in ().eof () && bytes_in_flight () == 0 && not _linger_after_streams_finish) {false ;if (_sender.segments_out ().empty () && (seg.length_in_sequence_space () || seg.header ().seqno != _receiver.ackno ())) {send_empty_segment ();

另外一个需要注意的函数就是tick()函数了。其实这一部分的重要也主要是连带了前面接受报文部分的关闭连接,主要要注意的就是添加一个对linger_time的判断。整个tick()函数的代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 void TCPConnection::tick (const size_t ms_since_last_tick) tick (ms_since_last_tick);if (_sender.consecutive_retransmissions () > TCPConfig::MAX_RETX_ATTEMPTS) {return ;if (time_since_last_segment_received () >= _linger_time && _sender.stream_in ().eof () &&stream_out ().input_ended ()) {false ;

Lab4实验主要的难点感觉还是在即使跑通了前面大部分的基本测试,也还是有可能因为Lab2和Lab3里面的疏忽,而导致后面模拟真实通讯的时候很容易难以下手。但是在掌握了Wireshark抓包一类的工具用法以后还是很容易发现问题所在并加以纠正的。

比如我在Lab3中,对于TCPSender在填充窗口大小的时候,一开始并不是设置了一个额外的变量fill_space来控制可以发送的空闲空间的大小,而是直接使用了ack_received方法中收到的最新窗口大小,忽略了bytes_in_flight()也需要考虑在窗口占用里面的问题。在使用Wireshark抓包的时候就明显发现了发送数据包的序号要远超于接收方的确认序号

而这个问题也在我通过修改Lab3对应空闲窗口大小的逻辑之后得到了解决。

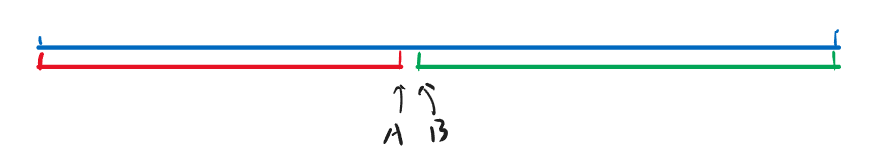

我还遇到过的第二个问题就是在小窗口的情况下,没有正确处理链接的关闭。在通过Wireshark抓包以后可以看到

在发送方还没有给接收方发送完所有数据的时候,接收方就提前终止了自己的连接,这个问题主要出在tick()函数里面关于linger_time的逻辑错误,我并没有等到接收方接受到EOF就直接关闭了链接。错误代码如下:

1 2 3 if (time_since_last_segment_received () >= _linger_time && _sender.stream_in ().eof ()) {false ;

修改后的代码如下:

1 2 3 4 if (time_since_last_segment_received() >= _linger_time && _sender.stream_in().eof()+ && _receiver.stream_out().input_ended()) {

整个Lab4的代码可以在Github的仓库查看:

tcp_connection.cc tcp_connection.hh

]]>

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ 使用Yadm管理Linux配置文件

+ /p/4457ea2b.html

+

+ 今年暑假看Missing-course的时候开始意识到备份Linux配置文件的重要性,以后即使切换机器也可以很容易的恢复自己喜欢的编程环境。在简单搜索了几个方式以后,决定使用yadm作为管理工具,并且写了一个模板,便于分享和使用。该仓库的主要用途为使用yadm作为管理工具,通过Github来同步自己的Dotfiles

先在自己当前环境下安装yadm,具体安装说明参照Installation

通过Use this template或者下载源码的方式,创建并上传到自己的一个仓库中,最好是Private类型

在本身没有经过配置Dotfiles的环境下(或提前备份好自己的Dotfiles)输入以下指令拉取模板到本地进行管理

1 yadm clone https://github.com/<your id>/<your repository> --bootstrap

在附带--boostrap的情况下执行完毕上述指令以后将会按默认模板文件使用git来对自己的Dotfiles进行管理

在clone仓库的时候如果附带了bootstrap将会自动执行以下三件事

在以 apt/yum/pacman 作为包管理器的情况下安装zsh vim tmux curl wget openssl 安装 oh-my-zsh,并以p10k为主题。安装zsh-autosuggestions,zsh-syntax-highlighting和zsh-proxy三个插件 切换 zsh 为当前用户的默认终端 配置了rust国内镜像 添加了transfer 用于分享文件(输入transfer /path/to/file即可) 使用pws作为powershell.exe的alias,便于wsl环境下使用powershell 启用了vi的normal模式,在输入命令的时候按Esc即可 配置默认使用~/.gitignore作为全局ignore`文件 在使用https时的验证交由.git-credentials文件纯文本保存密码(有风险,可加密) 对于类似.ssh/id_rsa或者.git-credentials文件可以通过yadm自带的encrypt工具进行加密,使用步骤如下

在.config/yadm/encrypt文件内写入需要加密的文件路径,支持正则匹配

假设在.ssh/目录下所有文件(例如config, id_rsa)都需要进行加密,则在.config/yadm/encrypt写入.ssh/*后输入以下指令(安装openssl为前提)

则会要求输入一个密码来进行加密

加密完则会在.local/share/yadm目录下产生一个archive作为加密打包后的文件,将该文件添加并上传到Github

虽然加密文件本身有一定安全性,但为了保险起见还是推荐使用Private仓库来存储自己的Dotfiles

1 2 3 yadm add ~/.local/share/yadm/archive

原本的文件此时将会依旧本地存在于(例如config, id_rsa),但不需要上传到Github当中

在下次重装系统/更换环境的时候,如果需要通过yadm对环境进行复原并解密加密文件,则只需要输入以下指令

就会将加密打包的文件解密到对应的文件目录,保证一定的安全性

+

+

+

+

+ 小技巧

+

+

+

+

+

+

+ Linux

+

+ Yadm

+

+

+

+

+

+

+

+

+ CS144-Lab3 计算机网络:TCP Sender的实现

+ /p/73e1b791.html

+

+ 追踪Receiver返回的windows_size(可接受的剩余容量)和ackno(已经确认接收的字符位置) 只要数据来了就直接对数据进行封装并发送,只有在窗口被消耗为零的情况下才停止发送 将没有被acknowledge的数据包存储起来,在超时的时候进行发送 对于超时重传的时间判断,使用已经提供的tick()函数,每次调用的时候传入多少时间就消耗了多少时间 超时重传的默认基准值会以成员变量的形式在TCPSender中进行初始化 在TCPSegment中有一个_segments_out的成员,只需要向这个queue内push一个TCPSegment就相当于将这个数据段发送了 对于计时器的部分,为了方便抽象管理,我这里选择直接创建一个类来进行封装

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 class TCPTimer {private :size_t _tick_passed = 0 ; size_t _rto_timeout = 0 ; unsigned int _rto_count = 0 ; bool _is_running{false }; public :void reset (const uint16_t retx_timeout) 0 ;0 ;void run () true ; }void stop () false ; }bool is_running () const return _is_running; }unsigned int rto_count () const return _rto_count; }void slow_start () 2 ;void update (const size_t ms_since_last_tick) bool is_timeout () const return _is_running && _tick_passed >= _rto_timeout; }void restart () 0 ; }

在private的部分定义则如下:

1 2 3 4 5 6 7 8 9 10 11 size_t _ackno = 0 ;size_t _window_size = 1 ;

额外定义的函数主要作用为将已经封装好的TCP报文进行发送,如果在发送的时候检测到RTO重传计时器并没有工作,则发送的同时激活重传计时器。同时在发送了报文后对seqno序号进行消耗,移动_next_seqno指针

1 2 3 4 5 6 7 8 9 10 11 12 void TCPSender::_send_segment(const TCPSegment &seg) {const size_t seg_len = seg.length_in_sequence_space ();push (seg);push (seg);if (not _rto_timer.is_running ()) {run ();reset (_initial_retransmission_timeout);

对于需要封装的报文,大致可以分为三类,一类是最开始用于建立连接的SYN报文,一类是携带数据的PAYLOAD报文,最后一类是用于发送结束连接的挥手FIN报文。在该方法中主要的难点就是通过对目前已经确认的ackno和next_seqno等数据来判断当前需要封装的报文具体是哪一类,以及根据还未接收到的数据以及零窗口本身的机制来判断空闲的窗口大小

首先,为了防止出现对方当前空闲窗口已满,而sender就一直啥也不发的情况出现,因此在接受到的窗口大小是0的时候,要将其改为1,来避免零窗口堵塞。同时由于部分数据还在传输的路上,这一部分的数据也需要被减掉,从而得到最后的空闲大小fill_space。

1 2 size_t fill_space = _window_size ? _window_size : 1 ;bytes_in_flight ();

SYN报文的判断很简单,因为发送SYN的话无非是打开连接的建立者A自己,又或者是收到了A发来报文的B返回一个携带ACK的SYN报文进行确认。而对于A和B来说,由于SYN报文都是他们自己发送的第一个报文,因此在封装的过程中,他们的“下一个发送序列号”_next_seqno显而易见的应该为零。大致逻辑代码如下

1 2 header ().syn = (_next_seqno == 0 );

对于含有内容的报文,主要的工作就是对payload长度的合理切割,对此只需要在TCPConfig::MAX_PAYLOAD_SIZE和当前剩余``中取最小值并从_stream当中读入。

1 2 3 size_t segment_payload_size = min (TCPConfig::MAX_PAYLOAD_SIZE, fill_space);payload () = _stream.read (segment_payload_size);

在_stream发送完毕,并且被我方全部接受了的时候发送一个携带FIN的报文,告知对方我方已经发送完毕。由于FIN本身需要消耗一个序列号,因此发送前需检查当前数据段是否还有一个空位来放FIN

1 2 3 4 if (_stream.eof () && fill_space > section.length_in_sequence_space ()) {header ().fin = true ;

在标记完了FIN之后,如果这个报文依旧不占用序列号,则说明这个报文不是TCP Sender处理的部分;又或者此时在FIN已经发送的基础上,重复发送了一个FIN,这时多的FIN应该被抛弃

1 2 3 4 if (section.length_in_sequence_space () == 0 || _next_seqno == _stream.bytes_written () + 2 ) {return ;

最后总的代码如下 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 void TCPSender::fill_window () size_t fill_space = _window_size ? _window_size : 1 ;bytes_in_flight ();while (fill_space > 0 ) {header ().seqno = next_seqno ();header ().syn = (_next_seqno == 0 );size_t segment_payload_size = min (TCPConfig::MAX_PAYLOAD_SIZE, fill_space);payload () = _stream.read (segment_payload_size);if (_stream.eof () && fill_space > section.length_in_sequence_space ()) {header ().fin = true ;if (section.length_in_sequence_space () == 0 || _next_seqno == _stream.bytes_written () + 2 ) {return ;length_in_sequence_space ();

这个感觉可能是看起来最简单的一个函数了,因为用了_ackno来记录已经确认过的报文,同时_next_seqno又代表的是将要发送的数据流位置,因此只需要将_next_seqno - _ackno返回的就是正在发送中的数据长度了。(最开始想实现的时候还在考虑要不要在每次fill_window和ack_received的时候添加计数器。。)

1 uint64_t TCPSender::bytes_in_flight () const return _next_seqno - _ackno; }

确认报文主要需要的逻辑有以下四个部分:

只处理有效并且正确的ackno。如果ackno有效,记录ackno和window_size用以fill_window()来进行报文的封装 记录ack报文中包含的窗口大小 如果曾经的报文已经确认过,则报文已经送达,将送达的报文从缓冲区中弹出,如果所有的报文都被弹出了,则关闭RTO计时器 如果接受到了对方这时的窗口又有了空闲大小,则使用fill_window()来填充新的空报文 对于判断ackno是否是正确的ackno,只需要判断ackno是否处于已经记录的_ackno和_next_seqno之间,如果在这个区间之外,意味着要么是老的ackno,要么是确认了不存在的数据,需要进行短路丢弃,逻辑如下

1 2 3 4 5 uint64_t abs_ackno = unwrap (ackno, _isn, _next_seqno);if (abs_ackno < _ackno || abs_ackno > _next_seqno) {return ;

在接受到了窗口大小之后只需要直接将其记录

1 2

这部分都是属于对于超时重传的处理,其中主要需要实现的是对缓冲区确认后的报文进行弹出,同时弹出所有报文后取消对RTO的占用,初始化超时重传的等待时间并记录当前的时间。

其中弹出操作只有在_ackno确认的是第一个报文对应的seqno和length的时候才进行

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 bool has_reset = false ;while (not _cache.empty () &&front ().header ().seqno.raw_value () + _cache.front ().length_in_sequence_space () <= ackno.raw_value ()) {if (not has_reset) {reset (_initial_retransmission_timeout);true ;pop ();if (_cache.empty ()) {stop ();fill_window ();

最后总的代码如下 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 void TCPSender::ack_received (const WrappingInt32 ackno, const uint16_t window_size) uint64_t abs_ackno = unwrap (ackno, _isn, _next_seqno);if (abs_ackno < _ackno || abs_ackno > _next_seqno) {return ;bool has_reset = false ;while (not _cache.empty () &&front ().header ().seqno.raw_value () + _cache.front ().length_in_sequence_space () <= ackno.raw_value ()) {if (not has_reset) {reset (_initial_retransmission_timeout);true ;pop ();if (_cache.empty ()) {stop ();fill_window ();

该函数主要的作用是推动时间流动,并且判断是否触发超时重传,如果触发了超时重传首先将计时器更新到当前时间。然后当对方窗口不繁忙的情况下(window_size非零)触发了重传就把下次重传的等待时间翻倍,并且记录一次重连;如果对方窗口正处于繁忙期(window_size为零),则不翻倍连接时间。然后再将缓冲区内第一个发送的报文进行重新发送。代码如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 void TCPSender::tick (const size_t ms_since_last_tick) update (ms_since_last_tick);if ((not _rto_timer.is_timeout ())) {return ;if (_window_size != 0 ) {slow_start ();if (_rto_timer.rto_count () <= TCPConfig::MAX_RETX_ATTEMPTS) {push (_cache.front ());restart ();

这个函数就是直接返回次数的,直接返回_rto_timer.rto_count();的大小即可。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ CS144-Lab2 计算机网络:TCP Receiver的实现

+ /p/4e68707.html

+

+ 为了节省在TCP Header当中的空间,在StreamReassembler里面写的index虽然是一个uint64_t的类型,但是在实际的Header中是使用一个uint32_t的seqno来进行标记位置的。对于uint32_t的seqno和uint64_t的index的相互转换则是通过以4GiB (2^32 bytes)为一个长度进行取模来实现。

同时为了提高TCP本身的安全性,并且确保每次获得的segments数据段都是来自于本次连接的,因此提出了ISN(Initial Sequence Number)的概念,即本次链接是从序号为isn开始作为seqno进行通信,大于isn的seqno所代表的index是本次链接所需要的数据段,早于isn的seqno则是来自于上一次连接的老数据段,并不需要处理。

如果想要将uint32_t的seqno转为一个uint64_t则需要一个checkpoint作为定位,防止seqno被定位到错误的位置上。这个checkpoint在实现中就是最后一个重新组装后的字符位置

按lab2的原文:In your TCP implementation, you’ll use the index of the last reassembled byte as the checkpoint.

通过寻找距离checkpoint最近的seqno就可以定位到本来需要插入的seqno位置了

对于将uint32_t转为uint64_t的代码实现很简单,只需要将uint64_t的index加上isn的值之后对2^32进行取模就行了,具体代码实现如下

1 2 3 4 WrappingInt32 wrap (uint64_t n, WrappingInt32 isn) {uint64_t result = (n + isn.raw_value ()) % (static_cast <uint64_t >(UINT32_MAX) + 1 );return WrappingInt32 (static_cast <uint32_t >(result));

而对于将wrap后的seqno转回index,我直接通过类似分类讨论的枚举找到了四个临界点,只需要判断checkpoint相对于临界点的位置就可以得到答案。代码如下

1 2 3 4 5 6 7 8 9 10 11 12 13 uint64_t unwrap (WrappingInt32 n, WrappingInt32 isn, uint64_t checkpoint) const uint64_t L = (1ul << 32 );const uint64_t a = (checkpoint / L) * L - isn.raw_value () + n.raw_value ();if (checkpoint > a + (L * 3 ) / 2 ) {return a + 2 * L;else if (checkpoint > a + L / 2 ) {return a + L;else if (checkpoint < L) {return n.raw_value () < isn.raw_value () ? a + L : a;else {return checkpoint < a - L / 2 ? a - L : a;

通解推导 由以下公式

( i n d e x + i s n ) m o d L = s e q n o \left ( index+isn \right )\mod{ L } = seqno ( i n d e x + i s n ) m o d L = s e q n o

通过推导可以得到

i n d e x = s e q n o + k ∗ L − i s n index = seqno + k * L - isn i n d e x = s e q n o + k ∗ L − i s n

因此如果需要得到离checkpoint最近的index就只需要找到合适的k即可,在这里不妨设

m = c h e c k p o i n t / L m = checkpoint / L m = c h e c k p o i n t / L

取m作为一个附近值,通过画图可以知道,在一般情况下,答案一定在checkpoint附近的三个区间内

在这种情况下,checkpoint的前中后三个区间都存在,只要列举并讨论范围就很简单了

当seqno - isn为正数的时候,index可能的一个取值会落在第②个区间上,有

i n d e x ′ ′ = m ∗ L + s e q n o − i s n index'' = m * L + seqno - isn i n d e x ′ ′ = m ∗ L + s e q n o − i s n

此时第①区间和第③区间上的index可以分别表示为

i n d e x ′ = i n d e x ′ ′ − L i n d e x ′ ′ ′ = i n d e x ′ ′ + L index' = index'' - L \\\\index''' = index'' + L i n d e x ′ = i n d e x ′ ′ − L i n d e x ′ ′ ′ = i n d e x ′ ′ + L

对index'、index''和index'''的中间值进行判断,很容易得到以下规律

a = m ∗ L + s e q n o − i s n L = U I N T 32 _ M A X + 1 { c h e c k p o i n t < a − L / 2 index=a-L a − L / 2 ≤ c h e c k p o i n t < a + L / 2 index=a a + L / 2 ≤ c h e c k p o i n t index=a+L \begin{array}{l} a = m*L+seqno-isn \\\\ L = UINT32\_MAX+1 \\\\ \left \{\begin{matrix} checkpoint < a - L/2 & \text{index=a-L}\\\\ a-L/2\leq checkpoint< a+L/2 & \text{index=a}\\\\ a+L/2\leq checkpoint & \text{index=a+L}\end{matrix}\right.\end{array} a = m ∗ L + s e q n o − i s n L = U I N T 3 2 _ M A X + 1 ⎩ ⎪ ⎪ ⎪ ⎪ ⎨ ⎪ ⎪ ⎪ ⎪ ⎧ c h e c k p o i n t < a − L / 2 a − L / 2 ≤ c h e c k p o i n t < a + L / 2 a + L / 2 ≤ c h e c k p o i n t index=a-L index=a index=a+L

注:此时checkpoint一定小于 a+L,因为a+L属于第③区间,而checkpoint在第②区间内

此时因为是从m*L的位置向前移动,所以相比于上面,三个可能是答案的index的分布则改为了

i n d e x ′ = m ∗ L + s e q n o − i s n i n d e x ′ ′ = i n d e x ′ + L i n d e x ′ ′ ′ = i n d e x ′ + 2 ∗ L index' = m * L + seqno - isn\\index'' = index' + L\\index''' = index' + 2 * L i n d e x ′ = m ∗ L + s e q n o − i s n i n d e x ′ ′ = i n d e x ′ + L i n d e x ′ ′ ′ = i n d e x ′ + 2 ∗ L

所以很容易得到以下结果

a = m ∗ L + s e q n o − i s n L = U I N T 32 _ M A X + 1 { c h e c k p o i n t < a + L / 2 index=a a + L / 2 ≤ c h e c k p o i n t < a + ( 3 ∗ L ) / 2 index=a + L a + ( 3 ∗ L ) / 2 ≤ c h e c k p o i n t index=a+2*L \begin{array}{l} a = m*L+seqno-isn\\ L = UINT32\_MAX+1\\ \left \{\begin{matrix} checkpoint < a + L/2 & \text{index=a}\\ a+L/2\leq checkpoint< a+(3*L)/2 & \text{index=a + L}\\ a+(3*L)/2\leq checkpoint & \text{index=a+2*L}\end{matrix}\right.\end{array} a = m ∗ L + s e q n o − i s n L = U I N T 3 2 _ M A X + 1 ⎩ ⎨ ⎧ c h e c k p o i n t < a + L / 2 a + L / 2 ≤ c h e c k p o i n t < a + ( 3 ∗ L ) / 2 a + ( 3 ∗ L ) / 2 ≤ c h e c k p o i n t index=a index=a + L index=a+2*L

将以上两种规律整合,我们很容易可以得到以下通解

a = m ∗ L + s e q n o − i s n L = U I N T 32 _ M A X + 1 { c h e c k p o i n t < a − L / 2 index=a-L a − L / 2 ≤ c h e c k p o i n t < a + L / 2 index=a a + L / 2 ≤ c h e c k p o i n t < a + ( 3 ∗ L ) / 2 index=a + L a + ( 3 ∗ L ) / 2 ≤ c h e c k p o i n t index=a+2*L \begin{array}{l} a = m*L+seqno-isn\\ L = UINT32\_MAX+1\\ \left \{\begin{matrix} checkpoint < a - L/2 & \text{index=a-L}\\ a-L/2\leq checkpoint< a+L/2 & \text{index=a}\\ a+L/2\leq checkpoint< a+(3*L)/2 & \text{index=a + L}\\ a+(3*L)/2\leq checkpoint & \text{index=a+2*L}\end{matrix}\right.\end{array} a = m ∗ L + s e q n o − i s n L = U I N T 3 2 _ M A X + 1 ⎩ ⎪ ⎪ ⎨ ⎪ ⎪ ⎧ c h e c k p o i n t < a − L / 2 a − L / 2 ≤ c h e c k p o i n t < a + L / 2 a + L / 2 ≤ c h e c k p o i n t < a + ( 3 ∗ L ) / 2 a + ( 3 ∗ L ) / 2 ≤ c h e c k p o i n t index=a-L index=a index=a + L index=a+2*L

特殊情况 在checkpoint < L的时候,通解中对于a - L的一部分(即checkpoint < a + L)就不适用了,不过分析起来也很简单,由于有

( i n d e x + i s n ) m o d L = s e q n o \left ( index+isn \right )\mod{ L } = seqno ( i n d e x + i s n ) m o d L = s e q n o

所以当seqno小于isn的时候,答案一定在下一个区间,因此答案即L - isn + seqno,当seqno大于isn且checkpoint < a + L,所以答案一定为a

所以就可以得到上述代码了。

这部分代码逻辑完成的是tcp握手中对于tcp段的接受处理。

我自己增加的私有成员和用途大致为:

_is_syn: 判断链接是否建立_isn: 存入第一次建立连接时接受的seqno来初始化_is_fin: 用于判断结束输入的报文是否传入对于ackno和checkpoint的实现机制是:

ackno: 本质上就是返回已经整合好的数据量,也就是bytes_stream的bytes_written(),同时建立连接后一定存在syn所以可以直接加一,之后只需要判断fin是否到达并且整合完毕,然后再次加一即可。checkpoint: 和ackno差别不大,只需要直接返回已经写入完成的字符个数即可知道了上述几个逻辑以后就只需要通过调整简单的逻辑flag加上lab1里面的push_substring来对payload()进行整合就可以通过了。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 void TCPReceiver::segment_received (const TCPSegment &seg) if ((_is_syn == 0 ) && seg.header ().syn) {1 ;header ().seqno;else if (_is_syn == 0 ) {return ;const uint64_t checkpoint = _reassembler.stream_out ().bytes_written () + 1 ;uint64_t stream_index = unwrap (seg.header ().seqno, _isn, checkpoint) - 1 + seg.header ().syn;push_substring (seg.payload ().copy (), stream_index, seg.header ().fin);if (seg.header ().fin) {1 ;optional<WrappingInt32> TCPReceiver::ackno () const {stream_out ().bytes_written ();if ((_is_fin != 0 ) && _reassembler.unassembled_bytes () == 0 ) {return _is_syn ? optional <WrappingInt32>(result) : nullopt ;size_t TCPReceiver::window_size () const return _capacity - _reassembler.stream_out ().buffer_size (); }

这里有一个让我感觉很疑惑的点就是在单元测试中存在两种测试样例,这里做个记录,后面如果知道了原因就来解决一下

存在同时携带SYN和FIN报文,按照正常的TCP握手感觉这是不合理的 在接受SYN的同时会接受一部分的Data进行处理,按正常的TCP也是不会这么做的

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ CS144-Lab1 计算机网络:字节流重组器

+ /p/aeda2510.html

+

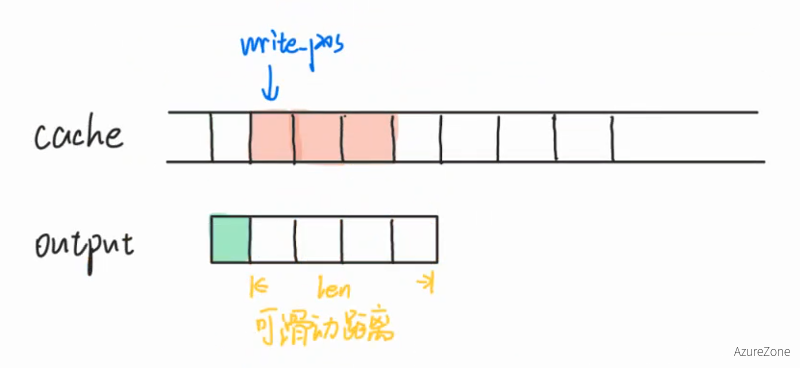

+ 这个方案是采用了一个无限长的字符串cache,所有的TCP段中的部分数据先寄存在cache当中。之后通过创建一个在cache上滑动的写入位指针write_p来将能够顺序写入的内容写入_output当中,其中write_p每次滑动的距离len受限于_output还剩下的可容纳空间。

添加的私有成员:

1 2 3 4 5 6 7 8 size_t write_p;size_t end_p;

对于push_string方法的实现:

检查传入的index是否在可写入范围,如果超出可写入范围则直接退出,保证程序的鲁棒性

因为写入的数据长度不能超过capacity,因此需要将扩容的长度设置为index + data.length()和write_p + _output.remaining_capacity()中较小的那个

将传入的数据(包括可能超过范围的部分)写入cache中,同时将dirty_check中对应的位置标记为1

将cache的长度缩回到正确扩容后应该的长度,这样可以将多余的内容丢弃

检查write_p的位置上是否有数据可以被写入,如果有则通过滑动len来将内容写入_output,否则跳过

检查write_p和end_p是否相同,如果相同则代表写入结束,调用_output.end_input()

具体代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 void StreamReassembler::push_substring (const string &data, const size_t index, const bool eof) size_t extend_size = index + data.length ();if (eof) {if (extend_size > cache.length ()) {resize (extend_size);resize (extend_size);replace (index, data.length (), data);replace (index, data.length (), data.length (), '1' );if (expand_size > cache_raw_length) {resize (expand_size);resize (expand_size);if (dirty_check[write_p]) {size_t len = 0 ;size_t output_remaining = _output.remaining_capacity ();while (dirty_check[write_p + len] && len < output_remaining) {write (cache.substr (write_p, len));if (write_p == end_p) {end_input ();

对于没有统计的字符数量,直接使用一个循环进行统计即可

1 2 3 4 5 6 7 8 9 size_t StreamReassembler::unassembled_bytes () const size_t n = write_p;for (size_t i = write_p; n != cache.length () && not dirty_check[i]; i++) {return cache.length () - n;

对于判断缓冲区是否使用完毕则是

1 2 bool StreamReassembler::empty () const return _output.eof () && not unassembled_bytes (); }

使用上面这种写法的话虽然可以达到100% tests passed,并且时间也都能控制在0.5s以内,但是在复习了真实情况下的重组过程发现这个思路存在一些BUG是测试案例没有检测出来的。

以如下的test为例

1 2 3 4 5 6 7 8 9 10 {6 };execute (SubmitSegment{"defg" , 3 });execute (BytesAssembled (0 ));execute (SubmitSegment{"abc" , 0 });execute (BytesAvailable ("abcdef" ));execute (BytesAssembled (6 ));execute (SubmitSegment{"kmg" , 7 });execute (BytesAvailable ("" ));

运行后可以发现有报错

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 Test Failure on expectation:

可以发现,本来在传入第一个defg的时候,字符g应该因为超出capacity而被抛弃,但是是将并没有,导致g停留在了index为6的位置上。读取了_output的所有内容之后,_output的窗口应该是从index为6的位置上开始准备写入,但是由于这个位置上的g在上一个窗口期中并没有被抛弃,结果导致了index为7的kmg写入的时候,连带前面存在的g一起将gkmg写入了_output的窗口当中,从而出现了以下报错。

The reassembler was expected to have 0 bytes available, but there were 4

同时对于EOF的位置判断也有类似的BUG,测试样例如下

1 2 3 4 5 6 7 8 9 10 11 {6 };execute (SubmitSegment{"defx" , 3 }.with_eof (true ));execute (BytesAssembled (0 ));execute (SubmitSegment{"abc" , 0 });execute (BytesAvailable ("abcdef" ));execute (BytesAssembled (6 ));execute (SubmitSegment{"g" , 6 });execute (BytesAvailable ("g" ));execute (NotAtEof{});

运行后得到如下结果

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 Test Failure on expectation:

本来在第一个操作的时候作为eof的x应该是被抛弃掉并不读取的,但是在最后这个位置的eof_p还是触发了EOF判断,导致产生了不应该出现的EOF。

本质的问题就是没有丢弃掉unacceptable的字节,这里采取了一个比较省事但是很不优雅的操作,我是选择在最后扩容后重新再用resize()函数将不需要的那部分丢弃掉,来达到限制容量的目的,最后修正完毕的实现如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 void StreamReassembler::push_substring (const string &data, const size_t index, const bool eof) bool eof_flag = false ;size_t expand_size = index + data.length ();if (index > write_p + _output.remaining_capacity ()) {return ;if (index + data.length () <= write_p + _output.remaining_capacity ()) {true ;length ();else {remaining_capacity ();if (eof && eof_flag) {const size_t cache_raw_length = cache.length ();if (expand_size > cache_raw_length) {resize (expand_size);resize (expand_size);replace (index, data.length (), data);replace (index, data.length (), data.length (), '1' );if (expand_size > cache_raw_length) {resize (expand_size);resize (expand_size);if (dirty_check[write_p]) {size_t len = 0 ;size_t output_remaining = _output.remaining_capacity ();while (dirty_check[write_p + len] && len < output_remaining) {write (cache.substr (write_p, len));if (write_p == end_p) {end_input ();

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ CS144-Lab0 计算机网络:流的输入和读出

+ /p/2ca0860a.html

+

+ lab0前后分为两个较为简单的小任务,第一个任务是写一个类似telnet中通信的webget小应用,第二个任务是实现一个简单的ByteStream的类,只需要在单线程的情况下能正常运行即可

第一个任务的参考主要是从项目文件本身的doctests开始着手,其中在提示中已经说了我们将会使用到TCPSocket和Address,在对应的doctests/socket_example_2.cc和doctests/address_example_1.cc中,我们可以得到对于他们的使用例子,只需要创建一个以目标Address初始化并连接的TCPSocket,然后以这个socket向目标服务器发送类似telnet的请求即可获得我们需要的内容

1 2 3 4 5 TCPSocket socket;connect (Address (host, "http" ));write ("GET " + path + " HTTP/1.1\r\n" );write ("Host: " + host + "\r\n" );write ("Connection: close\r\n\r\n" );

由于最后在输入完Connection: close之后,我们本来也要输入一个回车将请求发送,因此在这里需要两个换行符

在处理socket.read()的时候,起初没有仔细考虑pdf中提到的a single call to read is not enough的具体含义,以为是首先会接受所有的文本信息,然后对于结果需要将最后的EOF也打印出来,所以第一次写的时候只是简单的调用了两次read()

1 cout << socket.read () << socket.read ();

然而在make check_webget的时候并没有通过,为了找到问题所在,首先找到check_webget的脚本,发现测试的内容为对cs144.keithw.org下的接口/nph-hasher/xyzzy发送请求,并获取最后一行的内容,而这行内容应该是一串正确的HASH。但是在这个时候尝试以上文的方式运行webget的时候则发现输出的只有以下两行

1 2 HTTP/1.1 200 OK

但是通过telnet的情况下,正常的输入应该是以下的内容

1 2 3 4 HTTP/1.1 200 OK

这个时候就懂了多次调用read()的含义直到遇到eof的含义应该是一直读取到所有缓冲区内的内容都被读取完毕,将代码修改如下就可以通过测试了

1 2 3 4 5 6 7 8 9 10 11 void get_URL (const string &host, const string &path) connect (Address (host, "http" ));write ("GET " + path + " HTTP/1.1\r\n" );write ("Host: " + host + "\r\n" );write ("Connection: close\r\n\r\n" );while (!socket.eof ()) {read ();close ();

第二个任务主要是要我们自己根据头文件的内容来实现一个简单的ByteStream,并且只需要考虑单线程的情况,不用考虑并发等情况。

最后完成的答案先直接贴上来,这块难度也不会很大,在写的时候先大致按要求写出一个逻辑,即使不是很清楚具体实现对不对也问题不大,只需要通过调试逐步修改即可

首先添加的成员变量如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 class ByteStream {private :const size_t buffer_max_size;bool is_input_end = false ;size_t write_count, read_count;bool _error{}; public :

最后接口的实现如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 ByteStream::ByteStream (const size_t capacity) : buffer_max_size (capacity), buffer (), write_count (0 ), read_count (0 ) {}size_t ByteStream::write (const string &data) size_t cnt = min (remaining_capacity (), data.length ());substr (0 , cnt);return cnt;string ByteStream::peek_output (const size_t len) const { return buffer.substr (0 , len); }void ByteStream::pop_output (const size_t len) erase (0 , len);std::string ByteStream::read (const size_t len) {substr (0 , len);pop_output (len);return output;void ByteStream::end_input () true ; }bool ByteStream::input_ended () const return is_input_end; }size_t ByteStream::buffer_size () const return buffer.length (); }bool ByteStream::buffer_empty () const return buffer.empty (); }bool ByteStream::eof () const return input_ended () && buffer.empty (); }size_t ByteStream::bytes_written () const return write_count; }size_t ByteStream::bytes_read () const return read_count; }size_t ByteStream::remaining_capacity () const return buffer_max_size - buffer.length (); }

接口的逻辑实现都不难,不过写这个lab的时候的第一次在vscode的环境下使用cmake来进行调试,在这里简单记录一下调试的步骤和需求。

相关code插件 : CMake, CMake Tools, C/C++(Cpptools)

在这里以write()函数中缺少了write_count += cnt这一行为例,使用make check_lab0可以发现在最后有报错

1 2 3 4 5 6 7 8 9 10 11 12 13 14 56% tests passed, 4 tests failed out of 9

此时可以将注意力先集中在最上面的t_byte_stream_one_write上,cmake中将byte_stream_one_write作为target编译并运行,可以得到以下报错

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 Test Failure on expectation:

从这里可以知道是测试"write-end-pop"中的第五个执行中,bytes_written并没有返回预期希望的数字3。因此只需要在tests/byte_stream_one_write.cc内"write-end-pop"的test.execute(BytesWritten{3});的位置打上断点,然后直接使用vscode下方栏中cmake的debug图标(需要安装C/C++插件才可以使用快速调试,具体参考这里 )就可以逐步找到自己逻辑中出错的地方并修改即可。

热身的两个lab提供的成就感很足,希望自己能尽快完成下一个lab。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ cs144

+

+ network

+

+

+

+

+

+

+

+

+ ArchWSL安装及基础配置

+ /p/cdfd3649.html

+

+ 在Windows上安装ArchWSL直接使用scoop来安装是比较便捷的一种方案,具体如何在Windows上配置·scoop`可以参考这篇教程:

在配置好了scoop以后,首先通过以下指令安装ArchWSL

只要按正常流程,按win+s,通过Windows搜索找“Turn Windows features on or off”或“启用或关闭Windows功能”,然后在里面将 Virtual Machine Platform 和 Windows Subsystem for Linux 勾选上,重启电脑即可。

重启电脑之后只需要在命令行中输入arch即可启动,如果出现报错或无法使用 WSL2 的情况可以通过搜索引擎或在这里下载Linux内核更新包 来解决

在/etc/pacman.d/mirrorlist内已经有Arch预置好的部分国内镜像源,我们只需要将我们对应需要的镜像前面的注释取消即可使用。

或者也可以通过下面这个脚本来一键启用所有China部分的镜像源

1 sed -E '/China/,/##/s/^#S(.)/S\1/g' /etc/pacman.d/mirrorlist~ > /etc/pacman.d/mirrorlist

通过以下指令将archlinuxcn相关源直接写入/etc/pacman.conf当中

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 cat >> /etc/pacman.conf << EOF # 国内archlinuxcn镜像源 [archlinuxcn] Server = https://mirrors.aliyun.com/archlinuxcn/\$arch Server = https://repo.archlinuxcn.org/\$arch Server = https://mirrors.bfsu.edu.cn/archlinuxcn/\$arch Server = https://mirrors.cloud.tencent.com/archlinuxcn/\$arch Server = https://mirrors.163.com/archlinux-cn/\$arch Server = https://repo.huaweicloud.com/archlinuxcn/\$arch Server = https://mirrors.zju.edu.cn/archlinuxcn/\$arch Server = https://mirrors.cqupt.edu.cn/archlinuxcn/\$arch Server = https://mirrors.sjtug.sjtu.edu.cn/archlinux-cn/\$arch Server = https://mirrors.tuna.tsinghua.edu.cn/archlinuxcn/\$arch EOF

首先通过以下指令,来更新软件源、安装archlinuxcn证书、yay和部分基础工具(其中yadm是一个用来备份dotfiles的工具,用于恢复自己常用的Linux环境下的自定义文件)

1 2 pacman -Syyu --noconfirm ;

创建用户 (注意替换下文的用户名)

1 useradd -m -G wheel -s /bin/zsh 用户名

将wheel组内的成员给予sudo的权限

如果希望安全考虑,在sudo之前要输入密码的话,可以输入下面的指令来配置visudo

1 echo '%wheel ALL=(ALL:ALL) ALL' | sudo EDITOR='tee -a' visudo

如果偷懒,不希望每次都输入密码的话可以用下面的指令来配置visudo

1 echo '%wheel ALL=(ALL:ALL) NOPASSWD: ALL' | sudo EDITOR='tee -a' visudo

2.5. 以上所有操作全部可以自动完成,只需要将以下脚本内的用户名替换为自己的用户名即可(默认sudo不需要密码)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 sed -E '/China/,/##/s/^#S(.)/S\1/g' /etc/pacman.d/mirrorlist~ > /etc/pacman.d/mirrorlistcat >> /etc/pacman.conf << EOF # 国内archlinuxcn镜像源 [archlinuxcn] Server = https://mirrors.aliyun.com/archlinuxcn/\$arch Server = https://repo.archlinuxcn.org/\$arch Server = https://mirrors.bfsu.edu.cn/archlinuxcn/\$arch Server = https://mirrors.cloud.tencent.com/archlinuxcn/\$arch Server = https://mirrors.163.com/archlinux-cn/\$arch Server = https://repo.huaweicloud.com/archlinuxcn/\$arch Server = https://mirrors.zju.edu.cn/archlinuxcn/\$arch Server = https://mirrors.cqupt.edu.cn/archlinuxcn/\$arch Server = https://mirrors.sjtug.sjtu.edu.cn/archlinux-cn/\$arch Server = https://mirrors.tuna.tsinghua.edu.cn/archlinuxcn/\$arch EOF echo '%wheel ALL=(ALL:ALL) NOPASSWD: ALL' | sudo EDITOR='tee -a' visudo

给root用户和自定义用户设置密码(自行操作)

修改root用户密码

修改自定义用户密码

(可选)切换到自定义用户下并配置oh-my-zsh

通过以下指令切换用户

配置zsh为oh-my-zsh可以参考这篇教程(Ubuntu配置和Arch大同小异,可以选择性参考)

Ubuntu下安装Oh My Zsh引导

如果希望设置ArchWSL为WSL的默认发行版,并将刚刚自己创建的用户作为默认用户的话只需要分别在Powershell下执行这两条指令

1 Arch config --default-user 用户名

+

+ 安装引导

+

+

+

+

+

+

+ WSL

+

+ Arch

+

+

+

+

+

+

+

+

+ Shell:管道符与重定向

+ /p/db6cc46f.html

+

+ 到目前位置自己还没专门花时间研究过Linux上那些日日都在用的工具(如Shell和Vim)他们本来的用法和含义,本来觉得没必要,不过在看了missing-semester之后顿时感觉效率提高了不少。因此做一个笔记,把一些很实用但是自己并不会去关注的简单用法给记录一下。

在使用最基础的bash作为命令行的时候,常常能发现用户后面有的时候是$二有的时候是#

1 2 [halc@Zephyrus blog]$ su

这里$代表了当前用户为普通用户,而#的含义则代表当前是在root用户下

在shell程序中,程序的执行主要分为 输入流 和 输出流 两种不同的流,程序会从输入流中读取信息,然后在通过处理之后打印到输出流当中。

以cat为例,其作用为将一个文件的内容打印到输出流当中,通过使用 > file 和 < file 来对流进行重定向,可以覆写或者创建对应内容的文件

1 2 3 4 5 6 7 8 # 将我存于github的pubkey打印输出成id_rsa.pub文件 # 将id_rsa.pub的内容重定向 **追加** 到authorized_keys当中 # 将id_rsa.pub的内容先重定向给cat ,再由cat 输出到pubkey当中

拓展补充 1:所有的Linux进程都包含3个文件描述符,分别是 标准输入 ,标准输出 和 错误输出 。<或<<来操作>或>>来操作2>或2>>来操作

补充拓展 2:>/dev/null 2>&1和2>&1 >/dev/null的区别

对于>/dev/null 2>&1是指先将标准输出指向黑洞设备,然后再将错误输出指向标准输出的指向内容(此时是黑洞),因此标准输出和错误输出都将不输出 对于2>&1 >/dev/null是先将错误输出指向标准输出(此时为屏幕),然后将标准输出指向黑洞,因此此时错误输出将打印到屏幕,而标准输出将不输出 1 2 # 运行example.sh,并将标准输出重定向至stdout.log,将错误输出重定向至stderr.log

以一个简单的test.cpp程序为例

1 2 3 4 5 6 7 8 #include <iostream> using namespace std;int main () "This is stand output" << endl;"This is error output" << endl;return 0 ;

通过编译并重定向运行

1 2 3 4 5 6 7 8 [halc@Zephyrus ~]$ g++ test.cpp -o test

如果希望将对应的文件描述符关闭的话有两种方法

1 2 3 4 # $-指关闭对应的文件操作符 # /dev/null为linux内的黑洞设备

对于>操作符,首先会判断右侧的文件是否存在,如果存在就删除再创建,如果不存在则直接创建,并且右侧的文件一定会置空。 一条命令执行前会检查0,1,2三个I/O设备是否正常,如果异常则不会进行命令执行 如果想要将内容输出重定向到某个文件,以cat举例有两种不同的办法

1 2 3 4 # 将read.md的内容重定向至write.md # "<< EOF" 指对流进行重定向输入,直到遇到"EOF" (可修改)作为末尾则结束

摘自:How does “<<” operator work in linux shell?

<< 操作符主要有以下三个操作逻辑

首先执行该操作符左侧的程序,在上面的例子中就是cat 抓取用户包括换行等所有的输入内容,直到输入的内容为用户指定的EOF结尾内容(在上面的例子中则恰好也是EOF)则停止 将所有除了EOF的内容都作为(1)程序的标准输入执行 实例:通过bash脚本创建一个test.cpp文件

1 2 3 4 5 6 7 8 9 10 11 #!/bin/bash cat > test.cpp << EOF #include<iostream> using namespace std; int main() { cout << "This is stand output" << endl; cerr << "This is error output" << endl; return 0; } EOF

1、文件类型上

2、管道触发两个子进程执行 “|” 两边的程序,而重定向是在一个进程内执行。

1 2 3 4 5 $ (sed -n '1,$p' | grep -n 'output' ) < test.cpp # 等价于 sed -n '1,$p' < test.cpp | grep -n 'output' # 对于管道运算符,如果希望将`test.cpp`传递给前面的第一个可执行文件`sed`,则需要使用单括号将整个管道传输看作一个单独的指令,否则`test.cpp`将传入`grep`内

由于标准输入和标准输出在管道运算符中的重定向是发生在"内容输出"之前的,因此可以通过重定向来修改管道中传输的数据

Because pipeline assignment of standard input or standard output or both takes place before redirection, it can be modified by redirection.

举个例子来说,本来管道传输默认只传输标准输出的内容,并不会传输错误输出

1 [halc@Zephyrus ~]$ command1 2>&1 | command2

通过上面的指令,首先command1的 错误输出 会在执行前被重定向至标准输入,然后command1执行,将 标准输出 和 错误输出 一并通过管道进行传输,作为command2的标准输入

1 2 3 4 # 首先将test.sh的内容通过cat 打印到标准输出, 然后管道传输该输出给tee , # 在tee 执行之前通过&>将tee 的标准输入和错误输出都重定向至/dev/null中, # 然后执行tee 将管道获取的内容写入text.txt,并且将相同的内容写入null设备当中

> 输出重定向,往往在命令最右边(也可以用到命令中间),接收左边命令的输出结果,重定向到指定文件。

1 2 3 4 5 6 7 8 # 如果管道符左侧的程序已经将标准重定向指向了其他文件,那么在bash中管道传输的数据将为空 # 此时无输出 # 但是log 内应该是有内容匹配的

在自己实验的时候发现zsh下即使重定向了标准输出和错误输出依旧可以通过管道读取内容,这主要是zsh有一个可以将输出重定向给多个文件的特性,对于管道也会进行二次传递

参考 Redirection and pipe behavior in bash vs. zsh

Read the MULTIOS documentation in the zshmisc man page. It’s a feature of zsh which causes it to redirect the output to multiple files at the same time, and it can also be a pipe.

具体举例

上面这个命令在bash当中只有文件a会有内容,而b中并没有获取到标准输出。但是在zsh下执行上面的命令,则a和b中都会拥有相同的输出内容。

]]>

+

+ 知识记录

+

+

+

+

+

+

+ missing-semester

+

+ shell

+

+

+

+

+

+

+

+

+ 快速部署rclone为services

+ /p/bbde595d.html

+

+ 在Linux上安装rclone可以直接使用默认发行版仓库的版本,也可以官方脚本安装

1 curl https://rclone.org/install.sh | sudo bash

安装完成了之后通过输入以下指令可以在交互式页面当中添加、修改或删除连接信息

在配置完成之后,如果需要将rclone的内容挂载到本地,执行类似以下格式的指令

1 rclone mount remote_name:path/to/directory path/to/mount_point

其中可以添加以下参数来对本地的文件进行缓存设置

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 --transfers:该参数控制最大同时传输任务数量,如果你cpu性能差,建议调低,但太低可能会影响多个文档同时传输的速度。

在挂载的时候可以添加--deamon参数来让rclone后台临时挂载,如果要取消挂载则输入以下指令

1 fusermount -u path/to/mount_point

如果需要配置开机自启动挂载对应的Rclone服务,只需要创建以下文件(以onedrive为例,参数和名字可自定义):~/.config/systemd/user/rclone-onedrive.service

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 [Unit]# 挂载在当前用户的~目录的OneDrive文件夹内,需要提前创建好~/OneDrive # Make sure we have network enabled # 启用vfs模式,将onedrive挂载给/home/xxx/OneDrive文件夹 # 取消挂载 # Restart the service whenever rclone exists with non-zero exit code # Autostart after reboot

写入完成之后,通过执行以下两个指令在当前用户下生效该服务

1 2 systemctl --user daemon-reload

+

+ 小技巧

+

+

+

+

+

+

+ rclone

+

+

+

+

+

+

+

+

+ 总结:2022年5月

+ /p/795cfa1d.html

+

+ 这个月算是找回了感觉,还算充实。这个月应该算是最平常的一个月了,整个人谈不上有动力,也谈不上完全摆烂。月初刚开始的时候把OSTEP上操作系统虚拟化的部分基本上写完了,然后就开始关注开源之夏项目申请相关的内容。在之前某个学长的推荐下看过一篇xmake-clangd配置vscode写cpp环境的知乎的帖子,当时对于cpp编译和链接相关的知识还完全没有概念,在开源之夏的时候模模糊糊搜了下xmake发现居然有项目能申请,就怂恿和gofaquan一起报了相关的项目。在五月底到六月初花了大概一百多RMB学习了cpp常见的一些项目管理会遇到的问题,感觉还蛮值的,希望最后项目申请能成功中标,给暑假的自己找点事情做。

学校也快到期末了,这学期的大作业还算应付的过来,大部分大作业都能组队解决,不能组队的也不算麻烦,基本上1-2天的时间也都能搞定,希望下个月的期末考试能一切顺利,别挂科。

这个月主要的学习部分应该也就是上半个月和六月份初了。五月中旬的时候学校终于有了解封相关的信息,于是开始到处想办法出去吃,报复性消费了好几顿过度饮食,体重直接涨了十多斤。现在期末考试临近,也没有什么减肥的想法,打算在考试前可能就通过不断的摄入碳水来缓解压力了,减肥啥的还是等考完期末考试再说了XD。

然后就是每次考试前都日常想要有的报复性消费。这学期把自己之前Niz那个108键的键盘换成了68配位的。目前过渡到日常使用已经没什么问题了,后面看看能不能开发点新功能,再提高提高效率(其实就是差生文具多 )

希望期末考试算顺利复习完,不挂科 能熟悉xmake要导入的包相关源码 在期末考试结束以前是不指望有什么生活质量了,只能寄托希望给暑假的自己了

减肥!至少恢复160-以下 调整自己的作息,打破在家必摆烂的心态(感觉不太可能)

+

+

+

+

+ 个人总结

+

+

+

+

+

+

+ 总结

+

+

+

+

+

+

+

+

+ OSTEP:分页的计算

+ /p/c1ec22c4.html

+

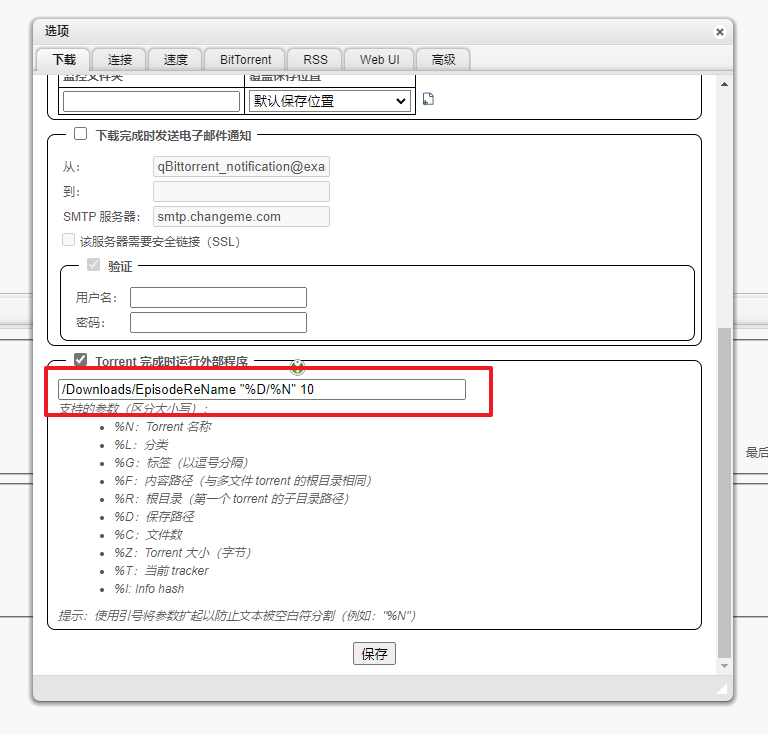

+ 对于线性页表,只要知道第一个Page的地址,存于寄存器当中,就可以通过这个地址依次陆续推算下一个或后面任意一个有效的地址范围。对于多级页表,通过多次搜索,依旧可以在只有最初的页表的地址的情况下,通过多次的偏移查询来定位到最后需要的特定地址。

这里取例子说明算法,具体答案通过-c参数可直接输出

这里以seed为0的时候为例

首先,在README.md中可以得到以下信息

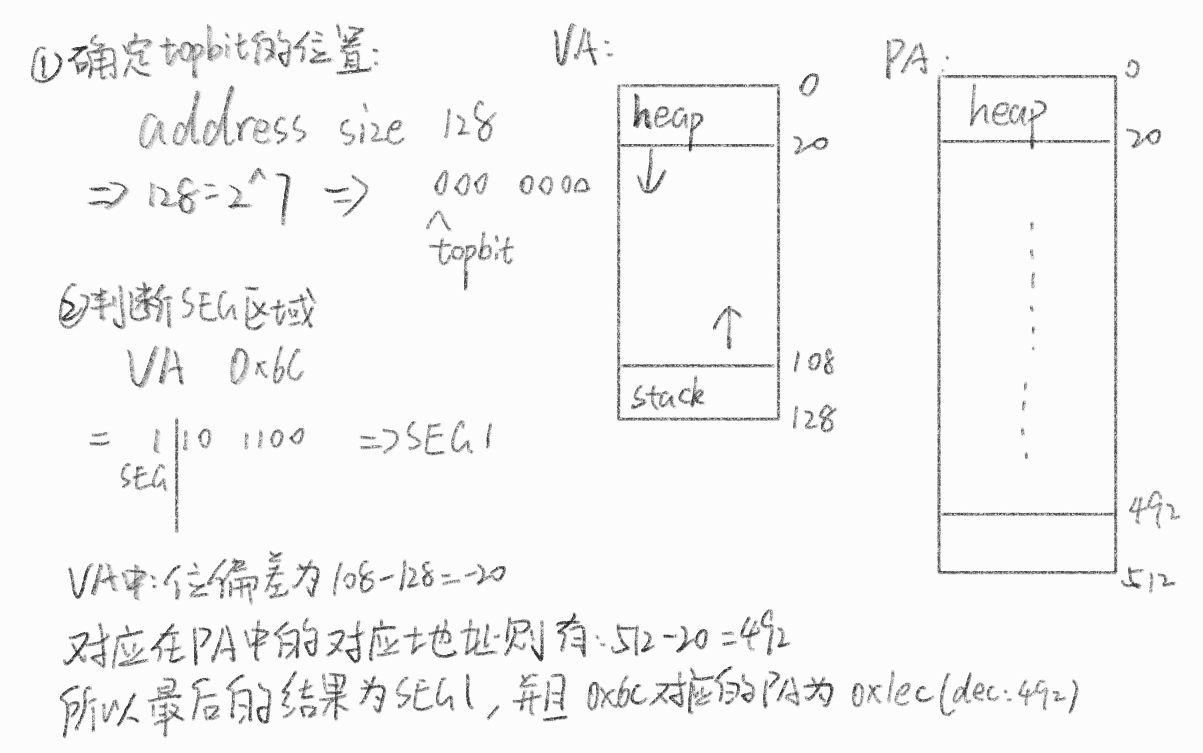

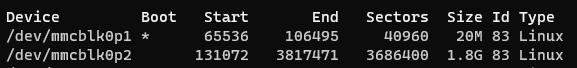

Page Size: 32 bytes Virtual Address Space:32 KB(1024个分页 2^15)虚拟地址需要 15 bits (VPN 占 10 bit,offset 占 5 bit) Physical Memory: 128个分页(2^12)物理地址需要 12 bits (PFN 占 7bit, offset 占 5 bit ) Virtual Address Space 的前五位对应了Page Directory的索引 通过seed生成0对应的地址数据,用于PDE查表,内容如下

Page Content 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 page 0:1b1d05051d0b19001e00121c1909190c0f0b0a1218151700100a061c06050514

并且根据模拟生成的PDBR: 108可以知道Page 108对应的内容即是第一级PDE的映射

接下来就可以进行计算了,这里取一个vaild和invaild的答案分析计算过程

1 2 3 4 5 6 7 8 Virtual Address 611c:

Virtual Address 611c

将611c按二进制转换为Virtual Address Space对应的 15 bits 为 11000 01000 11100。对PDE分割前五位有11000(decimal 24)

这个时候对最顶层的PDTR对应的Page 108进行查表操作

首先可以通过Page Content得到Page 108内容如下

1 2 Page 108: 83 fe e0 da 7f d4 7f eb be 9e d5 ad e4 ac 90 d6 92 d8 c1 f8 9f e1 ed e9 a1 e8 c7 c2 a9 d1 db ff

通过查表找到对应Index的内容可以知道24(11000)对应位置的内容是a1,转换为二进制为1010 0001,读取最高位为1可以知道是vaild。再通过后面的0010 0001转换为十进制为33,因此再继续查询Page 33的内容

1 2 Page 33:7f 7f 7f 7f 7f 7f 7f 7f b5 7f 9d 7f 7f 7f 7f 7f 7f 7f 7f 7f 7f 7f 7f 7f 7f 7f f6 b1 7f 7f 7f 7f

611c的[1-5]位为PDE,这时我们则需要通过[6-10]位来通过PTE寻找VPN对应的PFN地址。由611c为11000 01000 11100可以知道这次为01000即(decmial 8),对照上面page 33可以发现第八个对应的内容为53,因此可以知道最终VPN对应上了PFN的Page 53。最后再通过offset的11100,配合Page 53对应的二进制PFN地址11 0101结合offset的11100有110101 11100,也就是最后答案的0x6bc,其中通过offset在Page 53中查表可以找到对应的 Value 为 08

Virtual Address 3da8

和611c同理,将3da8转为二进制01111 01101 01000,得到pde index为01111(15),对应的Value为0xd6(1101 0110),通过1101 0110最高位可以知道目标分页为vaild,去掉vaild bit可以得到索引的pte为0x56(0101 0110 | 86)

检索Page 86,由PTE index为01101可以找到对应的Value为0x7f(0111 1111)由于最高位为0,因此是invaild,也就是说pte无效,无法访问

其他的情况也是依次类推,即可算出结果是否有效

根据个人理解,具体缓存hit或miss的概率主要由对应内存上的数据决定。对于访问次数较多的内容hit缓存加快速度的概率自然更高;而对于不重复的多次查询(比如上面的练习),自然miss的概率会更高。因此对于进程来说,如果能将数据尽量集中在某一块分页上则能有效提高内存访问和处理的速度。

+

+ 知识记录

+

+

+

+

+

+

+ OS

+

+

+

+

+

+

+

+

+ OSTEP:TLB缓存命中和非命中的开销差距

+ /p/20416971.html

+

+ 本章为测量实验,主要要求为写一份tlb.c来测试在TLB miss和TLB hit的情况下性能开销的变化,以感受TLB的重要性

对于题中问题的回答

由于gettimeofday()的函数只能精确到微秒,不足以测试较为精确的时间,因此使用CLOCK_PROCESS_CPUTIME_ID和clock_gettime();搭配即可获得纳秒级的时间测量,具体代码实现如下

具体代码实现如下